Escolar Documentos

Profissional Documentos

Cultura Documentos

Algoritmos Clustering

Enviado por

zorroatlasDireitos autorais

Formatos disponíveis

Compartilhar este documento

Compartilhar ou incorporar documento

Você considera este documento útil?

Este conteúdo é inapropriado?

Denunciar este documentoDireitos autorais:

Formatos disponíveis

Algoritmos Clustering

Enviado por

zorroatlasDireitos autorais:

Formatos disponíveis

Algoritmos Clustering

Introduccin

El llevar a cabo un proyecto software, lleva asociado un esfuerzo de dedicacin en cuanto a tiempo y dinero se refiere. El poder estimar, preferiblemente, en las primeras etapas de construccin de software, estos valores, ayuda en gran medida en la consecucin del proyecto. Muchos han sido, desde sus inicios en los aos 40, los proyectos software que han fracasado por una mala planificacin en el tiempo y coste. Es por ello por lo que desde estos primeros momentos surgieron multitud de mtodos de estimacin de coste software, para ayudar en el desarrollo de los mismos. Tantos mtodos de estimacin han sido agrupados en diferentes clasificaciones, la primera se debe a Barry Boehm, en la que clasifica a los mtodos de estimacin de coste software en: modelos algortmicos, juicio de expertos, analoga, parkinson, price to win, topdown y bottom-up. A esta clasificacin le sigue la de DeMarco, la de Conte: modelos histricos-experimentales, modelos estadsticos, modelos tericos, y modelos compuestos. Ms tarde, en 1991 Kitchenham, clasifica en opinin de expertos, analoga, descomposicin, y ecuaciones de estimacin, los diferentes mtodos de estimacin. Fairley en 1992 ofrece esta otra clasificacin, modelos empricos, basados en regresin, y basados en la teora. En 1997, Walkerden y Jeffery nos ofrecen otra clasificacin, modelos empricos paramtricos, modelos empricos no-paramtricos, modelos analgicos, modelos tericos y modelos hersticos. Recientemente, Barry Boehm ofrece otra clasificacin, actualizacin de la realizada en 1981, en la cual aparecen nuevas clasificaciones, en total tenemos: tcnicas basadas en modelos, tcnicas basadas en expertos, orientados al aprendizaje, modelos dinmicos, modelos basados en tcnicas de regresin, y modelos compuestos-bayesianos. Dentro de los mtodos orientadas al aprendizaje, Boehm menciona las redes neuronales y el estudio de casos (originados a partir de los modelos por analoga). Por ltimo, en el ao 2001, Wieczorek clasifica los mtodos de estimcin en, mtodos basados en modelos y mtodos no-basados en modelos, dentro de los primeros tenemos genricos (propietarios y no propietarios) y especficos (conducidos por los datos y compuestos). Si nos centramos en los mtodos orientados al aprendizaje, segn la clasificacin de 2001 de Boehm, actualmente adems de las redes neuronales y el razonamiento basado en casos (CBR) (Shepperd), se estn aplicando otras tcnicas de machine learning para intentar mejorar el proceso de estimacin, sobre los proyectos actuales, que revisten una gran complejidad. Tales tcnicas son las de programacin gentica, sistemas fuzzy, induccin de reglas, CART (Classification and Regression Trees) y combinaciones de stas. Ejemplos de ello, pueden ser los artculos de Ali Idri, en los que aplica sistemas difusos combinados con analogas, o los de Dolado en los que utiliza programacin gentica para estimar el costo software. En el caso de induccin de reglas, C. Mair compara esta tcnica con redes neuronales y razonamiento basado en casos en L. Briand, ha realizado diferentes anlisis y comparativas, en las que interviene CART. Y por ltimo

mencionar el artculo de A. Lee, en el que se utilizan tcnicas de clustering para el entrenamiento de una red neuronal en la estimacin de coste software.

2. Clustering

El proceso de Clustering consiste en la divisin de los datos en grupos de objetos similares. Para medir la similaridad entre objetos se suelenutilizar diferentes formas de distancia: distancia eucldea, de Manhatan, de Mahalanobis, etc. El representar los datos por una serie de clusters, conlleva la prdida de detalles, pero consigue la simplificacin de los mismos. Clustering es una tcnica ms de Machine Learning, en la que el aprendizaje realizado es no supervisado (unsupervised learning). Desde un punto de vista prctico, el clustering juega un papel muy importante en aplicaciones de data mining, tales como exploracin de datos cientficos, recuperacin de la informacin y minera de texto, aplicaciones sobre bases de datos espaciales (tales como GIS o datos procedentes de astronoma), aplicaciones Web , marketing, diagnstico mdico, anlisis de ADN en biologa computacional, y muchas otras. En el presente trabajo lo utilizaremos como complemento a los modelos matemticos, en la estimacin de coste software. Una gran variedad de algoritmos de clustering han surgido en los ltimos aos, los cuales se pueden clasificar en: Mtodos Jerrquicos o Algoritmos Aglomerativos o Algoritmos Divisivos Mtodos de Particionado y Recolocacin o Clustering Probabilstico o Mtodos de los k-vecinos (k-medoids) o Mtodos de las k-medias o Algoritmos Basados en Densidad Clustering de Conectividad Basada en Connectivity Clustering. Clustering basado en Funciones de Densidad Mtodos Basados en Rejillas Mtodos Basados en la Co-Ocurrencia de Datos Categricos Clustering Basado en Restricciones Algoritmos para Datos de Grandes Dimensiones Clustering Subespacial Tcnicas de Co-Clustering

Densidad

Density-Based

2.1. COBWEB Se trata de un algoritmo de clustering jerrquico. COBWEB, se caracteriza porque utiliza aprendizaje incremental, esto es, realiza las agrupaciones instancia a instancia. Durante la ejecucin del algoritmo se forma un rbol (rbol de clasificacin) donde las hojas representan los segmentos y el nodo raz engloba por completo el conjunto de datos de entrada. Al principio, el rbol consiste en un nico nodo raz. Las instancias se van aadiendo una a una y el rbol se va actualizando en cada paso. La actualizacin consiste en encontrar el mejor sitio donde incluir la nueva instancia, operacin que puede necesitar de la reestructuracin de todo el rbol (incluyendo la generacin de un nuevo nodo anfitrin para la instancia y/o la fusin/particin de nodos existentes) o simplemente la inclusin de la instancia en un nodo que ya exista. La clave para saber cmo y dnde se debe actualizar el rbol la proporciona una medida denominada utilidad de categora, que mide la calidad general de una particin de instancias en un segmento. La reestructuracin que mayor utilidad de categora proporcione es la que se adopta en ese paso. El algoritmo es muy sensible a otros dos parmetros: Acuity Este parmetro es muy necesario, ya que la utilidad de categora se basa en una estimacin de la media y la desviacin estndar del valor de los atributos, pero cuando se estima la desviacin estndar del valor de un atributo para un nodo en particular, el resultado es cero si dicho nodo slo contiene una instancia. As pues, el parmetro acuity representa la medida de error de un nodo con una sola instancia, es decir, establece la varianza mnima de un atributo. Cut-off Este valor se utiliza para evitar el crecimiento desmesurado del nmero de segmentos. Indica el grado de mejora que se debe producir en la utilidad de categora para que la instancia sea tenida en cuenta de manera individual. En otras palabras: cuando no es suficiente el incremento de la utilidad de categora en el momento en el que se aade un nuevo nodo, ese nodo se corta, conteniendo la instancia otro nodo ya existente. Adems COBWEB pertenece a los mtodos de aprendizaje conceptual o basados en modelos. Esto significa que cada cluster se considera como un modelo que puede describirse intrinsicamente, ms que un ente formado por una coleccin de puntos. Al algoritmo COBWEB no hay que proporcionarle el nmero exacto de clusters que que remos, sino que en base a los parmetros anteriormente mencionados encuentra el nmero ptimo. La implementacin utilizada en el presente trabajo, de este algoritmo es la de Weka. 2.2. EM EM pertenece a una familia de modelos que se conocen como Finite Mixture Models, los cuales se pueden utilizar para segmentar conjuntos de datos. Dentro de la clasificacin de la seccin 2, encajara dentro de los Mtodos de Particionado y Recolocacin, en concreto Clustering Probabilstico. Se trata de obtener la FDP (Funcin de Densidad de Probabilidad) desconocida a la que pertenecen el conjunto completo de datos. Esta FDP se puede aproximar mediante una

combinacin lineal de NC componentes, definidas a falta de una serie de parmetros {} que son los que hay que averiguar,

Donde pi j son las probabilidades apriori de cada cluster cuya suma debe ser 1, que tambin forman parte de la solucin buscada, P(x) de nota la FDP arbitraria y p(x; j) la funcin de densidad del componente j. Cada clster se corresponde con las respectivas muestras de datos que pertenecen a cada una de las densidades que se mezclan. Se pueden estimar FDP de formas arbitrarias, utilizndose FDP normales n-dimensionales, t-Student, Bernoulli, Poisson, y lognormales. Aqu se modelarn los datos mediante distribuciones normales, por ser stas las ms comunes. El ajuste de los parmetros del modelo requiere alguna medida de su bondad, es decir, cmo de bien encajan los datos sobre la distribucin que los representa. Este valor de bondad se conoce como el likelihood de los datos.Se tratara entonces de estimar los parmetros buscados , maximizando este likelihood (este criterio se conoce como ML-Maximun Likelihood). Normalmente, lo que se calcula es el logaritmo de este likelihood, conocido como log-likelihood ya que es ms fcil de calcular de forma analtica. La solucin obtenida es la misma, gracias a la propiedad de mono tonicidad del logaritmo. La forma de esta funcin log-likelihood es:

Donde NI es el nmero de instancias, que suponemos independientes entre si. El algoritmo EM, procede en dos pasos que se repiten de forma iterativa: Expectation Utiliza los valores de los parmetros, iniciales o proporcionados por el paso Maximization de la iteracin anterior, obteniendo diferentes formas de la FDP buscada. Maximization Obtiene nuevos valores de los parmetros a partir de los datos proporcionados por el paso anterior. Despus de una serie de iteraciones, el algoritmo EM tiende a un mximo local de la funcin L.

Finalmente se obtendr un conjunto de clusters que agrupan el conjunto de proyectos original. Cada uno de estos cluster estar definido por los parmetros de una distribucin normal. La implementacin utilizada no es la de Weka, ya que la implementacin que lleva a cabo del algoritmo EM lleva asociada la premisa de la independencia de los atributos utilizados, nada ms lejos de la realidad existente entre el esfuerzo y los puntos de funcin. Por lo tanto se ha desarrollado una implementacin de EM en lenguaje C que se adapta mucho mejor a las caractersticas del problema de estimacin de coste software. Para una mayor descripcin de la misma se puede consultar. 2.3. K-medias Se trata de un algoritmo clasificado como Mtodo de Particionado y Recolocacin. El mtodo de las k-medias, es hasta ahora el ms utilizado en aplicaciones cientficas e industriales. El nombre le viene porque representa cada uno de los clusters por la media (o media ponderada) de sus puntos, es decir, por su centroide. Este mtodo nicamente se puede aplicar a atributos numricos, y los outliers le pueden afectar muy negativamente. Sin embargo, la representacin mediante centroides tiene la ventaja de que tiene un significado grfico y estadstico inmediato. La suma de las discrepancias entre un punto y su centroide, expresado a travs de la distancia apropiada, se usa como funcin objetivo. La funcin objetivo, suma de los cuadrados de los errores entre los puntos y sus centroides respectivos, es igual a la varianza total dentro del propio cluster. La suma de los cuadrados de los errores se puede razionalizar, como el negativo del log-likelihood, para modelos mixtos que utilicen distribuciones normales. Por lo tanto, el mtodo de las k-medias se puede derivar a partir del marco probabilstico (ver subseccin Clustering Probabilstico del libro de Mitchell). Existen dos versiones del mtodo de las k-medias. La primera es parecida al algoritmo EM, y se basa en dos pasos iterativos: primero reasigna todos los puntos a sus centroides ms cercanos, y en segundo lugar recalcula los centroides de los nuevos grupos creados en el anterior. El proceso contina hasta alcanzar un criterio de parada (por ejemplo que no se realicen nuevas reasignaciones). Esta versin se conoce como algoritmo de Forgy. La segunda versin reasigna los puntos basndose en un anlisis ms detallado de los efectos causados sobre la funcin objetivo al mover un punto de su cluster a otro nuevo. Si el traslado es positivo, se realiza, en caso contrario se queda como est. A diferencia de los anteriores algoritmos, COBWEB y EM, k-medias necesita la previa especificacin del nmero de clusters que se desean obtener.La implementacin utilizada en el presente trabajo, de este algoritmo es tambin la ofrecida por Weka.

3. Caso de Estudio

Para realizar el estudio de los diferentes algoritmos de clustering, primero es preciso realizar un filtrado de los proyectos de la base de datos ISBSG, que ser utilizada. Esto se har en la seccin 3.1. Una vez preparados los datos, se aplican los algoritmos COBWEB, EM y k-medias, sobre los

mismos, obtenindose unos resultdos que se ofrecen en la seccin 3.2. La comparacin de estos resultados se ver en la seccin 3.3.

3.1. Preparacin de los datos Se utiliz la base de datos de proyectos ISBSG-8, la cual contiene informacin sobre 2028 proyectos. Esta base de datos contiene informacin sobre tamao, esfuerzo, y otras caractersticas de un proyecto. El primer paso de limpieza consisti en eliminar de la base de datos todos los proyectos con valores numricos no vlidos o nulos en los campos esfuerzo (Summary Work Effort en ISBSG-8) y tamao (Function Points en ISBSG-8). Adems todos los proyectos cuyo valor para el atributo Recording Method fuese distinto de Staff Hours tambin fueron eliminados. La razn es que se considera que el resto de formas de considerar el esfuerzo son subjetivas. Por ejemplo Productive Time es una magnitud difcil de valorar en un contexto organizativo. Otro aspecto a tener en cuenta para la limpieza de los datos es la forma en la que se obtuvieron los diferentes valores de los puntos de funcin. En concreto se examin el valor del atributo Derived count approach, descartan do todos los proyectos que no hubiesen utilizado como forma de estimar los puntos de funcin mtodos como IFPUG, NESMA, Albretch o Dreger. Las diferencias entre los mtodos IFPUG y NESMA tienen un impacto despreciable sobre los resultados de los valores de los puntos de funcin. Las mediciones basadas en las tcnicas Albretch no se eliminaron ya que, de hecho IFPUG es una revisin de estas tcnicas. De la misma forma el mtodo Dreger [30] es simplemente una gua sobre las mediciones IFPUG. Por ltimo se procede a la eliminacin de los proyectos con valores nulos para el atributo tiempo (Project Elapsed Time). Finalmente el estudio se realiza sobre una base de datos de 1569 proyectos.

3.2. Aplicacin de los algoritmos de clustering En esta seccin veremos los resultados que se obtienen al aplicar los tres algoritmos de clustering bajo estudio, sobre la base de datos ISBSG, una vez preparados los datos, como hemos visto en la seccin 3.1. 3.2.1. COBWEB Este algoritmo admite dos parmetros, como hemos visto en la seccin 2.1, cutoff y acuity. Los valores que Weka propone para stos es de acuity=1.0 y cutoff=0.0028209479177387815. Con estos valores no se obtiene ningn cluster, por lo que es necesario modificarlos. Segn el significado del cutoff parece lgico el decrementar este valor, para obtener un mayor nmero de clusters, para ello se le asigna un valor de cutoff=0.00028209479177387815. Obtenindose los siguientes resultados: Nmero de fusiones: 386. Nmero de divisiones: 896. Nmero de clusters: 1792.

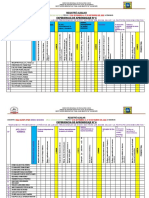

Figura 1: Clusters obtenidos por el algoritmo COBWEB.

De los 1792 clusters, 1593 estn formados por un elemento, y los restantes por ninguno. El nmero tan elevado de clusters hace pensar que el valor elegido no es el ms adecuado, es necesario incrementarlo. Tras varios intentos se utiliza un valor de cutoff=0.0018750338970421, el cual ofrece unos resultados aceptables: Nmero de fusiones: 283. Nmero de divisiones: 222. Nmero de clusters: 95.

Se hicieron nuevas intentonas, pero ninguna dio un nmero de clusters menor. Todos los resultados coincidian en lo siguiente: se obtienen 94 clusters que cubren 114 proyectos repartidos uniformemente, mientras que el cluster restante engloba a 1479 proyectos. En la figura 1 se puede ver el cluster ms importante. La escala de esta figura, as como las siguientes, es logartmica, para poder apreciar mejor la forma de los segmentos obtenidos. Los valores de MMRE y PRED(.3) son los que se muestran en el cuadro 1. Estos valores resultan de utilizar la recta de regresin del cluster obtenido, cuyos coeficientes a y b tambin se ofrecen en dicho cuadro.

Cuadro 1: Valores MMRE y PRED(.3) para COBWEB.

3.2.2. EM Este algoritmo proporciona una segmentacin de los proyectos en 9 clusters. La representacin grfica se puede ver en la figura 2.

Figura 2: Clusters obtenidos por el algoritmo EM. Los valores de los parmetros se ofrecen a continuacin en los cuadros 2, 3 y 4. Los valores de MMRE y PRED(.3) han resultado utilizando las respectivas rectas de regresin de cada cluster, cuyos coeficientes a y b tambin se ofrecen en dichos cuadros. Para el cluster 9, formado nicamente por 20 proyectos no se realiza ningn anlisis por consider que los resultados ofrecidos no seran fidedignos, por el pequeo nmero de elementos de este segmento.

Cuadro 2: Resultados del algoritmo EM. Clusters 1, 2 y 3

Cuadro 3: Resultados del algoritmo EM. Clusters 4, 5 y 6.

3.2.3. K-medias Al algoritmo de las k-medias hay que proporcionarle de antemano el nmero de clusters en los que queremos que se segmente la base de proyectos. Este dato se obtiene a partir del algoritmo EM, ya que ste obtiene este dato de forma ptima (vease [3]). Por lo tanto el algoritmo de kmedias se aplica sobre la base de datos de proyectos ISBSG para un nmero de clusters de 9 y un valor para la semilla de 10. La representacin grfica de los clusters obtenidos se puede ver en la figura 3. En este caso, el nmero de elementos por cluster es el siguiente: cluster 1, 4 proyectos;

Cuadro 4: Resultados del algoritmo EM. Clusters 7, 8 y 9.

Figura 3: Clusters obtenidos por el algoritmo de k-medias. cluster 2, 12 proyectos; cluster 3, 3 proyectos; cluster 4, 11 proyectos; cluster 5, 920 proyectos; cluster 6, 361 proyectos; cluster 7, 74 proyectos; cluster 8, 28; y cluster 9, 156. Por lo tanto, solamente se analizarn los clusters 5, 6, 7, 8 y 9, los restantes se descartan por tener un nmero de proyectos muy pequeo. Al igual que en el caso anterior, podemos ver los resultados de aplicar este algoritmo, tras 50 iteraciones, en los cuadros 5 y 6. Igualmente, los valores de MMRE y PRED(.3) han resultado utilizando las respectivas rectas de regresin de cada cluster.

Cuadro 5: Resultados del algoritmo k-medias. Clusters 5, 6 y 7

Cuadro 6: Resultados del algoritmo k-medias. Clusters 8 y 9.

3.3. Comparacin de los resultados obtenidos Si se comparan los valores de MMRE y PRED(.3) de los clusters obtenidos por los algoritmos bajo estudio, se observa que el mtodo EM destaca sobre los otros dos. COBWEB ofrece un nico cluster significativo, con resultados no muy diferentes de los que se obtendran sin realizar segmentacin alguna, considerando todos los proyectos para una nica curva de regresin. De hecho el cluster obtenido es una representacin de toda la base de datos, eliminando algunos outliers. EM y k-medias ofrecen segmentos de similares formas, aunque han agrupado los proyectos de diferente foma, ver figuras 2 y 3. Ello se debe al hecho de que ambos forman parte de una misma familia de algoritmos de clustering y tienen bases comunes. Sin embargo EM destaca claramente sobre k-medias, ofreciendo mucho mejores valores de MMRE y PRED(.3).

Você também pode gostar

- Análisis y diseño de algoritmos: Un enfoque prácticoNo EverandAnálisis y diseño de algoritmos: Un enfoque prácticoAinda não há avaliações

- UF2213 - Modelos de datos y visión conceptual de una base de datosNo EverandUF2213 - Modelos de datos y visión conceptual de una base de datosAinda não há avaliações

- La Aceptacion de Si Mismo - Romano Guardini PDFDocumento9 páginasLa Aceptacion de Si Mismo - Romano Guardini PDFmindyAinda não há avaliações

- UF1471 - Bases de datos relacionales y modelado de datosNo EverandUF1471 - Bases de datos relacionales y modelado de datosAinda não há avaliações

- Bases de datos relacionales y modelado de datos. IFCT0310No EverandBases de datos relacionales y modelado de datos. IFCT0310Ainda não há avaliações

- Aprendizaje Automático Capítulo 1Documento308 páginasAprendizaje Automático Capítulo 1Cristian FloresAinda não há avaliações

- Guia-Didactica Machine LearningDocumento113 páginasGuia-Didactica Machine LearningAndres SantmarAinda não há avaliações

- Aprendizaje AutomáticoDocumento3 páginasAprendizaje AutomáticonormamarlenamartinezAinda não há avaliações

- Modelado y simulación de redes. Aplicación de QoS con opnet modelerNo EverandModelado y simulación de redes. Aplicación de QoS con opnet modelerAinda não há avaliações

- Aprendizaje Supervisado y No SupervisadoDocumento4 páginasAprendizaje Supervisado y No SupervisadoDARWIN RODOLFO DAVILA FERNANDEZ100% (1)

- Aprendizaje Supervisado PDFDocumento16 páginasAprendizaje Supervisado PDFAndrés Castro MamaniAinda não há avaliações

- Técnicas de Aprendizaje AutomáticoDocumento15 páginasTécnicas de Aprendizaje AutomáticoJorge cedeñoAinda não há avaliações

- Smart Grids y Evolucion de La Red ElectricaDocumento82 páginasSmart Grids y Evolucion de La Red ElectricanairoluisAinda não há avaliações

- Presentacion PPT - Ruido, Iluminación y VentilaciónDocumento35 páginasPresentacion PPT - Ruido, Iluminación y VentilaciónZoe MtAinda não há avaliações

- Hacia Una Antropologia Desde La Epifanía Del Rostro en Emmanuel LévinasDocumento56 páginasHacia Una Antropologia Desde La Epifanía Del Rostro en Emmanuel Lévinasmanueldc100% (20)

- Compressors STC Portfolio Esp (Exposicion 3)Documento8 páginasCompressors STC Portfolio Esp (Exposicion 3)Luis Francisco Palma ZentAinda não há avaliações

- Lección 8 - Tipos de Algoritmos de Agrupamiento y Reglas de AsociaciónDocumento5 páginasLección 8 - Tipos de Algoritmos de Agrupamiento y Reglas de AsociaciónGabriel GutierrezAinda não há avaliações

- Tecnicas de Clustering en Machine LearningDocumento12 páginasTecnicas de Clustering en Machine LearningFernan FortichAinda não há avaliações

- Evaluación de algoritmos de regresiónDocumento16 páginasEvaluación de algoritmos de regresiónFelipão GonçalezAinda não há avaliações

- Algoritmo KNNDocumento8 páginasAlgoritmo KNNAlexis Sangoquiza AvilésAinda não há avaliações

- Monografia John OrtizDocumento10 páginasMonografia John OrtizJohn Lenin Ortiz GambaAinda não há avaliações

- Metodologias para La Gestion de Procesos de Mineria de DatosDocumento9 páginasMetodologias para La Gestion de Procesos de Mineria de Datoszap10863Ainda não há avaliações

- Exposicion Metodos de Clasificacion y Prediccion RDocumento48 páginasExposicion Metodos de Clasificacion y Prediccion RJesus Alberto Quishpe GrandaAinda não há avaliações

- Algoritmos de agrupamiento y clasificación para predecir divorcioDocumento2 páginasAlgoritmos de agrupamiento y clasificación para predecir divorcioJONATHAN MIGUEL AISALLA GUANOLUISAAinda não há avaliações

- Weka Segundo ProductoDocumento8 páginasWeka Segundo ProductoCarli Greff BlackerAinda não há avaliações

- Unidad 4Documento15 páginasUnidad 4Gabby GuerraAinda não há avaliações

- Guía Tercer PDocumento5 páginasGuía Tercer POscar HuAinda não há avaliações

- Modelos de Data MiningDocumento6 páginasModelos de Data MiningOmar Jhonatan Huamanchumo OrtizAinda não há avaliações

- Tema 3Documento75 páginasTema 3Patricia CamposAinda não há avaliações

- Aplicacion Algoritmos WekaDocumento11 páginasAplicacion Algoritmos WekacristhianMarceloAinda não há avaliações

- Aprendizaje AutomáticoDocumento5 páginasAprendizaje AutomáticoWrtAinda não há avaliações

- Ok - Algoritmos de Aprendizaje KNN & KmeansDocumento8 páginasOk - Algoritmos de Aprendizaje KNN & KmeansBladimir GarciaAinda não há avaliações

- Modelado orientado a objetosDocumento6 páginasModelado orientado a objetosBRET SILVERAinda não há avaliações

- Bigdata - Semana 07aDocumento22 páginasBigdata - Semana 07ajvila1990Ainda não há avaliações

- Clustering y reducción dimensional en datos proteínicosDocumento10 páginasClustering y reducción dimensional en datos proteínicosVALERIA GONZALEZ ARAYAAinda não há avaliações

- Regularización paramétrica: conceptos básicos de MLDocumento27 páginasRegularización paramétrica: conceptos básicos de MLivan hernandez rodriguezAinda não há avaliações

- Clase 08 - Parte I - Modelos Analíticos para DS IIDocumento15 páginasClase 08 - Parte I - Modelos Analíticos para DS IIPaul VásquezAinda não há avaliações

- Metodología CRISPDocumento10 páginasMetodología CRISPDaniel AlejandroAinda não há avaliações

- MetricasdedesarrollodesoftwareDocumento5 páginasMetricasdedesarrollodesoftwarebrayan danilo ortizAinda não há avaliações

- Reducción de dimensionalidad y selección de características (39Documento29 páginasReducción de dimensionalidad y selección de características (39Helena GomezAinda não há avaliações

- wk3 Written Assign Mbad6520Documento5 páginaswk3 Written Assign Mbad6520nicole caminadaAinda não há avaliações

- 2 Metodos de Agregacion de Modelos y Aplicaciones PDFDocumento14 páginas2 Metodos de Agregacion de Modelos y Aplicaciones PDFRoberto ZZZAinda não há avaliações

- Evaluación de Algoritmos SupervisadosDocumento5 páginasEvaluación de Algoritmos SupervisadosSandra Patricia BarretoAinda não há avaliações

- Sesion 4Documento25 páginasSesion 4David LinaresAinda não há avaliações

- Parte 3Documento16 páginasParte 3DominikAinda não há avaliações

- 1.presentacion IntroduccionDocumento4 páginas1.presentacion IntroduccionCarlos NavarroAinda não há avaliações

- Algoritmos de aprendizaje automático: Supervisado, no supervisado, refuerzo y semi supervisadoDocumento14 páginasAlgoritmos de aprendizaje automático: Supervisado, no supervisado, refuerzo y semi supervisadoJeison Andres Maldonado OrjuelaAinda não há avaliações

- Ddiazbarbosa Document 2Documento18 páginasDdiazbarbosa Document 2david parradoAinda não há avaliações

- CONCEPTOS 2.4. DataMining o Mineria de DatosDocumento6 páginasCONCEPTOS 2.4. DataMining o Mineria de DatosFedrftg PedrftgyAinda não há avaliações

- Análisis dimensionalidadDocumento35 páginasAnálisis dimensionalidadOrlando SotoAinda não há avaliações

- Estudio de CasoDocumento15 páginasEstudio de CasoJesus SotoAinda não há avaliações

- Aprendizaje Automático: ÍndiceDocumento10 páginasAprendizaje Automático: ÍndicecarAinda não há avaliações

- Pnatilla Tópicos EspecialesDocumento2 páginasPnatilla Tópicos EspecialesJONATHAN MIGUEL AISALLA GUANOLUISAAinda não há avaliações

- Cuestionario Unidad 2Documento7 páginasCuestionario Unidad 2Gustavo Fuentes CordovaAinda não há avaliações

- Aprendizaje AutomaticoDocumento4 páginasAprendizaje AutomaticoLaura AguileraAinda não há avaliações

- Fuzzy Minimals ClusteringDocumento25 páginasFuzzy Minimals ClusteringRonald RisAinda não há avaliações

- Aprendizaje AutomaticoDocumento15 páginasAprendizaje Automaticowilliam david calsin bordaAinda não há avaliações

- 2.3 Métricas Orientadas A Clases, Exposición Ing - Soft. IIDocumento24 páginas2.3 Métricas Orientadas A Clases, Exposición Ing - Soft. IISamir Morales0% (1)

- Reconocimiento de PatronesDocumento9 páginasReconocimiento de Patronesbryan saul choqueAinda não há avaliações

- C4 AnalisisDatosYaprendizaAutomaticoDocumento15 páginasC4 AnalisisDatosYaprendizaAutomaticoFernando AndresAinda não há avaliações

- Aprendizaje AutomáticoDocumento9 páginasAprendizaje Automáticofernando canoAinda não há avaliações

- RESUMEN Aprendiaje AutomaticoDocumento15 páginasRESUMEN Aprendiaje AutomaticojairojamaicaAinda não há avaliações

- Tarea 3 Alvaro GallardoDocumento4 páginasTarea 3 Alvaro GallardoAlvaro Gallardo FernandezAinda não há avaliações

- Machine LearningDocumento12 páginasMachine LearningIttzel MachadoAinda não há avaliações

- Almacenamiento MasivoDocumento10 páginasAlmacenamiento MasivozorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Sensibilidad Al ContextoDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Sensibilidad Al ContextozorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Inteligencia AmbientalDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Inteligencia AmbientalzorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Redes ConvergentesDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Redes ConvergenteszorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Next Generation NetworkingDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Next Generation NetworkingzorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Generación CristalDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Generación CristalzorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Age of ContextDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Age of ContextzorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Proyecto GaiaDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Proyecto GaiazorroatlasAinda não há avaliações

- Au3cm40 Roque Crisostomo Rogelio ZigbeeDocumento2 páginasAu3cm40 Roque Crisostomo Rogelio ZigbeezorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Institute For Pervasive ComputingDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Institute For Pervasive ComputingzorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Computación GridDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Computación GridzorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Pervasive ComputingDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Pervasive ComputingzorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Cómputo en La NubeDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Cómputo en La NubezorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Contrato AppDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Contrato AppzorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-FenómenoDocumento1 páginaAu3cm40-Roque Crisostomo Rogelio-FenómenozorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-FenómenoDocumento1 páginaAu3cm40-Roque Crisostomo Rogelio-FenómenozorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Sistemas EmbebidosDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Sistemas EmbebidoszorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Ambiente UbicuoDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Ambiente UbicuozorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Realidad AumentadaDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Realidad AumentadazorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Ion GlassesDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Ion GlasseszorroatlasAinda não há avaliações

- Juega ConmigoDocumento10 páginasJuega ConmigozorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Redes Sociales VS Computación UbicuaDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Redes Sociales VS Computación UbicuazorroatlasAinda não há avaliações

- Un Modelo de Entorno para El Aprendizaje UtilizandoDocumento8 páginasUn Modelo de Entorno para El Aprendizaje UtilizandozorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Proyecto New Songdo CityDocumento1 páginaAu3cm40-Roque Crisostomo Rogelio-Proyecto New Songdo CityzorroatlasAinda não há avaliações

- RFIDDocumento12 páginasRFIDzorroatlasAinda não há avaliações

- Fundamentos de Mercadotecnia.Documento91 páginasFundamentos de Mercadotecnia.zorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Green ComputingDocumento2 páginasAu3cm40-Roque Crisostomo Rogelio-Green ComputingzorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Computación UrbanaDocumento1 páginaAu3cm40-Roque Crisostomo Rogelio-Computación UrbanazorroatlasAinda não há avaliações

- Au3cm40-Roque Crisostomo Rogelio-Computación UrbanaDocumento1 páginaAu3cm40-Roque Crisostomo Rogelio-Computación UrbanazorroatlasAinda não há avaliações

- Electiva Actividad 7Documento26 páginasElectiva Actividad 7nora pinzonAinda não há avaliações

- Estabilización de TaludesDocumento4 páginasEstabilización de TaludesGama NucamendiiAinda não há avaliações

- Hoja Resumen-Los EsponsalesDocumento2 páginasHoja Resumen-Los EsponsalesLuisaPlasenciaAinda não há avaliações

- IF7 - Espinoza-CCoyoriDocumento24 páginasIF7 - Espinoza-CCoyoriMARIO ALBERTO CCOYORI MENDOZAAinda não há avaliações

- Gráficas SeminarioDocumento10 páginasGráficas SeminarioVega DamariAinda não há avaliações

- Act, 1 Presaberes AutomatasDocumento15 páginasAct, 1 Presaberes AutomatasAlain GenesAinda não há avaliações

- Canon 2015Documento11 páginasCanon 2015Guido PellegrinoAinda não há avaliações

- Oratoria JuridicaDocumento1 páginaOratoria JuridicaJean Carlos FerraraAinda não há avaliações

- Los Intereses Argentinos en La Guerra Por Juan B Alberdi - Portalguarani PDFDocumento32 páginasLos Intereses Argentinos en La Guerra Por Juan B Alberdi - Portalguarani PDFPortal GuaraniAinda não há avaliações

- Rituales Oscuros - Elkin CordobaDocumento480 páginasRituales Oscuros - Elkin CordobaHarold MartinezAinda não há avaliações

- Metodologia de Investigacion-Cineplanet Version 14Documento25 páginasMetodologia de Investigacion-Cineplanet Version 14Luz Maria Cipriano PujayAinda não há avaliações

- 200 Tareas Terapia BreveDocumento5 páginas200 Tareas Terapia BrevePremarthi PrabhuAinda não há avaliações

- Cómo Funciona El ProtoboardDocumento3 páginasCómo Funciona El ProtoboardJonathan CoyagoAinda não há avaliações

- Técnicas e Instrumentos para Recolección de DatosDocumento4 páginasTécnicas e Instrumentos para Recolección de DatosAnayelii MoOralezAinda não há avaliações

- Presentacion Placas HuellasDocumento15 páginasPresentacion Placas Huellasdaka59012Ainda não há avaliações

- Matemáticas: Serie ResuelveDocumento34 páginasMatemáticas: Serie ResuelveMarcelo LiraAinda não há avaliações

- Los textos informativosDocumento7 páginasLos textos informativosJuan PabloAinda não há avaliações

- Procesos Psicológicos 252CDocumento14 páginasProcesos Psicológicos 252Cscarlet sanchezAinda não há avaliações

- Resumen EjecutivoDocumento15 páginasResumen Ejecutivoestefani yanquenAinda não há avaliações

- Tecnicas de Negociacion Del Modulo N. 5 de La Universidad Tecnológica de Honduras UTHDocumento7 páginasTecnicas de Negociacion Del Modulo N. 5 de La Universidad Tecnológica de Honduras UTHjojse alvarenga100% (2)

- Calculo de AreasDocumento6 páginasCalculo de AreasChelo Rodriguez Lazarte100% (1)

- La FamiliaDocumento3 páginasLa FamiliaOsmerysAzocarAinda não há avaliações

- Registró Auxiliar 6 EdaDocumento6 páginasRegistró Auxiliar 6 EdaWalter Quispe AymaAinda não há avaliações

- Empatía, altruismo y solidaridadDocumento9 páginasEmpatía, altruismo y solidaridadnewman135_277960859Ainda não há avaliações

- Historia de SonyDocumento5 páginasHistoria de SonyAlonzo Maz Na PereaAinda não há avaliações