Escolar Documentos

Profissional Documentos

Cultura Documentos

Metaheuristicas y Redes Neuronales

Enviado por

Cristian ReyesTítulo original

Direitos autorais

Formatos disponíveis

Compartilhar este documento

Compartilhar ou incorporar documento

Você considera este documento útil?

Este conteúdo é inapropriado?

Denunciar este documentoDireitos autorais:

Formatos disponíveis

Metaheuristicas y Redes Neuronales

Enviado por

Cristian ReyesDireitos autorais:

Formatos disponíveis

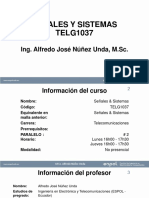

Metaheursticas y Redes Neuronales ESPOL, 2015/ 1

Metaheursticas y Redes Neuronales

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 2

Contenido

1. Introduccin .......................................................................................................................... 5

1.1 Conceptos bsicos de grafos y redes ............................................................................ 5

1.2 Grafos y redes con Mathematica ................................................................................ 11

2. Los mtodos heursticos...................................................................................................... 12

2.1 Definicin y propiedades de los mtodos heursticos ................................................ 12

2.2 Tipos de mtodos heursticos ..................................................................................... 15

2.2.1 Mtodos de Descomposicin ............................................................................. 15

2.2.2 Mtodos Inductivos ............................................................................................ 16

2.2.3 Mtodos de Reduccin ....................................................................................... 16

2.2.4 Mtodos Constructivos ...................................................................................... 16

2.2.5 Mtodos de Bsqueda Local .............................................................................. 16

2.2.6 Mtodos combinados ......................................................................................... 16

2.2.7 Mtodos metaheursticos .................................................................................. 16

2.3 Problemas Estructurados ............................................................................................ 17

2.3.1 Problema de la Mochila (Knapsack Problem) .................................................... 18

2.3.2 Los problemas de Recubrimiento, empaquetamiento y particionamiento de

Conjuntos ............................................................................................................................ 19

2.3.3 Problema del Agente Viajero (Traveling Salesman Problem) ........................... 23

2.3.4 El Problema de la Asignacin Cuadrtica........................................................... 25

2.3.5 Problema de Asignacin Generalizada .............................................................. 26

2.3.6 Problema de la Ordenacin Lineal ..................................................................... 27

2.4 Medidas de Calidad de un Algoritmo .......................................................................... 28

2.4.1 Comparacin con la solucin ptima ................................................................. 28

2.4.2 Comparacin con una cota ................................................................................. 28

2.4.3 Comparacin con un mtodo exacto truncado ................................................. 29

2.4.4 Comparacin con otros heursticos.................................................................... 29

2.4.5 Anlisis del peor caso (worst case analisys) ...................................................... 29

3. Mtodos Constructivos ....................................................................................................... 30

3.1 Heursticos del Vecino ms Cercano ........................................................................... 30

3.2 Heursticos de Insercin .............................................................................................. 31

3.3 Heursticos Basados en rboles Generadores ............................................................ 33

3.4 Heursticos Basados en Ahorros .................................................................................. 37

4. Mtodos de Bsqueda Local ............................................................................................... 40

4.1 Procedimientos de 2 intercambio ............................................................................... 41

4.2 Procedimientos de k - intercambio ............................................................................. 43

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 3

4.3 Algoritmo de Lin y Kernighan ...................................................................................... 45

5. Mtodos Combinados ......................................................................................................... 49

5.1 Procedimientos Aleatorizados .................................................................................... 49

5.2 Mtodos Multi - Arranque .......................................................................................... 51

6. Mtodo GRASP (Greedy Randomized Adaptive Search Procedures) ................................. 53

6.1 Rencadenamiento de Trayectorias ............................................................................. 55

6.2 Bsqueda en Vecindades Variables ............................................................................ 56

6.3 Resolucin de un caso: implementacin GRASP en FS-scheduling:............................ 57

7. Bsqueda Tab .................................................................................................................... 63

7.1 Descripcin del mtodo de bsqueda tab ................................................................ 63

7.2 Resolucin de un caso: implementacin de Tabu Search para resolver el TSP: ......... 67

7.2.1 Introduccin: ....................................................................................................... 67

7.2.2 Algoritmo ............................................................................................................ 67

7.2.3 Resultados numricos ........................................................................................ 68

8. Recocido Simulado .............................................................................................................. 73

8.1 Origen: ......................................................................................................................... 73

8.2 El algoritmo SA ............................................................................................................ 74

8.3 Ejemplos de aplicacin ................................................................................................ 76

9. Mtodos Evolutivos ............................................................................................................. 77

9.1 Algoritmos Genticos .................................................................................................. 77

9.2 Bsqueda Dispersa (Scatter Search) ........................................................................... 83

10. Mtodos de evolucin diferencial................................................................................... 91

10.1 Introduccin ................................................................................................................ 91

10.2 Optimizacin combinatoria DE basada en permutaciones. ........................................ 92

10.3 Adecuacin de la DE como un optimizador combinatorio.......................................... 92

10.4 DE cannica para problemas de optimizacin contnuos. .......................................... 92

10.5 DE para problemas de optimizacin combinatorios basados en permutaciones. ...... 96

10.6 Enfoque de la indexacin de la posicin relativa o el enfoque Knapsack................... 97

10.6.1 Ejemplos .............................................................................................................. 98

11. Otras metaheursticas: Harmony Search y variantes .................................................... 108

11.1 Introduccin .............................................................................................................. 108

11.2 Descripcin del Proceso de Optimizacin ................................................................. 109

11.3 Pseudocdigo de la Metaheurstica Harmony Search .............................................. 110

11.4 Variantes de la Metaheurstica Harmony Search ...................................................... 111

11.4.1 Improved Harmony Search ............................................................................... 111

11.4.2 Global Best Harmony Search ............................................................................. 111

12. Redes neuronales .......................................................................................................... 111

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 4

22.1 Introduccin .............................................................................................................. 111

22.2 Modelos de neuronas ............................................................................................... 112

22.3 Arquitecturas............................................................................................................. 113

22.4 Reglas de aprendizaje................................................................................................ 114

22.5 Redes neuronales artificiales y los problemas de optimizacin combinatoria ......... 115

22.6 Aproximacin estadstica para el problema de la optimizacin. .............................. 115

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 5

1. Introduccin

El propsito de este curso es introducir los principales mtodos heursticos y metaheursticos

para resolver problemas de optimizacin combinatoria, y como analizar su eficiencia. Desde el

punto de vista prctico esto es muy interesante para la industria, la logstica, el transporte, los

servicios, etc., basta decir que muchos de los problemas que encontramos en la literatura de la

optimizacin combinatoria tienen sus orgenes en muchos problemas de ingeniera y

administracin reales, por ejemplo diseo de las de hospitales, diseo de chips y circuitos

electrnicos, asignacin de tareas, ruteo, diseo de lneas de ensamblaje, secuenciacin de

rdenes de produccin, asignacin de personal y determinacin de turnos, planificacin de

horarios, etc.. Todos estos problemas tienen sus abstracciones en la literatura cientfica, tales

como: Knapsack problem, set covering problem, set partitioning problem, permutation

assignment, travel salesman problem, vehiche routing problem, flow shop problem, job shop

problem, timetabling problem, etc. A lo largo del texto consideraremos algunos de estos

problemas para desarrollar e implementar los algoritmos propuestos.

La mayora de problemas de optimizacin combinatoria pueden ser representados

eficientemente a travs de grafos y redes, por lo que a continuacin se revisan algunos

aspectos relacionados con estos temas:

1.1 Conceptos bsicos de grafos y redes

Grafos Dirigidos: Un grafo dirigido (o dgrafo) = (, ) consiste en un conjunto de nodos

y un conjunto de arcos cuyos elementos son pares ordenados de nodos.

Red Dirigida: Una red dirigida es un grafo dirigido cuyos nodos o arcos tienen asociados

valores numricos tales como costos, capacidades, ofertas, demandas, tiempo etc. En general

se suele representar el nmero de nodos con la letra y al nmero de arcos con .

Grafos no Dirigidos: Un grafo no dirigido, o simplemente grafo, = (, ) consiste en un

conjunto de nodos y un conjunto de aristas cuyos elementos son pares no ordenados de

nodos distintos. En un grafo nos podemos referir a la arista que une a los nodos i-j, como (, )

o como (, ). Un grafo no dirigido permite el flujo en ambas direcciones, es decir desde el

nodo al nodo o viceversa.

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 6

Colas y Cabezas: Un arco dirigido (, ) tiene dos puntos de finalizacin . Nos referiremos

al nodo como la cola del arco y al nodo como su cabeza. Diremos que al arco (, ) emana

del nodo y termina en el nodo . El arco (, ) es incidente a los nodos .

El arco (, ) es un arco saliente del nodo y un arco entrante al nodo . Siempre que el arco

(, ) pertenezca al conjunto A, diremos que el nodo es adyacente al nodo .

Grados: El grado interno de un nodo es el nmero de arcos que llegan al nodo y su grado

externo es el nmero de arcos que salen del nodo. Al sumar el grado interno de un nodo con

su grado externo se obtiene el grado del nodo. Se observa que la suma de los grado interno de

todos los nodos es igual a la suma de todos los grados externos de todos los nodos y ambos

son iguales al nmero de arcos en la red.

Lista de Adyacencia: La lista de arcos de adyacencia () de un nodo i es el conjunto de arcos

que emanan del nodo i, esto es:

() = {(, ) :

SUBGRAFO: Un grafo = (, ) es un subgrafo de = (, ) si y . Diremos

que = (, ) es el subgrafo de inducido por si contiene cada arco de con ambos

puntos de finalizacin en .

Un grafo = (, ) es un subgrafo de expansin de = (, ) si = y .

CAMINO: Un camino (o denominado tambin camino no dirigido) en un grafo dirigido

= (, ) es un subgrafo de que satisface la propiedad que para todo , donde 1

1, se tiene que:

ak= (i k 1 , i k ) A o ak= (i k , i k 1 ) A.

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 7

CAMINO DIRIGIDO: Un camino dirigido es una versin orientada de un camino, en el

sentido de que para dos nodos consecutivos ik e ik+1 en el camino, se tiene que (i k , i k 1 ) A.

Por ejemplo en el siguiente grafo un camino dirigido del nodo 1 al nodo 3 es: 1-2-3-4-5-2-3

RUTA: Una ruta es un camino sin repeticin de nodos. Es posible particionar los arcos de un

camino en dos grupos: los arcos que van hacia delante y los arcos que van hacia atrs. Un arco

(i, j ) en el camino es un arco dirigido hacia delante si la ruta visita al nodo i antes de visitar

al nodo j, de ser contrario es un arco que est dirigido hacia atrs.

RUTA DIRIGIDA: Una ruta dirigida es un camino dirigido en el que no se repiten nodos. Dicho

de otra forma en una ruta dirigida no existen arcos dirigidos hacia atrs. Resulta fcil

almacenar una ruta en una computadora definiendo un ndice pred(j), para todo nodo j en la

ruta.

CICLO: Un ciclo es una ruta i1 i2 - ... ir , junto con el arco (i1 , ir ) o el arco (i r , i1 ) . Nos

referiremos a un ciclo empleando la notacin i1 i2 - ... ir ir. De manera anloga a las rutas

es posible definir arcos dirigidos hacia delante o hacia atrs.

CICLO DIRIGIDO: Un ciclo dirigido es una ruta dirigida i1 i2 - ... ir, junto con el arco (i r , i1 ) .

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 8

GRAFO ACCLICO: Un grafo es acclico si no contiene ciclos dirigidos.

CONECTIVIDAD: Dos nodos , estn conectados si el grafo contiene por lo menos una ruta

desde el nodo al nodo . Un grafo es conectado si cada par de nodos estn conectados. De

otra forma el grafo es desconectado. Nos referimos a los subgrafos conectados de una red

como sus componentes.

CONECTIVIDAD FUERTE: Un grafo conectado est fuertemente conectado si contiene por lo

menos una ruta dirigida desde cada nodo hacia todos los dems nodos.

RBOL: Un rbol es un grafo conectado acclico.

PROPIEDADES DE UN RBOL:

Un rbol de n nodos contiene exactamente n-1 arcos.

Un rbol contiene por lo menos dos nodos hojas, es decir con grado 1.

Cada pareja de nodos de un rbol estn conectados por una ruta nica.

BOSQUE:

Un bosque es un grafo acclico. De manera alternativa un bosque es una coleccin de rboles.

SUBRBOL: Un subrbol es un subgrafo conectado de un rbol.

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 9

RBOLES DE EXPANSIN: Un rbol es un rbol de expansin de si es un subgrafo de

expansin. Cada rbol de expansin de un grafo conectado de n nodos, tienen n-1 arcos.

DEFINICIONES PARA REDES NO DIRIGIDAS:

Las definiciones para redes dirigidas se pueden trasladar hacia las redes no dirigidas. Un arco

no dirigido (, ) tiene dos puntos de finalizacin y , pero la cabeza y la cola del arco no estn

definidos.

Si la red contiene al arco(, ), el nodo es adyacente al nodo y el nodo es adyacente al

nodo . Las listas de nodos y arcos de adyacencia estn definidas de manera similar, con la

diferencia de que el arco (, ) aparece en () y tambin en (). En consecuencia se tiene

que i N

A(i ) 2m .

El grado de un nodo es el nmero de nodos adyacentes al nodo . Los dems conceptos como

caminos, rutas, ciclos, cortaduras y rboles tienen las mismas definiciones para redes no

dirigidas, pero no existen diferencias entre rutas y rutas dirigidas, ciclos y ciclos dirigidos, y as

sucesivamente.

REPRESENTACIONES DE REDES: La resolucin de problemas de redes no solo depende de los

algoritmos empleados, sino tambin de la forma de representar la red en la computadora y el

esquema de almacenamiento empleado para guardar y actualizar los resultados que se vayan

obteniendo.

En la representacin de una red se necesitan dos clases de informacin:

La topologa de la red, es decir la estructura de los nodos y arcos.

Datos de inters como costos, capacidades, ofertas, demandas asociadas con los

nodos y los arcos.

A continuacin se presentan algunas representaciones.

MATRIZ DE INCIDENCIA DE NODOS Y ARCOS: Esta representacin almacena la red como una

matriz de , que contiene una fila por cada nodo, y una columna por cada arco. La

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 10

columna correspondiente al arco (, ) tiene solo dos elementos diferentes de cero, posee un

+1 en la fila correspondiente al nodo y un 1 en la fila correspondiente al nodo .

Esta matriz tiene una estructura particular. De los elementos de la matriz solo 2 son

diferentes de cero, las que toman los valores de +1 y 1 en cada columna. El nmero de

elementos en la fila -sima iguales a +1 representa el grado exterior del nodo y el nmero de

elementos en tal fila iguales a 1 representa el grado interior del nodo .

Debido a que la matriz de incidencia de nodos y arcos contiene pocos elementos diferentes de

cero en relacin al nmero total de elementos, esta representacin requiere del uso de

matrices dispersas o de lo contrario origina algoritmos poco eficientes.

MATRIZ DE ADYACENCIA DE NODO A NODO: Esta representacin almacena la red como una

matriz = { } de . La matriz posee una fila y una columna por cada nodo y la i-sima

entrada es igual 1 si el arco (, ) pertenece al conjunto , y es igual a cero en otro caso. Si

se pretende almacenar los costos y las capacidades de los arcos se pueden utilizar dos matrices

adicionales de , y .

De los n2 elementos que posee la matriz, solo m son diferentes de cero, cuyo nmero se debe

al nmero de arcos de la red. Por lo tanto esta representacin es eficiente si la red es

suficientemente densa, para redes esparcidas esta representacin desperdicia mucho espacio

en la matriz.

La manipulacin de esta matriz es muy fcil. Para determinar el costo o la capacidad del arco

(, ) basta con ubicar a los elementos situados en la posicin de las matrices y

respectivamente. Se puede conocer qu arcos emanan del nodo observando los elementos

iguales a 1 en la fila -sima de la matriz . De manera anloga se pueden obtener los arcos

que llegan al nodo examinando los elementos de la columna de la matriz , si elemento de

la fila -sima es igual a 1, entonces el arco (, ) pertenece a la red.

El tiempo requerido para determinar los arcos que llegan y salen de un nodo es proporcional a

n. En conclusin para redes densas se podra permitir emplear esta representacin, pero para

redes dispersas contribuira al mal desenvolvimiento del algoritmo empleado.

LISTAS DE ADYACENCIA: Anteriormente se defini a las listas de arcos de Adyacencia ()

como el conjunto de arcos que emanan del nodo y las listas de los nodos de adyacencia como

el conjunto de nodos tal que el arco (, ) pertenezca al conjunto .

Esta representacin almacena la lista de adyacencia de cada nodo en la estructura de datos

llamada lista enlazada en una direccin. Una lista enlazada es una coleccin de celdas, donde

cada celda puede contener uno o ms campos.

La lista de adyacencia del nodo i ser representada por una lista enlazada en una direccin,

la que tendr un nmero de celdas igual a la cardinalidad del conjunto (), y cada celda

corresponde a un arco (, ) perteneciente al conjunto . El nmero de campos de la celda

que hace referencia al arco (, ), ser consistente con la cantidad de informacin que se desee

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 11

almacenar. Un campo almacenar al nodo y los dems pueden ser utilizados para guardar el

costo c ij , los lmites de flujo del arco l ij y u ij .

1.2 Grafos y redes con Mathematica

Mathematica Wolfram incluye grandes capacidades para modelado y visualizacin de grafos y

redes. Esta plataforma contiene mecanismos simblicos prcticos para crear, etiquetar y dar

estilo a los grafos, desde pequeos y diagramticos a largos y complejos. Todas las funciones

estn integradas completamente con la programabilidad, grficos e interfaz dinmica.

En el documento: pasos para instalar MATHEMATICA.docx se encuentran las

instrucciones para descargar el programa y la licencia.

En los archivos sesion1.nb, sesion2.nb y sesion3.nb se encuentra el material

introductorio al uso y programacin con Mathematica.

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 12

2. Los mtodos heursticos

Los mtodos desarrollados para resolver problemas de optimizacin, que son abordados en

este curso, reciben el nombre de algoritmos heursticos o metaheursticos. Este trmino se

origina etimolgicamente en la palabra griega heuriskein que significa encontrar o descubrir y

se usa en el mbito de la optimizacin para describir una clase de algoritmos aproximados de

resolucin.

Aunque estos algoritmos (heursticos o Metaheursticos) son aplicables a la resolucin de

problemas de optimizacin contnuos o discretos, en particular en este curso se utilizan en el

contexto de la resolucin de problemas de optimizacin combinatoria, es decir en problemas

de optimizacin sobre un espacio discreto cuyo conjunto de decisiones factibles es

particularmente de gran cardinalidad.

2.1 Definicin y propiedades de los mtodos heursticos

En el lenguaje comn las personas utilizan el trmino optimizar en el sentido de mejorar;

pero, en el lenguaje de las matemticas la optimizacin es el proceso de buscar la mejor

solucin posible para un determinado problema. En un problema de optimizacin existen

diferentes soluciones, que conforman el conjunto de decisiones factibles, y una funcin que

mide la calidad de cada una de esas soluciones, denominada funcin objetivo o criterio, la cual

nos permite discriminar entre ellas, obviamente la meta es encontrar la solucin de mejor

calidad, que se denomina la solucin ptima del problema. De forma ms precisa, un

problema de optimizacin consiste en encontrar los valores que toman las variables de

decisin para los que una determinada funcin objetivo alcanza su valor mximo o mnimo. El

valor de las variables en ocasiones est sujeto a unas restricciones, que deben cumplirse de

manera estricta (dura) o de manera suave.

Algunos tipos de problemas de optimizacin son, desde un punto de vista matemtico,

relativamente fciles de resolver, este es el caso, por ejemplo, de los problemas de

programacin lineal, en los que tanto la funcin objetivo como las restricciones son

expresiones lineales y las variables pueden tomar valores dentro del conjunto de los nmeros

reales. Para estos problemas existen algoritmos que permiten resolverlos de una manera

eficiente, como con el mtodo Simplex, o los mtodos de punto interior; sin embargo, la

mayora de problemas de optimizacin son muy difciles de resolver. Es ms, casi todos los

problemas reales en la logstica, la industria y la ciencia que podemos encontrar en la prctica

entran dentro de esta categora. A partir de ah surge la necesidad de tener mtodos

aproximados, que a pesar que no permiten determinar la solucin ptima de estos problemas,

por lo menos nos proporcionan buenas soluciones, cercanas a la solucin ptima.

La idea intuitiva de los problemas difciles de resolver queda reflejada en el trmino

matemtico NP-duro (NP-hard) proveniente de la teora de la complejidad computacional. En

trminos resumidos podemos decir que un problema de optimizacin difcil es aquel para el

que no podemos garantizar el encontrar la mejor solucin posible en un tiempo razonable. La

existencia de una gran cantidad y variedad de problemas reales que pertenecen a esta clase

NP-hard impuls el desarrollo de procedimientos eficientes para encontrar buenas soluciones

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 13

aunque no fueran ptimas. Estos mtodos, en los que la rapidez del proceso es tan importante

como la calidad de la solucin obtenida, se denominan heursticos o aproximados. En (1) se

recogen algunas definiciones de algoritmo heurstico, entre las que se destaca la siguiente:

Un mtodo heurstico es un procedimiento simple, a menudo basado

en el sentido comn, que se supone ofrecer una buena solucin,

aunque no necesariamente la ptima, a problemas difciles, de un

modo fcil y rpido.

En ese sentido, al contrario de los mtodos exactos que proporcionan la solucin ptima al

problema, los mtodos heursticos se limitan a proporcionar una buena solucin. Lo

determinante es que el tiempo invertido por un mtodo exacto para encontrar la solucin

ptima de un problema difcil, en general es muy superior (o incluso prcticamente infinito) en

comparacin con el tiempo que se requiere hallar una buena solucin por el mtodo

heurstico.

Por su importancia en el campo de las aplicaciones en la industria, la logstica y el transporte,

en este curso consideraremos los llamados problemas de Optimizacin Combinatoria. En estos

problemas el objetivo es encontrar el mximo (o el mnimo) de una determinada funcin sobre

un conjunto finito de soluciones factibles que representaremos por S. No se exige ninguna

condicin o propiedad sobre la funcin objetivo (puede ser lineal, no lineal, convexa, no

convexa, etc.) ni sobre la estructura del conjunto S, salvo su carcter finito. Es importante

notar que dada la finitud de S, las variables de decisin son discretas, ya que su dominio queda

restringido a un conjunto finito de valores. El problema es que a pesar de ser finito, el nmero

de elementos de S es muy elevado, haciendo impracticable la exploracin exhaustiva de todas

sus soluciones para determinar el ptimo.

Aunque hemos mencionado que la razn de desarrollar y utilizar mtodos heursticos es la

resolucin de problemas difciles de tipo NP-duros, existen otras razones por las que se

necesita aplicar mtodos heursticos, entre las que se pueden resaltar:

El problema a tratar es de una naturaleza tal que no se conoce ningn mtodo exacto

para su resolucin.

Aunque existe un mtodo exacto para resolver el problema, su uso es

computacionalmente muy costoso.

Los mtodos heursticos son ms flexibles que los mtodos exactos, permitiendo, por

ejemplo, la incorporacin de condiciones de difcil modelizacin.

Se puede requerir la utilizacin de un mtodo heurstico como parte de un

procedimiento global para encontrar el ptimo de un problema, sobre todo en las

siguientes situaciones:

- El mtodo heurstico permite determinar una buena solucin inicial de partida.

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 14

- El mtodo heurstico participa en un paso intermedio del procedimiento, como por

ejemplo las reglas de seleccin de la variable a entrar en la base en el mtodo

Simplex.

Una caracterstica determinante de los algoritmos heursticos es que estos dependen en gran

medida del problema concreto para el que se han diseado, es decir el algoritmo diseado

para un problema no es directamente aplicable a otro problema de optimizacin. Esta

caracterstica los diferencia de los mtodos de resolucin de propsito general, como por

ejemplo los algoritmos exactos de Branch & Bound, para los cuales existe un procedimiento

conciso y preestablecido, independiente del problema abordado.

As, en los mtodos heursticos las tcnicas e ideas aplicadas a la resolucin de un problema

son especficas y aplicables solo a ste y aunque, en general, pueden ser trasladadas a otros

problemas, tienen que particularizarse y adaptarse en cada caso. As pues, es necesario

referirse a un problema concreto para estudiar con detalle los procedimientos heursticos, por

lo que, para su estudio, hay que considerar un problema de optimizacin combinatorio

especfico, y a partir de ah describir el desarrollo de los mtodos. Existen muchos problemas

que se prestan, por ser fciles de entender pero difciles de resolver, para esto. En general se

puede utilizar el Problema del Agente Viajero, que posee buenas propiedades combinatorias

propiedades que lo hacen especialmente indicado. Dicho problema puede enunciarse del

siguiente modo:

Un agente viajero ha de visitar n ciudades, comenzando y

finalizando en su propia ciudad. Conociendo el costo de ir de cada

ciudad a otra, determinar el recorrido de costo mnimo.

Entre las buenas caractersticas que posee el Problema del Agente Viajero que lo hacen ideal

para el estudio de las tcnicas heursticas se pueden nombrar las siguientes:

Resulta muy intuitivo y con un enunciado muy fcil de comprender.

Es extremadamente difcil de resolver por lo que resulta un desafo constante para los

investigadores y cientficos.

Es uno de los que ms inters ha suscitado en Optimizacin Combinatoria y sobre el que se

ha publicado abundante material.

Sus soluciones admiten una doble interpretacin: mediante grafos y mediante

permutaciones, dos herramientas de representacin muy habituales en problemas

combinatorios, por lo que las ideas y estrategias empleadas son, en gran medida,

generalizables a otros problemas.

La gran mayora de las tcnicas que han ido apareciendo en el rea de la Optimizacin

Combinatoria han sido probadas en l, puesto que su resolucin es de gran complejidad

EJERCICIO:

Analice el problema de agente viajero (TSP por sus siglas en ingls) con nodos a visitar

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 15

a. Cuntas soluciones factibles tiene este problema.

b. Considere ahora un problema con cuatro nodos, la base desde donde debe partir el

agente es la ciudad 1, las distancias inter-elemento estn dadas en la siguiente tabla:

1 2 3 4

1 - 12 14 42

2 12 - 9 13

3 14 9 - 15

4 42 13 15 -

- Utilizando la heurstica del vecino ms cercano (que funciona de la siguiente

manera: en cada paso el siguiente nodo a visitar es el ms cercano a la ubicacin

actual) determine una buena solucin a este problema.

- Explore exhaustivamente todas las soluciones posibles y determine cul es el tour

ptimo para visitar todas las ciudades.

- Cul es el GAP relativo (diferencia entre la solucin aproximada y la solucin

ptima). Considera que la heurstica del vecino ms cercando le proporcion una

buena solucin?

c. Cunto tiempo se demorara en encontrar una solucin ptima por el procedimiento

de exploracin exhaustiva para un problema que tiene 20 nodos, 50 nodos, 70 nodos.

Tomar en cuenta que una computadora promedio actualmente, tiene un rendimiento

de unos 15 teraFLOPS (151012 flops1).

d. Implemente en la computadora un algoritmo para la bsqueda exhaustiva de la

solucin ptima del TSP.

e. Implemente en una computadora el algoritmo del vecino ms cercano para determinar

una solucin al TSP.

Existen tambin otros problemas de optimizacin combinatoria que resultan tambin

atractivos para el estudio de las tcnicas heursticas, estas tcnicas tambin nos ayudaran a

explicar e ilustrar algunas de las tcnicas as como a plantear ejercicios para el estudiante,

entre ellos tenemos: el problema de la mochila (Knapsack Problem), el problema de

planificacin de un taller (Job Shop Problem), el problema de ruteo de vehculos (Vehicle

Routing Problem), el problema de asignacin cuadrtica y otros.

2.2 Tipos de mtodos heursticos

Existen muchos mtodos heursticos de naturaleza muy diferente, por lo que es complicado

dar una clasificacin completa. Adems, muchos de ellos han sido diseados para un problema

especfico sin posibilidad de generalizacin o aplicacin a otros problemas similares. El

siguiente esquema trata de dar unas categoras amplias, no excluyentes, en donde ubicar a los

heursticos ms conocidos:

2.2.1 Mtodos de Descomposicin

En estos mtodos heursticos el problema original se descompone en subproblemas ms

sencillos de resolver, teniendo en cuenta, aunque sea de manera general, que estos

pertenecen al mismo problema.

1

FLOPS es el acrnimo de FLoating-point Operations Per Seconds, es decir el nmero de

operaciones de punto flotante por segundo.

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 16

2.2.2 Mtodos Inductivos

La idea de estos mtodos es generalizar de versiones pequeas o ms sencillas al caso

completo. Propiedades o tcnicas identificadas en estos casos ms fciles de analizar pueden

ser aplicadas al problema completo.

2.2.3 Mtodos de Reduccin

Estos mtodos consisten en identificar propiedades que cumplen mayoritariamente las buenas

soluciones e introducirlas como restricciones del problema. El objeto es restringir el espacio

de soluciones, encogiendo el espacio de bsqueda de las soluciones y simplificando el

problema. El riesgo obvio es dejar fuera buenas soluciones e incluso la ptima del problema

original.

2.2.4 Mtodos Constructivos

Consisten en construir literalmente paso a paso una solucin del problema, incorporando un

nuevo elemento a la solucin en cada iteracin. Usualmente son mtodos deterministas.

2.2.5 Mtodos de Bsqueda Local

A diferencia de los mtodos anteriores, los procedimientos de bsqueda o mejora local

comienzan con una solucin del problema y la mejoran progresivamente. El procedimiento

realiza en cada paso un movimiento de una solucin a otra con mejor valor. El mtodo finaliza

cuando, para una solucin, no existe ninguna solucin accesible que la mejore.

2.2.6 Mtodos combinados

Si bien todos estos mtodos han contribuido a ampliar nuestro conocimiento para la

resolucin de problemas reales, la integracin de los mtodos constructivos y los de bsqueda

local constituyen la base de los procedimientos metaheursticos. Por ello, estudiaremos en

captulos independientes los mtodos constructivos y los mtodos de bsqueda local, mientras

que se harn menciones a lo largo del texto a cualquiera de los mtodos de descomposicin,

inductivos o de reduccin, pero no dedicaremos una seccin especfica a su estudio.

Alternativamente, prestaremos especial atencin a los mtodos resultantes de combinar la

construccin con la bsqueda local y sus diferentes variantes, puesto que puede considerarse

un punto de inicio en el desarrollo de los mtodos metaheursticos.

2.2.7 Mtodos metaheursticos

Existen una serie de mtodos que se conocen bajo el nombre de Metaheursticos, los cuales

tienen el propsito de obtener mejores resultados que los alcanzados por los heursticos

tradicionales. El trmino metaheurstico fue introducido por Fred Glover en 1986. En este

curso utilizaremos la acepcin de heursticos para referirnos a los mtodos clsicos en

contraposicin a la de metaheursticos que reservamos para los ms recientes y complejos,

con los que se obtienen mejores soluciones. En algunos textos podemos encontrar la expresin

heursticos modernos refirindose a los Metaheursticos. En (2) se introduce la siguiente

definicin:

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 17

Los procedimientos Metaheursticos son una clase de mtodos

aproximados que estn diseados para resolver problemas difciles

de optimizacin combinatoria, en los que los heursticos clsicos no

son efectivos. Los Metaheursticos proporcionan un marco general

para crear nuevos algoritmos hbridos combinando diferentes

conceptos derivados de la inteligencia artificial, la evolucin biolgica

y los mecanismos estadsticos

De esta manera, los procedimientos Metaheursticos se sitan conceptualmente por encima

de los heursticos en el sentido que guan el diseo de stos. As, al enfrentarnos a un

problema de optimizacin, podemos escoger cualquiera de estos mtodos para disear un

algoritmo especfico que lo resuelva aproximadamente.

En estos momentos existe un gran desarrollo y crecimiento de estos mtodos. En este curso

vamos a limitarnos a aquellos procedimientos relativamente consolidados y que han probado

su eficacia sobre una coleccin significativa de problemas. Especficamente consideraremos en

sendos captulos la Bsqueda Tab, el Recocido Simulado, los diferentes Mtodos Evolutivos,

incluyendo los Algoritmos Genticos y la Bsqueda Dispersa (Scatter Search), la evolucin

diferencial, el rencadenamiento de trayectorias y los mtodos GRASP.

Es importante notar que para la correcta compresin y asimilacin de los mtodos descritos,

resulta indispensable su puesta en prctica, para lo cual el lector deber implementar en un

lenguaje de computacin los algoritmos descritos y resolver algn problema de optimizacin

combinatoria. Se recomendamos utilizar cualquier lenguaje de programacin que permita

controlar los detalles de implementacin y que incluya la posibilidad de programacin

funcional y un buen manejo de estructuras de datos, en particular Wolfram Mathematica tiene

esas caractersticas. La seccin 2.3 incluye una coleccin de problemas de entre los que el

lector puede escoger alguno e ir trabajando con l, aplicando los mtodos descritos a lo largo

de todo el texto.

Al resolver un problema de forma heurstica debemos de medir la calidad de los resultados

puesto que, como ya hemos mencionado, la optimalidad no est garantizada. En la seccin 2.4

de este captulo se recogen los principales mtodos para medir la calidad y eficiencia de un

algoritmo y poder determinar su vala frente a otros.

2.3 Problemas Estructurados

El objeto de esta seccin no es nicamente dar una coleccin de ejemplos reales, sino el de

establecer modelos que han sido muy estudiados. As, al enfrentarse el lector a un problema

dado, tratar de reconocer las estructuras especiales que aparecen en estos modelos y de esta

forma se podr aprovechar la extensa literatura y experiencia computacional al respecto.

Adems, no debemos olvidar la limitada, pero significativa, importancia prctica de estos

modelos.

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 18

2.3.1 Problema de la Mochila (Knapsack Problem)

El problema de la mochila (KP por sus siglas en ingls), es un problema de optimizacin

combinatoria muy referenciado en la literatura de investigacin de operaciones, tanto por sus

aplicaciones como por su estructura, que lo hace ideal para la evaluacin del desempeo de

mtodos de bsqueda inteligente en problemas de optimizacin combinatoria.

El problema KP es un problema de optimizacin combinatoria de formulacin sencilla, aunque

su resolucin es compleja, y que aparece, directamente, o como un subproblema, en una gran

variedad de aplicaciones, incluyendo planificacin de la produccin, modelizacin financiera,

muestreo estratificado, planificacin de la capacidad de instalaciones, etc., como se observa en

(3). Adems de sus potenciales aplicaciones, el KP es de particular inters por sus

caractersticas combinatorias y su estructura sencilla, que lo vuelve un problema ideal para el

diseo de mtodos de bsqueda inteligente. Con el tratamiento del problema KP se pueden

evaluar las ventajas y desventajas de estos algoritmos, sobretodo su robustez, precisin y

rapidez.

El KP es un problema combinatorio que es NP-duro, como se puede ver en (4), con respecto a

la codificacin binaria estndar, y consta en la lista de 21 problemas NP-completos de Karp,

por tanto es improbable que, en algn momento, pueda ser encontrado un algoritmo que

pueda resolverlo en tiempo polinomial. Sin embargo KP no es del tipo fuertemente NP-duro, y

por tanto puede ser resuelto en tiempo seudo-polinomial, particularmente por programacin

dinmica, como se demuestra en (5) ; es decir, que en su codificacin uniaria el problema es

resoluble polinomialmente. De esta manera, incluso grandes instancias del problema pueden

ser resueltas de manera exacta con solvers que utilizan mtodos como la bsqueda dinmica o

branch & bound (en particular Cplex), y el planteamiento de mtodos aproximados, como los

basados en metaheursticas, se da para probar la eficiencia de estos procedimientos.

La formulacin del KP se realiza de la siguiente manera:

Dado un conjunto de objetos = {1, 2, 3, , }, con utilidades unitarias 1 , 2 , , , y

con pesos 1 , 2 , , , respectivamente, y dado que se tiene un recipiente (la mochila), de

capacidad , el problema KP consiste en determinar qu objetos debo seleccionar para incluir

en la mochila, de tal manera que la utilidad total de los objetos que se cargan sea la mxima

posible, como se puede ver esquemticamente en la Figura 1.

Figura 1. Como cargar ptimamente la mochila sin rebasar su capacidad

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 19

As, el KP puede ser representado sencillamente por la siguiente formulacin de

programacin binaria:

=1

. .

=1

{0, 1}; = 1, 2, ,

En donde: = 1 si decidimos incluir el objeto en la mochila, y = 0 sino.

Este problema tiene numerosas aplicaciones tales como:

La denominada Cutting Stock, en donde hay que cortar una plancha de acero en diferentes

piezas.

Determinar los artculos que puede almacenar un depsito para maximizar su valor total.

Maximizar el beneficio en asignacin de inversiones cuando slo hay una restriccin.

EJERCICIO:

Describir el problema Cutting Stock y plantearlo como un problema de la mochila.

2.3.2 Los problemas de Recubrimiento, empaquetamiento y particionamiento de

Conjuntos

Estos problemas, en ingls conocidos como Set Covering (SCP), Set Packing (SSP) y Set

Partitioning (SPP), respectivamente, son problemas de optimizacin de tipo NP-hard con un

tronco comn con muchas aplicaciones, en particular sern tratados como problemas de

prueba para los mtodos basados en evolucin diferencial (Captulo 0) y que se pueden

enunciar del siguiente modo:

Sea una matriz binaria 0/1 de dimensiones y = {1 , , } un vector de coeficientes

enteros, entontes se definen los problemas SCP, SSP y SPP como:

SCP SSP SPP

. . 1 . . 1 . . = 1

{0,1} {0,1} {0,1}

Los tres problemas, SCP, SSP y SPP, pueden ser muy tiles para mostrar la transformacin y

relaciones entre problemas. As podemos ver que el Set Packing y el Set Partitioning son

equivalentes. Para pasar del primero al segundo basta con aadir variables de holgura. La

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 20

transformacin inversa se realiza mediante variables artificiales. Estos dos problemas son ms

fciles de resolver de forma exacta que el Set Covering ya que en ellos las restricciones

lineales estn ms ajustadas respecto al conjunto de soluciones enteras posibles, por lo que los

ptimos de las relajaciones lineales estn ms cerca de las soluciones enteras.

2.3.2.1 SCP (Problema del recubrimiento de Conjuntos):

Un ejemplo el problema de recubrimiento SPP podra ser el siguiente: Sea un conjunto de

clientes = {1,2, . . , } a los cuales se pretende dar un servicio, y un conjunto H de posibles

ubicaciones de facilidades logsticas desde donde se da servicio a los clientes; es decir, cada

elemento de H da cobertura a un subconjunto de S, H={H1,H2,. .,Hn}, cada Hi tiene un costo ci

asociado. El problema consiste en cubrir con costo mnimo todos los clientes con elementos de

H.

Para formular el problema se define una variable = 1 si Hi est en la solucin y 0 en otro

caso. Tambin se introduce una matriz A={aij} de cobertura, en la que = 1 si el elemento j

de S est en Hi y 0 en otro caso. La formulacin es la siguiente:

=1

. .: 1; = 1, ,

=1

{0, 1}; = 1, ,

Este problema tiene diferentes aplicaciones, entre las que podemos destacar la localizacin de

servicios, tales como hospitales, bomberos, etc. y, la asignacin de tripulaciones a vuelos.

El problema del Set Covering es relativamente fcil de resolver con mtodos de Ramificacin y

Acotacin ya que la solucin ptima del problema lineal coincide, en ocasiones, con la del

problema MIP o est bastante cerca de l. La dificultad del problema proviene del nmero

enorme de variables que suelen aparecer en problemas reales.

EJERCICIO: (Resolver con GAMS)

INSTALACION DE CENTROS DE SEGURIDAD

Una empresa de seguridad residencial e industrial ofrece respuesta rpida a llamadas de

auxilio (en menos de 5 minutos de la alarma ellos estarn en el sitio auxiliando al afiliado). Para

cumplir este objetivo la empresa deber instalar Centros de Auxilio Inmediato en diferentes

sectores de la ciudad, desde donde partirn patrullas armadas hacia el lugar de auxilio.

El gerente de operaciones ha establecido 15 locales que pueden ser adecuados como centros,

as como tambin el costo de alquiler de estos locales. As mismo se ha zonificado la ciudad en

17 zonas. En la tabla adjunta constan los costos as como tambin las zonas de la ciudad que

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 21

pueden ser servidas por cada uno de los mismos El objetivo es determinar que centros instalar

de tal manera que se minimice el costo total y que permita dar el servicio a todas las zonas.

CENTRO DE AUXILIO INMEDIATO

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15

1 1 0 0 1 1 0 0 0 0 1 1 1 1 0 0

2 1 1 1 1 0 0 0 0 1 1 1 0 1 0 0

3 1 0 1 0 1 0 0 0 0 0 0 1 1 1 1

4 0 0 0 0 1 1 1 1 0 0 0 1 1 0 1

5 1 0 0 0 1 1 1 1 0 1 1 1 1 0 0

6 0 0 0 0 1 1 1 0 0 1 0 0 0 1 1

7 1 0 0 0 0 0 0 0 0 1 1 1 0 0 1

8 0 0 0 0 0 1 1 1 0 0 0 0 0 1 0

ZONA

9 0 0 0 1 0 0 0 1 0 0 0 1 0 0 0

10 0 0 1 0 0 0 0 0 0 0 1 1 1 0 0

11 0 1 1 0 0 0 0 0 1 1 1 0 0 0 1

12 0 0 0 1 1 1 0 0 0 0 0 1 0 1 0

13 1 1 0 0 0 0 0 0 0 0 0 0 1 0 1

14 1 0 0 0 0 0 0 0 1 1 1 1 1 0 0

15 0 0 0 0 0 0 0 1 1 1 0 0 0 1 1

16 1 1 1 1 0 0 0 0 0 0 0 0 0 1 1

17 1 1 1 0 0 0 1 0 1 0 1 0 1 0 1

ALQUILER 600 500 380 400 600 280 500 480 510 390 420 450 500 600 550

EJERCICIO: (Resolver con GAMS)

ASIGNACION DE TRIPULACIONES

Una empresa area necesita asignar sus tripulaciones para cubrir todos sus vuelos. En

particular, se quiere resolver el problema de asignar TRES tripulaciones con base en Bogot a

los vuelos listados en la primera columna de la tabla. Las otras columnas muestran las 12

secuencias factibles de vuelos para una tripulacin cualquiera. Los nmeros de cada columna

indican el orden de los vuelos. Se necesita elegir tres secuencias (una por tripulacin) de

manera que se cubran todos los vuelos. Se permite tener ms de una tripulacin en un vuelo,

donde la tripulacin extra viaja como pasajeros, pero como parte del contrato colectivo cada

tripulacin extra que le toque viajar cobra como si estuviera trabajando. El coste de asignacin

de una tripulacin a cada secuencia de vuelos se da en miles de dlares en la ltima fila.

El objetivo es determinar una forma ptima de asignacin de las tres tripulaciones de tal

manera que se minimice el costo total para cubrir todos los vuelos.

1 2 3 4 5 6 7 8 9 10 11 12

1 BOG-UIO 1 1 1 1

2 BOG-GYE 1 1 1 1

3 BOG-LIM 1 1 1 1

4 UIO-HAV 2 2 3 2 3

5 UIO-BOG 2 3 5 5

6 HAV-GYE 3 3 4

7 HAV-LIM 3 3 3 3 4

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 22

8 GYE-BOG 2 4 4 5

9 GYE-HAV 2 2 2

10 LIM-BOG 2 4 4 5

11 LIM-UIO 2 2 4 4 2

12 Costo 20 30 40 60 70 50 70 80 90 90 80 90

2.3.2.2 SPP (Problema de la Particin de Conjuntos)

Ahora consideremos el Set Partitioning y, al igual que en los dos anteriores, se tienen los

conjuntos S y H. As como en el Set Covering cada elemento de S tiene que aparecer al menos

en uno de H, en este problema cada elemento de S tiene que aparecer exactamente en uno de

H, por lo tanto la solucin representa una particin del conjunto S. La funcin objetivo puede

ser maximizar o minimizar, segn la aplicacin.

Aplicaciones:

Asignacin de tripulaciones en una versin ms restringida que la anteriormente

mencionada.

Creacin de distritos Electorales: Asignacin de electores a un colegio electoral.

EJEMPLO:

EL PROBLEMA DEL COLOREO DE GRAFOS

Dado un grafo G, el problema de coloreamiento del grafo consiste en colorear todos los nodos

con la cantidad mnima de colores de tal manera que no existan dos nodos adyacentes (unidos

con una arista) del mismo color. Este problema representa muchas situaciones reales como en

la planificacin de horarios para una serie de actividades que deben tener lugar, algunas de las

cuales no pueden suceder simultneamente, tales como horarios de exmenes, horarios de

competencias deportivas, etc. Se desea conseguir una planificacin que asegure la menor

duracin total de todo el plan.

Para formular este problema se define un grafo en el que cada nodo representa una actividad,

y cada arista (, ) significa que las actividades , no pueden ocurrir simultneamente. El

problema consiste en particionar el conjunto de nodos en el menor conjunto posible de

subconjuntos disjuntos, de tal forma que no existan dos nodos adyacentes en el mismo

subconjunto.

Para formular el problema se consideran todos los posibles conjuntos de nodos tales que no

contengan dos nodos adyacentes, y a cada se le asocia una variable de decisin . La matriz

= ( ) se define como: = 1 si el nodo j pertenece al subconjunto , y cero en caso

contrario. Entonces la formulacin es:

=1

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 23

. .: = 1; = 1, ,

=1

{0, 1}; = 1, ,

EJEMPLO:

Resolver con GAMS el problema de coloreo del grafo de Petersen:

2.3.2.3 SSP (Problema del empaquetamiento de Conjuntos):

Ahora consideremos una aplicacin del Set Packing. Igual que en el problema anterior se

tienen los conjuntos S y H, pero ahora cada Hi tiene un valor asociado. El objetivo es

empaquetar tantos elementos de S como sea posible de forma que el beneficio obtenido sea

mximo y no haya solapamientos (ningn elemento de S puede aparecer ms de una vez).

En cierto modo, la relajacin lineal del Set Covering y la del Set Packing son problemas duales.

Sin embargo esto no sirve para establecer una relacin entre los problemas enteros originales.

Uno de los ejemplos/aplicaciones es el problema del Acoplamiento Mximo o Matching. Un

acoplamiento es un subconjunto de las aristas de un grafo de manera que cualquier vrtice no

sea incidente con ms de una de esas aristas. El problema del acoplamiento mximo consiste

en encontrar un acoplamiento de mximo cardinal.

EJERCICIO:

Plantear una aplicacin del SSP y resolverlo con GAMS

2.3.3 Problema del Agente Viajero (Traveling Salesman Problem)

Este problema, tambin conocido como Traveling Salesman Problem (TSP), ha sido uno de los

ms estudiados en Investigacin Operativa, por lo que merece una atencin especial. Cuando

se desarroll la teora de la Complejidad Algortmica, el TSP fue uno de los primeros problemas

en estudiarse, probando Karp en 1972 que pertenece a la clase de los problemas difciles (NP-

hard).

Desde los mtodos de Ramificacin y Acotacin hasta los basados en la Combinatoria

Polidrica, pasando por los procedimientos Metaheursticos, todos han sido inicialmente

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 24

probados en el TSP, convirtindose ste en un problema de prueba obligado para validar

cualquier tcnica de resolucin de problemas enteros o combinatorios. La librera TSPLIB

(http://comopt.ifi.uni-heidelberg.de/software/TSPLIB95/) de domino pblico contiene un

conjunto de ejemplos del TSP para ser usados como ejemplos de prueba en los algoritmos, y

en los que consta la mejor solucin obtenida hasta la fecha y, en algunos casos, la solucin

ptima. A efectos de medir empricamente la bondad de los algoritmos que se describe,

consideraremos un conjunto de 30 ejemplos de la TSPLIB basados en problemas reales con

ptimos conocidos.

El Problema del Agente Viajero puede enunciarse del siguiente modo:

Un agente viajero ha de visitar n ciudades, comenzando y finalizando en su

propia ciudad. Conociendo el costo de ir de cada ciudad a otra, determinar el

recorrido de costo mnimo.

Para enunciar el problema formalmente introducimos la siguiente terminologa:

Sea un grafo G=(V,A,C) donde V es el conjunto de vrtices, A es el de aristas y C=(cij) es la

matriz de costos. Esto es, cij es el costo o distancia de la arista (i, j).

Un camino (o cadena) es una sucesin de aristas (e1, e2, , ek) en donde el vrtice final de

cada arista coincide con el inicial de la siguiente. Tambin puede representarse por la

sucesin de vrtices utilizados.

Un camino es simple o elemental si no utiliza el mismo vrtice ms de una vez.

Un ciclo es un camino (e1, e2, , ek) en el que el vrtice final de ek coincide con el inicial de

e1.

Un ciclo es simple si lo es el camino que lo define.

Un subtour es un ciclo simple que no pasa por todos los vrtices del grafo.

Un tour o ciclo hamiltoniano es un ciclo simple que pasa por todos los vrtices del grafo.

El Problema del Agente Viajero consiste en determinar un tour de costo mnimo. La figura 2

muestra un grafo de 8 vrtices en el que aparece destacado un ciclo hamiltoniano.

8 5 4

1

6

4

3 6

5

4 3

10

2 5 6

8 10

6 7

4

4 8 4

3 8

Figura 2. Ciclo Hamiltoniano

Consideraremos, sin prdida de generalidad, que el grafo es completo; es decir, que para cada

par de vrtices existe una arista que los une. Notar que, de no ser as, siempre podemos aadir

una arista ficticia entre dos vrtices con el costo del camino ms corto que los une. As por

ejemplo, en el grafo de la figura 2 podemos aadir una arista entre los vrtices 1 y 6 con costo

9 correspondiente al camino 1-3-6.

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 25

Entre las aplicaciones ms importantes del TSP podemos destacar:

Fabricacin de circuitos integrados

Rutas de vehculos

Recogida (robotizada) de material en almacenes

Instalacin de componentes en computadores

Aparece como subproblema en otras aplicaciones

Este problema puede ser formulado mediante un modelo de programacin lineal entera con

variables binarias. Para ello basta considerar las variables xij que valen 1 si el viajante va de la

ciudad i a la j y 0 en otro caso y llamar cij al costo de ir de la ciudad i a la j:

MIN c

i j

ij xij

s.t. :

x x

i j

ij

j i

ji 2 i 1,2,...,n

xij 2 S {1,2,.., n}, 3 S n / 2

( i , j ) ( S )

xij 0,1 i j

Donde (S) representa el conjunto de aristas incidentes con exactamente un vrtice de S.

Las restricciones que aparecen en segundo lugar (vinculadas a todos los subconjuntos de

vrtices S) reciben el nombre de restricciones de eliminacin de subtours y garantizan que la

solucin sea un tour. El problema es que al haber una por cada subconjunto del conjunto de

vrtices, aparecen en una cantidad del orden de 2n, lo cual hace inmanejable tal formulacin.

Se han encontrado restricciones alternativas para evitar la formacin de subtours que suponen

la incorporacin de una cantidad polinmica de restricciones (Miller, Tucker y Zemlin, 1960).

An as, la resolucin ptima del problema ha resultado poco eficiente, salvo para ejemplos

relativamente pequeos, dado el elevado tiempo de computacin requerido por cualquier

mtodo exacto.

2.3.4 El Problema de la Asignacin Cuadrtica

Introduciremos el problema mediante el siguiente ejemplo: Se tienen n mdulos electrnicos

y n posiciones en donde situarlos sobre una placa. Sea tik el nmero de cables que conectan los

mdulos i y k, y sea djl la distancia entre las posiciones j y l de la placa. El problema consiste en

determinar la ubicacin de los mdulos minimizando la longitud total del cable utilizado

Al igual que en los otros modelos de asignacin vistos, se introducen variables binarias xij que

toman el valor 1 si el mdulo i se asigna a la posicin j y 0 en otro caso. La formulacin MIP es

la siguiente:

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 26

n n n n

MIN

i 1 j 1 k 1 l 1

tik d jl xij xkl

s.t. :

n

x

j 1

ij 1 i 1,2,...,n

x

i 1

ij 1 j 1,2,...,n

xij 0,1

El problema se llama cuadrtico por la funcin objetivo ya que el costo viene dado por parejas

de variables que aparecen como producto. As pues la funcin objetivo es no lineal, aunque se

puede transformar en un problema lineal entero introduciendo variables que representen a los

productos. Notar que esta transformacin obligara a reformular las restricciones.

Este problema tiene numerosas aplicaciones ya que podemos encontrar en mbitos muy

diversos situaciones como la descrita. As, por ejemplo, el problema de ubicar determinados

servicios (como laboratorios, rayos X,... etc.) en un hospital en donde se conoce el flujo

previsto de personal entre tales servicios. Anlogamente el guardar determinados productos

en un almacn.

El objeto de introducir este problema es doble: por una parte mostrar un problema no lineal,

con un gran nmero de aplicaciones prcticas, que puede transformarse en un PLE y, por otra,

presentar uno de los problemas ms difciles (sino el que ms) dentro de los ya de por s

difciles problemas enteros.

EJERCICIO:

Introduciendo nuevas variables plantear el problema de asignacin cuadrtica como un

problema MIP.

2.3.5 Problema de Asignacin Generalizada

Se tiene un conjunto J={1,2,..,n} de ndices de los trabajos a realizar y otro conjunto I={1,2,..,m}

de personas para realizarlos. El costo (o valor) de asignar la persona i al trabajo j viene dado

por cij. Adems se tiene una disponibilidad bi de recursos de la persona i (como por ejemplo

horas de trabajo) y una cantidad aij de recursos de la persona i necesarias para realizar el

trabajo j.

Con todo esto, el problema consiste en asignar las personas a los trabajos con el mnimo costo

(o el mximo valor).

Al igual que en los otros modelos de asignacin vistos, se introducen variables xij que valen 1 si

la persona i se asigna al trabajo j y 0 en otro caso.

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 27

n n

MIN c x

i 1 j 1

ij ij

s.t. :

n

x

i 1

ij 1 j 1,2,...,n

n

a x

j 1

ij ij bi i 1,2,...,n

xij 0,1

En este modelo de asignacin se puede asignar una persona a ms de un trabajo, respetando

obviamente las limitaciones en los recursos.

Algunas de las aplicaciones ms relevantes son:

Asignacin de clientes a camiones (de reparto o recogida) de mercancas.

Asignacin de tareas a programadores.

Asignacin de trabajos a una red de computadores.

2.3.6 Problema de la Ordenacin Lineal

Este problema consiste en determinar una permutacin p de las filas y columnas de una matriz

cuadrada dada, de manera que la suma de los elementos por encima de la diagonal sea

mxima. Notar que la permutacin p proporciona el orden tanto de las filas como de las

columnas.

En trminos econmicos este problema es equivalente al de triangulacin de matrices input-

output, que puede describirse del siguiente modo: La economa de una regin se divide en m

sectores, se construye una matriz m*m donde la entrada aij denota la cantidad de mercancas

(en valor monetario) que el sector i sirve al j en un ao dado. El problema de triangulacin

consiste en permutar las filas y columnas de la matriz simultneamente de manera que la

suma de elementos por encima de la diagonal sea lo mayor posible. Una solucin ptima

presenta una ordenacin de sectores de modo que los proveedores (sectores que producen

para otros) van en primer lugar seguidos de los consumidores.

Este problema tambin puede enunciarse en trminos de grafos, lo cual ayuda a formularlo del

siguiente modo:

n n

MAX

i 1 j 1

cij xij

s.t. :

xij x ji 1 i, j V , i j

xij x jk xki 2 1 i < j < k n

xij 0,1

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 28

Donde xij=1 representa que el sector (vrtice) i precede al j en la ordenacin dada por la

solucin.

2.4 Medidas de Calidad de un Algoritmo

Un buen algoritmo heurstico debe de tener las siguientes propiedades:

1. Eficiente. Un esfuerzo computacional realista para obtener la solucin.

2. Bueno. La solucin debe de estar, en promedio, cerca del ptimo.

3. Robusto. La probabilidad de obtener una mala solucin (lejos del ptimo) debe

ser baja.

Para medir la calidad de un heurstico existen diversos procedimientos, entre los que se

encuentran los siguientes:

2.4.1 Comparacin con la solucin ptima

Aunque normalmente se recurre al algoritmo aproximado por no existir un mtodo exacto

para obtener el ptimo, o por ser ste computacionalmente muy costoso, en ocasiones puede

ser que dispongamos de un procedimiento que proporcione el ptimo para un conjunto

limitado de ejemplos (usualmente de tamao reducido). Este conjunto de ejemplos puede

servir para medir la calidad del mtodo heurstico.

Normalmente se mide, para cada uno de los ejemplos, la desviacin porcentual de la solucin

heurstica frente a la ptima, calculando posteriormente el promedio de dichas desviaciones.

Si llamamos ch al valor objetivo en la solucin del algoritmo heurstico y copt al valor objetivo de

la solucin ptima de un ejemplo dado, en un problema de optimizacin el GAP absoluto

(desviacin absoluta) viene dada por la expresin:

= | |

Y el GAP relativo (desviacin relativa) como:

| |

= 100%

2.4.2 Comparacin con una cota

En ocasiones el ptimo del problema no est disponible ni siquiera para un conjunto limitado

de ejemplos. Un mtodo alternativo de evaluacin consiste en comparar el valor de la solucin

que proporciona el heurstico con una cota del problema (inferior si es un problema de

minimizacin y superior si es de maximizacin). Obviamente la bondad de esta medida

depender de la bondad de la cota (cercana de sta al ptimo), por lo que, de alguna manera,

tendremos que tener informacin de lo buena que es dicha cota. En caso contrario la

comparacin propuesta no tiene demasiado inters.

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 29

2.4.3 Comparacin con un mtodo exacto truncado

Un mtodo enumerativo como el de Ramificacin y Acotacin explora una gran cantidad de

soluciones, aunque sea nicamente una fraccin del total, por lo que los problemas de grandes

dimensiones pueden resultar computacionalmente inabordables con estos mtodos. Sin

embargo, podemos establecer un lmite de iteraciones (o de tiempo) mximo de ejecucin

para el algoritmo exacto.

Tambin podemos saturar un nodo en un problema de maximizacin cuando su cota inferior

sea menor o igual que la cota superior global ms un cierto (anlogamente para el caso de

minimizar). De esta forma se garantiza que el valor de la mejor solucin proporcionada por el

procedimiento no dista ms de del valor ptimo del problema. En cualquier caso, la mejor

solucin encontrada con estos procedimientos truncados proporciona una cota con la que

contrastar el heurstico.

2.4.4 Comparacin con otros heursticos

Este es uno de los mtodos ms empleados en problemas difciles (NP-duros) sobre los que se

ha trabajado durante tiempo y para los que se conocen algunos buenos heursticos. Al igual

que ocurre con la comparacin con las cotas, la conclusin de dicha comparacin est en

funcin de la bondad del heurstico escogido.

2.4.5 Anlisis del peor caso (worst case analisys)

Uno de los mtodos que durante un tiempo tuvo bastante aceptacin es analizar el

comportamiento en el peor caso del algoritmo heurstico; esto es, considerar los ejemplos que

sean ms desfavorables para el algoritmo y acotar analticamente la mxima desviacin

respecto del ptimo del problema. Lo mejor de este mtodo es que acota el resultado del

algoritmo para cualquier ejemplo; sin embargo, por esto mismo, los resultados no suelen ser

representativos del comportamiento medio del algoritmo. Adems, el anlisis puede ser muy

complicado para los heursticos ms sofisticados.

Aquellos algoritmos que, para cualquier ejemplo, producen soluciones cuyo costo no se aleja

de un porcentaje del costo de la solucin ptima, se llaman Algoritmos -Aproximados. Esto

es; en un problema de minimizacin se tiene que cumplir para un > 0 que:

ch (1+) copt

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 30

3. Mtodos Constructivos

Los mtodos constructivos son procedimientos iterativos que, en cada paso, aaden un

elemento hasta completar una solucin. Usualmente son mtodos deterministas y estn

basados en seleccionar, en cada iteracin, el elemento con mejor evaluacin. Estos mtodos

son muy dependientes del problema que resuelven, por lo que utilizaremos el Problema del

Agente Viajero (TSP) para describirlos. En este captulo se describen cuatro de los mtodos

ms conocidos para el TSP.

3.1 Heursticos del Vecino ms Cercano

Uno de los heursticos ms sencillos para el TSP es el llamado del vecino ms cercano, que es

un algoritmo glotn (Greedy) que trata de construir un ciclo Hamiltoniano de bajo costo

basndose en el vrtice cercano a uno dado. Este algoritmo en una versin estndar tiene el

siguiente cdigo:

Algoritmo del Vecino ms cercano

Inicializacin

Seleccionar un vrtice j al azar.

Hacer t = j y W = V \ {j}.

Mientras ( W )

Tomar j de W / ctj = min {cti / i en W}

Conectar t a j

Hacer W = W \ {j} y t =j.

Este procedimiento realiza un nmero de operaciones de orden O(n2). Si seguimos la evolucin

del algoritmo al construir la solucin de un ejemplo dado, veremos que comienza muy bien,

seleccionando aristas de bajo costo. Sin embargo, al final del proceso probablemente

quedarn vrtices cuya conexin obligar a introducir aristas de costo elevado. Esto es lo que

se conoce como miopa del procedimiento, ya que, en una iteracin escoge la mejor opcin

disponible sin ver que esto puede obligar a realizar malas elecciones en iteraciones

posteriores.

El algoritmo tal y como aparece puede ser programado en unas pocas lneas de cdigo. Sin

embargo una implementacin directa ser muy lenta al ejecutarse sobre ejemplos de gran

tamao (10,000 vrtices). As pues, incluso para un heurstico tan sencillo como ste, es

importante pensar en la eficiencia y velocidad de su cdigo.

Para reducir la miopa del algoritmo y aumentar su velocidad se introduce el concepto de

subgrafo candidato, junto con algunas modificaciones en la exploracin.

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 31

Un subgrafo candidato es un subgrafo del grafo completo con los vrtices y nicamente las

aristas consideradas atractivas para aparecer en un ciclo Hamiltoniano de bajo costo. Una

posibilidad es tomar, por ejemplo, el subgrafo de los k vecinos ms cercanos; esto es, el

subgrafo con los vrtices y para cada uno de ellos las aristas que lo unen con los k vrtices

ms cercanos. Este subgrafo tambin ser usado en otros procedimientos.

El algoritmo puede mejorarse en los siguientes aspectos:

Para seleccionar el vrtice j que se va a unir a t (y por lo tanto al tour parcial en

construccin), en lugar de examinar todos los vrtices, se examinan nicamente los

adyacentes a t en el subgrafo candidato. Si todos ellos estn ya en el tour parcial, entonces

s que se examinan todos los posibles.

Cuando un vrtice queda conectado (con grado 2) al tour en construccin, se eliminan del

subgrafo candidato las aristas incidentes con l.

Se especifica un nmero s < k de modo que cuando un vrtice que no est en el tour est

conectado nicamente a s o menos aristas del subgrafo candidato se considera que se est

quedando aislado. Por ello se inserta inmediatamente en el tour. Como punto de insercin

se toma el mejor de entre los k vrtices ms cercanos presentes en el tour.

Considerando el estudio emprico sobre las 30 ejemplos utilizados, la versin inicial del

algoritmo presenta un porcentaje de desviacin en promedio respecto del ptimo de 24.2%,

mientras que la mejorada con k=10 y s=4 de 18.6%. La primera tiene un tiempo de ejecucin

medio de 15.3 segundos mientras que la segunda lo tiene de 0.3 segundos.

EJERCICIO:

Implemente un cdigo para hallar una solucin al TSP por medio del algoritmo del vecino ms

cercano.

3.2 Heursticos de Insercin

Otra aproximacin intuitiva a la resolucin del TSP consiste en comenzar construyendo ciclos

que visiten nicamente unos cuantos vrtices, para posteriormente extenderlos insertando los

vrtices restantes. En cada paso se inserta un nuevo vrtice en el ciclo hasta obtener un ciclo

Hamiltoniano. Este procedimiento es debido a los mismos autores que el anterior y su

esquema es el siguiente:

Algoritmo de Insercin

Inicializacin

Seleccionar un ciclo inicial (subtour) con k vrtices.

Hacer W = V \ {vrtices seleccionados}.

Mientras ( W )

Tomar j de W de acuerdo con algn criterio preestablecido

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 32

Insertar j donde menos incremente la longitud del ciclo

Hacer W = W \ {j}.

Existen varias posibilidades para implementar el esquema anterior de acuerdo con el criterio

de seleccin del vrtice j de W a insertar en el ciclo. Se define la distancia de un vrtice v al

ciclo como el mnimo de las distancias de v a todos los vrtices del ciclo:

dmin (v) = min { civ / i V \ W }

Los criterios ms utilizados son:

Insercin ms cercana: Seleccionar el vrtice j ms cercano al ciclo.

dmin (j) = min { dmin (v) / v W }

Insercin ms lejana: Seleccionar el vrtice j ms lejano al ciclo.

dmin (j) = max { dmin (v) / v W }

Insercin ms barata: Seleccionar el vrtice j que ser insertado

con el menor incremento del costo.

Insercin aleatoria: Seleccionar el vrtice j al azar.

La figura 2 muestra la diferencia entre estos criterios en un caso dado. El ciclo actual est

formado por 4 vrtices y hay que determinar el prximo a insertar. La insercin ms cercana

escoger el vrtice i, la ms lejana el s y la ms barata el k.

i

k

Figura 2. Seleccin del vrtice a insertar

Todos los mtodos presentan un tiempo de ejecucin de O(n2) excepto la insercin ms

cercana que es de O(n2log n). Respecto al estudio emprico sobre los 30 grafos de la TSPLIB los

porcentajes de desviacin del ptimo son de 20%, 9.9% 16.8% y 11.1% para el ms cercano,

ms lejano, ms barato y aleatorio, respectivamente, aunque el tiempo de ejecucin del ms

barato es mucho mayor. Respecto al ciclo inicial se ha tomado k=3 vrtices y se comprueba

experimentalmente que el procedimiento no depende mucho del ciclo inicial

(aproximadamente un 6% de variacin).

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 33

EJERCICIO:

Implemente un cdigo para hallar una solucin al TSP por medio del algoritmo de insercin.

3.3 Heursticos Basados en rboles Generadores

Los heursticos considerados anteriormente construyen un ciclo Hamiltoniano basndose

nicamente en los costos de las aristas. Los heursticos de este apartado se basan en el rbol

generador de costo mnimo, lo que aporta una informacin adicional sobre la estructura del

grafo. Comenzaremos por ver algunos conceptos de teora de grafos.

Un grafo es conexo si todo par de vrtices est unido por un camino.

Un rbol es un grafo conexo que no contiene ciclos. El nmero de aristas de un rbol es

igual al nmero de vrtices menos uno.

Un rbol generador de un grafo G=(V,A,C) es un rbol sobre todos los vrtices y tiene, por

tanto, |V| - 1 aristas de G.

Un rbol generador de mnimo peso (o de costo mnimo) es aquel que de entre todos los

rboles generadores de un grafo dado, presenta la menor suma de los costos de sus aristas.

Un acoplamiento de un grafo G=(V,A,C) es un subconjunto M del conjunto A de aristas

cumpliendo que cada vrtice del grafo es a lo sumo incidente con una arista de M.

Un acoplamiento sobre un grafo G=(V,A,C) es perfecto si es de cardinalidad mxima e igual

a V/ 2.

Las figuras siguientes ilustran los conceptos vistos sobre un grafo completo de 8 vrtices. En la

figura 3 tenemos un rbol generador. Notar que contiene a todos los vrtices y no hay ningn

ciclo. La figura 4 muestra un acoplamiento perfecto en el que podemos ver cmo cada vrtice

es incidente con una, y solo una, de las aristas. Al ser un grafo de 8 vrtices el nmero mximo

de aristas en un acoplamiento es de 4, por lo que el de la figura es perfecto.

5 5

1 1

6 6

3 3

2 2

7 7

4 4

8 8

Figura 3. rbol generador Figura 4. Acoplamiento Perfecto

El algoritmo debido a Prim (1957) obtiene un rbol generador de mnimo peso de un grafo G

completo. El algoritmo comienza por definir el conjunto T de aristas del rbol (inicialmente

vaco) y, el conjunto U de vrtices del rbol (inicialmente formado por uno elegido al azar). En

cada paso se calcula la arista de menor costo que une U con V\U, aadindola a T y pasando su

vrtice adyacente de V\U a U. El procedimiento finaliza cuando U es igual a V; en cuyo caso el

conjunto T proporciona la solucin.

Fernando Sandoya, Ph.D.

Metaheursticas y Redes Neuronales ESPOL, 2015/ 34

Dado un ciclo vi0, vi1,, vik que pasa por todos los vrtices de G (no necesariamente simple), el

siguiente procedimiento obtiene un ciclo Hamiltoniano comenzando en vi0 y terminando en vik

(vi0= vik). En el caso de grafos con costos cumpliendo la desigualdad triangular (como es el caso

de grafos eucldeos), este procedimiento obtiene un ciclo de longitud menor o igual que la del

ciclo de partida.

Algoritmo de Obtencin de Tour

Inicializacin

Hacer T = { vi0 }, v = vi0 y s=1.

Mientras ( |T| < |V| )

Si vi s no est en T, hacer:

T = T { vi s }

Conectar v a vi s y hacer v = vi s

Hacer s = s+1

Conectar v a vi0 y formar el ciclo Hamiltoniano

A partir de los elementos descritos se puede disear un algoritmo para obtener un ciclo

Hamiltoniano. Basta con construir un rbol generador de mnimo peso (figura 5), considerar el