Escolar Documentos

Profissional Documentos

Cultura Documentos

PDF Cluster Cluster Lvs Redhat

Enviado por

Joss EsDescrição original:

Direitos autorais

Formatos disponíveis

Compartilhar este documento

Compartilhar ou incorporar documento

Você considera este documento útil?

Este conteúdo é inapropriado?

Denunciar este documentoDireitos autorais:

Formatos disponíveis

PDF Cluster Cluster Lvs Redhat

Enviado por

Joss EsDireitos autorais:

Formatos disponíveis

Tabla de Contenidos

Cluster Suite y Piranha en Red Hat 4

Configuracin de LVS (Piranha) Configuracin de Cluster Suite Pantallazos de Configuracin de Piranha

Cluster Suite y Piranha en Red Hat 4

Montaje de un Cluster de Balanceo de Carga (LVS - Piranha) para Apache utilizando 2 mquinas con Red Hat 4 y Cluster Suite. Datos: Nodo 1: 10.12.3.31 (IP interna: 10.0.0.1) Nodo 2: 10.12.3.32 (IP interna: 10.0.0.2) IP Flotante: 10.12.3.30 Paquetes instalados en ambos nodos: arptables_jf-0.0.8-2 ipvsadm-1.24-6.1 piranha-0.8.2-1

Configuracin de LVS (Piranha)

Ejecutar en nodo 1: arptables -A IN -d 10.12.3.30 -j DROP arptables -A OUT -d 10.12.3.30 -j mangle --mangle-ip-s 10.12.3.32 service arptables_jf save chkconfig arptables_jf on Ejecutar en nodo 2: arptables -A IN -d 10.12.3.30 -j DROP arptables -A OUT -d 10.12.3.30 -j mangle --mangle-ip-s 10.12.3.31 service arptables_jf save chkconfig arptables_jf on En ambos nodos, se debe dejar el siguiente comando, bajo el archivo /etc/rc.local: ifconfig bond0:1 10.12.3.30 netmask 255.255.0.0 broadcast 10.12.255.255 up En la seccin ?start? del servicio pulse (de ambos nodos), se debe agregar el siguiente comando ?arptables -F?: Archivo /etc/init.d/pulse: ... start) echo -n "Starting pulse: " arptables -F daemon pulse RETVAL=$? echo

1/4

[ $RETVAL -eq 0 ] && touch /var/lock/subsys/pulse ;; ... Archivo /etc/sysconfig/ha/lvs.cf serial_no = 51 primary = 10.12.3.31 primary_private = 10.0.0.1 service = lvs backup_active = 1 backup = 10.12.3.32 backup_private = 10.0.0.2 heartbeat = 1 heartbeat_port = 539 keepalive = 6 deadtime = 18 network = direct nat_nmask = 255.255.255.0 debug_level = NONE monitor_links = 1 virtual HTTP { active = 1 address = 10.12.3.30 bond0:1 vip_nmask = 255.255.255.0 port = 80 expect = "OK" use_regex = 0 send_program = "/etc/sysconfig/ha/check_apache %h" load_monitor = none scheduler = rr protocol = tcp timeout = 6 reentry = 15 quiesce_server = 0 server uno { address = 10.0.0.1 active = 1 weight = 1 } server dos { address = 10.0.0.2 active = 1 weight = 2 } }

Configuracin de Cluster Suite

Cluster Suite se utilizar para levantar el servicio ?pulse? cuando uno de los nodos no responda. Nota: no se debe subir la IP flotante mediante Cluster Suite, puesto que la IP es levantada por el

2/4

Balanceo de Carga (pulse).

Archivo /etc/cluster/cluster.conf; <?xml version="1.0"?> <cluster alias="cluster_zates2" config_version="28" name="cluster_zates2"> <fence_daemon post_fail_delay="0" post_join_delay="3"/> <clusternodes> <clusternode name="nodo1" votes="1"> <fence> <method name="1"> <device blade="5" name="fence_bladecenter"/> </method> </fence> </clusternode> <clusternode name="nodo2" votes="1"> <fence> <method name="1"> <device blade="6" name="fence_bladecenter"/> </method> </fence> </clusternode> </clusternodes> <cman expected_votes="1" two_node="1"/> <fencedevices> <fencedevice agent="fence_bladecenter" ipaddr="10.13.7.200" login="cluster" name="fence_bladecenter" passwd="xxxxxxxx"/> </fencedevices> <rm> <failoverdomains/> <resources/> <service autostart="1" name="LVS"> <script file="/etc/init.d/pulse" name="Pulse"/> </service> </rm> </cluster>

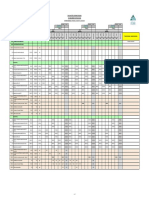

Pantallazos de Configuracin de Piranha

3/4

Script /etc/sysconfig/ha/check_apache: #!/bin/sh # This script is functionally equivilent to the # normal send string 'GET / HTTP/1.0\r\n\r\n' # It's simply put here as an example of how # class="code" passing is used in a shell script # Makes use of nc - netcat (nc-1.10-9) TEST=`(echo "GET / HTTP/1.0\r\n\r\n" | nc if [ $TEST == "1" ]; then echo "OK" else echo "FAIL" fi class="code" 80) | grep -c HTTP`

4/4

Você também pode gostar

- Video Conf Opensourece DimdimDocumento32 páginasVideo Conf Opensourece DimdimJoss EsAinda não há avaliações

- Cluster HADocumento172 páginasCluster HAJoss EsAinda não há avaliações

- Manual Arduino UnoDocumento27 páginasManual Arduino Unocarlosmario27100% (6)

- Arduino JoomlaDocumento52 páginasArduino JoomlaAngelik JolieAinda não há avaliações

- HD Magazine Nro 4Documento74 páginasHD Magazine Nro 4hubutm20Ainda não há avaliações

- Oracle ILOM Guia RapidaDocumento44 páginasOracle ILOM Guia RapidaJoss Es100% (1)

- HD Magazine Nro 4Documento74 páginasHD Magazine Nro 4hubutm20Ainda não há avaliações

- Crear Plantillas JoomlaDocumento25 páginasCrear Plantillas JoomlaKaysars BautistaAinda não há avaliações

- Pautasii CPDDocumento2 páginasPautasii CPDJoss EsAinda não há avaliações

- OSSTMM Es 2 1Documento133 páginasOSSTMM Es 2 1Franky RojoAinda não há avaliações

- Estrategia de Enfriamiento de Racks y Servidores Tipo Blade Con Muy Alta DensidadDocumento27 páginasEstrategia de Enfriamiento de Racks y Servidores Tipo Blade Con Muy Alta DensidadJoss EsAinda não há avaliações

- TIA 942 Presentacion DatacentersDocumento47 páginasTIA 942 Presentacion DatacentersGabriel BarronAinda não há avaliações

- El Standard TIA 942 - Vds-11-4Documento5 páginasEl Standard TIA 942 - Vds-11-4JennyAinda não há avaliações

- Cluster UbuntuDocumento7 páginasCluster Ubuntuberri0509Ainda não há avaliações

- Día Mundial Del Agua Final 29032019Documento19 páginasDía Mundial Del Agua Final 29032019LizAinda não há avaliações

- Diseno de Presas de Tierra y RelavesDocumento29 páginasDiseno de Presas de Tierra y RelavesArturitoAinda não há avaliações

- Desarrollo Histórico Investigación de OperacionesDocumento6 páginasDesarrollo Histórico Investigación de OperacionesjesusAinda não há avaliações

- Calificación Del ProcedimientoDocumento6 páginasCalificación Del ProcedimientoWilmer Zavaleta Huamanyauri100% (1)

- Carbonato de Calcio Práctica de LaboratorioDocumento7 páginasCarbonato de Calcio Práctica de LaboratorioJose PerezAinda não há avaliações

- La Hora Del MantenedorDocumento1 páginaLa Hora Del MantenedorRamcess TovarAinda não há avaliações

- Espacios Confinados Modulo IIDocumento23 páginasEspacios Confinados Modulo IICHRISTOPHER ALMONTE ALVARADO100% (1)

- Wilcom Actualización Manual de Usuario 9.0Documento59 páginasWilcom Actualización Manual de Usuario 9.0ccoco10100% (1)

- Treceava Lección IME 2021-2Documento2 páginasTreceava Lección IME 2021-2Diego AlonsoAinda não há avaliações

- La Mecanica de Rocas en Mineria SubterraneaDocumento14 páginasLa Mecanica de Rocas en Mineria SubterraneaJunior Vasquez100% (1)

- Sensores en El AutomovilDocumento4 páginasSensores en El AutomovilJaime RocanoAinda não há avaliações

- Formato de Pruebas de DisparosDocumento4 páginasFormato de Pruebas de DisparosJordi MujicaAinda não há avaliações

- 3W Look Ahead IFS-0046 PDFDocumento3 páginas3W Look Ahead IFS-0046 PDFDennys Rojas ToledoAinda não há avaliações

- Informe 4 EnzimaticaDocumento13 páginasInforme 4 EnzimaticaAnniee FelizAinda não há avaliações

- Deformaciones de Rocas y FracturasDocumento18 páginasDeformaciones de Rocas y FracturasFELIPE DUCUARAAinda não há avaliações

- Punto de EquilibrioDocumento8 páginasPunto de EquilibrioRaul Alejandro Gonzalez MerchanAinda não há avaliações

- Instalaciones sanitarias para la Facultad de DerechoDocumento12 páginasInstalaciones sanitarias para la Facultad de DerechoRigo Carrasco TorresAinda não há avaliações

- CAR-3889 Profibus DP Service BlockDocumento16 páginasCAR-3889 Profibus DP Service BlockJohanAinda não há avaliações

- 008 PETS - Lavado de VolquetesDocumento7 páginas008 PETS - Lavado de VolquetesAlexander Alcantara100% (2)

- Ok Fundicion y Colada 2014Documento43 páginasOk Fundicion y Colada 2014juancarlosjuaquinAinda não há avaliações

- Informe 6Documento8 páginasInforme 6jhonatan peña beldyAinda não há avaliações

- CONSULTA4Documento5 páginasCONSULTA4Gerardo BayasAinda não há avaliações

- Solucion U2Documento4 páginasSolucion U2Yota RodriguezAinda não há avaliações

- Conocés El Barrio CaferataDocumento7 páginasConocés El Barrio CaferataSebastian Rodrigo WolfensonAinda não há avaliações

- Planificación de compostaje municipalDocumento69 páginasPlanificación de compostaje municipalmyrianAinda não há avaliações

- Base de Datos Frann.......Documento36 páginasBase de Datos Frann.......Frann HRAinda não há avaliações

- Estructuras de Concreto Reforzado DISENODocumento9 páginasEstructuras de Concreto Reforzado DISENOSomarRikardtAinda não há avaliações

- 3 Parcelacion de TierrasDocumento4 páginas3 Parcelacion de TierrasMaria Luisa Heredia Ortiz0% (1)

- Manual Soldadura PavcoDocumento7 páginasManual Soldadura PavcoFlavio Rafael Vizcaino CantilloAinda não há avaliações

- Diagrama de Ishikawa y herramientas de calidadDocumento2 páginasDiagrama de Ishikawa y herramientas de calidadAle CorreaAinda não há avaliações