Escolar Documentos

Profissional Documentos

Cultura Documentos

Aula05 MLP Otim

Enviado por

Mischelle SantosTítulo original

Direitos autorais

Formatos disponíveis

Compartilhar este documento

Compartilhar ou incorporar documento

Você considera este documento útil?

Este conteúdo é inapropriado?

Denunciar este documentoDireitos autorais:

Formatos disponíveis

Aula05 MLP Otim

Enviado por

Mischelle SantosDireitos autorais:

Formatos disponíveis

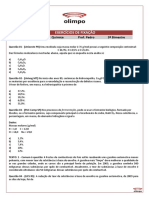

AULA 05

Multilayer perceptron

(continuao)

Os algoritmos de treinamento de perceptrons multicamadas podem ser

classificados nos seguintes itens:

Primeira classe: algoritmos que no requerem derivao, apenas avaliao

da funo em diferentes pontos do espao. So chamados mtodos

sem diferenciao.

Segunda classe: faz uso da derivada primeira a ser minimizada.

So chamados mtodos de primeira ordem.

A terceira classe de algoritmos so os mtodos de segunda ordem, e utilizam

informaes sobre a derivada segunda.

Uma outra classe consiste no ajuste de pesos usando mtodo de tentativas e

erros, e denominado mtodo emprico.

CLASSES DOS ALGORITMOS DE

TREINAMENTO

mtodos de treinamento

sem diferenciao primeira ordem segunda ordem empricos

BE GA SA BP GRAD GC LM OSS QN QP MOD

SCG FR PR DFP BFGS

BE-Busca Exaustiva

GA-Genetic Algorithms

SA-Simulated Annealing

BP BackPropagation

GRAD- Gradiente

GC-Gradiente Conjugado

QN-Quasi Newton

DFP-Davidon-Fletcher-Powell

BFGS-Broyden-Fletcher-Goldfarb-Shanno

LM- Levenberg-Marquardt

OSS- One Step Secant

SCG-Scaled CG

FR-Fletcher-Reeves

PR-Polak-Ribire

)) ( (

)) ( (

) ( ) ( ) 1 (

t

t

t t t

w

w

w w

V

V

= + o

) (

) (

w

w

d

V

V

=

T

n

w w w

grad

(

c

c

c

c

c

c

= V =

) (

...

) ( ) (

) ( )) ( (

2 1

w w w

w w

Algoritmo de primeira ordem: gradiente

Dado o gradiente da soma dos quadrados dos erros por:

a direo de maior decrescimento dada por

e o ajuste do peso dado por:

Algoritmos de segunda ordem

.... *) ( ) ( ' '

! 2

1

*) ( ) ( '

! 1

1

*) ( ) (

2

* *

+ + + =

= =

x x x f x x x f x f x f

x x x x

A srie de Taylor de uma funo f: R R na vizinhana do ponto x = x*

dada por:

...

24

1

2

1

1 ) cos(

0 ) cos( ) (

4 2

+ + =

= =

x x x

x de redor ao x x f

Exemplo:

. .. w*) (w (w) w*) (w

2

1

w*) (w (w) (w*) (w)

w* w

2 T

w* w

T

+ V + V + =

= =

T

n

w w w

(

c

c

c

c

c

c

= V

) (

...

) ( ) (

2 1

w w w

(w)

(

(

(

(

(

(

(

(

c

c

c c

c

c c

c

c c

c

c

c

c c

c

c c

c

c c

c

c

c

= V

2

2

2

2

1

2

2

2

2

2

2

1 2

2

1

2

2 1

2

2

1

2

2

) ( ) ( ) (

) ( ) ( ) (

) ( ) ( ) (

) (

n

n n

n

n

w

w w w w

w w

w

w w

w w w w

w

w w w

w w w

w w w

w

A funo custo ao redor de um ponto w* dada por:

onde grad( ) =

o gradiente de , e

a matriz Hessiana de , tambm denotada por H(w).

(w)

(w)

(w)

(w)

w

*

u

2

u

1

1

-

1

/

2

2

-

1

/

2

w1

w2

Vizinhana de w* (ponto de mnimo erro)

Na vizinhana de w* , se aproxima de uma funo quadrtica.

Os contornos correspondentes a um erro constante so elipses cujos eixos

so alinhados com os autovetores u

1

e u

2

da matriz Hessiana, com comprimentos

inversamente proporcionais raiz quadrada dos autovalores correspondentes.

(w)

Uma forma quadrtica chamada positiva se

para qualquer e uma matriz simtrica A chamada

positiva se uma forma quadrtica positiva.

0 = w

0 > Aw w

T

Aw w

T

Aw w

T

2

2

2

2

2

1

) (

m

w

l

w

+ = w

w1

w2

O trao (interseo) no plano w

1

w

2

um ponto (origem) e os traos

nos planos paralelos e acima do

plano w

1

w

2

so elipses.

(w)

)) ( )... ( ) ( ( ) (

2 1

w w w w

n

F F F g + + =

|

|

.

|

\

|

c c

c

+ +

c c

c

+

c c

c

+

c

c

c

c

=

c c

c

j i

n

j i j i j i j i

w w

w F

w w

w F

w w

w F

u g

w

u

w

u

u g

w w

w ) (

...

) ( ) (

) ( ' ) ( ' '

) (

2

2

2

1

2 2

Clculo da matriz hessiana

Seja a funo custo da rede dada por

A primeira derivada dada por:

g(u)

F1(w)

F2(w)

Fn(w)

x

j j j

w

u

u g

w

u

u

w

w

w

c

c

=

c

c

c

c

=

c

c

) ( '

) ( ) (

) ( ... ) ( ) (

2 1

w F w F w F u

n

+ + + =

onde

Para a obteno da derivada segunda aplica-se a regra do produto: (uv)= uv + uv)

Exemplo de clculo

da matriz hessiana

|

|

.

|

\

|

c

c

+

c

c

=

c

c

=

c c

c

1 1

4

1

4

2 1

2

2

'

' '

' ) ' ' (

w

f

g f

w

g

y w

w

y f w g

w w

F

|

|

.

|

\

|

c

c

c

c

+

c

c

c

c

=

1

1

1 1

2

2

4

'

' '

'

w

u

u

f

g f

w

u

u

g

y w

f(u1) g(u2)

x

y

F1 F2

w3

w5

w4

w1

w2

y f w g

w

y w x w f w

g

w

y w x w f w y w x w

g

w

u

u

F

w

F

' '

) (

'

) ( (

'

4

2

2 1 4

2

2 1 4 5 3

2

2

2

2

2

2

=

c

+ c

=

c

+ + + c

=

c

c

c

c

=

c

c

( )

xy f w g xy f w g

x f g xf f w g y w

' ' ' ' ' '

' ' ' ' ' ' '

4

2 2

4

4 4

+ =

+ =

Exemplo de clculo da hessiana (cont.)

f(u1) g(u2)

x

y

F1 F2

w3

w5

w4

w1

w2

y g

w

u

u

F

w

F

=

c

c

c

c

=

c

c

'

5

2

2

2

5

2

1

2

2 1 1 5 1

2

2

' ' ) ' (

w

u

u

g

y

w

g

y

w

y g

w w

F

c

c

c

c

=

c

c

=

c

c

=

c c

c

xy f w g ' ' '

4

=

Resultado final

yf g H

xy g H

xf g H

y f w g H

y f g yf f w g H

yx f w g H

xy f w g H

x f g xf f w g H

x f w g H

xy f w g xy f w g H

y g H

f g H

x g H

y f w g y f w g H

x f w g x f w g H

' '

' '

' '

' ' '

' ' ' ' '

' ' '

' ' '

' ' ' ' '

' ' '

' ' ' ' ' '

' '

' '

' '

' ' ' ' ' '

' ' ' ' ' '

45

35

34

2

4 25

4 24

4 23

4 15

4 14

2

4 13

4

2 2

4 12

2

55

2

44

2

33

2

4

2 2 2

4 22

2

4

2 2 2

4 11

=

=

=

=

+ =

=

=

+ =

=

+ =

=

=

=

+ =

+ =

(

(

(

(

55 52 51

25 22 21

15 12 11

H H H

H H H

H H H

A matriz H simtrica

portanto os valores da parte triangular

superior so iguais aos

valores da parte triangular inferior.

) ( ). ( )) ( ( 0 w w w A + = H grad

Podendo usar para o clculo de :

)) ( ( ). (

1

w w w = A

grad H

Mtodo de Newton.

OBSERVAO: na prtica usa-se mtodos prximos ao de Newton, para evitar

o uso da matriz hessiana que necessita de uma quantidade grande de clculos.

O mtodo de Newton usa a equao do gradiente expandido em srie de Taylor

... ) ( ). ( )) ( ( )) ( ( + A + = A + w w w w w H grad grad

Se w + Aw um ponto de mnimo, o gradiente ser nulo, e desprezando os

termos de ordem superior, resulta em

Exemplo: mtodo de Newton

)) ( ( ). (

1

w w w = A

grad H

256 9 12 ) , ( ) (

2

2

2

1

3

2

3

1 2 1

+ + = = w w w w w w w

2

2

2

2

1

2

1

1

18 3 ; 24 3

2 1

w w

w

w w

w

w w

=

c

c

= =

c

c

=

) 18 3 , 24 3 (

2

2

2 1

2

1

w w w w = V

(

=

18 6 0

0 24 6

) (

2

1

w

w

H w

0 ; 18 6 ; 24 6

2 1

2

2

2

2

2

1

2

1

2

2 1 2 2 1 1

=

c c

c

= =

c

c

= =

c

c

=

w w

w

w

w

w

w w w w w w

Exemplo Newton (cont.)

) 18 3 , 24 3 (

2

2

2 1

2

1

w w w w = V

(

=

18 6 0

0 24 6

) (

2

1

w

w

H w

Seja o ponto inicial w(0)=(1,1)

(

= = V

12 0

0 18

) 15 , 21 ( H e

(

(

(

12

1

0

0

18

1

1

H

)) ( ( ). (

1

w w w = A

grad H

(

(

(

=

(

(

(

(

= V = A

4

5

6

7

15

21

12

1

0

0

18

1

. ) , (

1

2 1

H w w

|

.

|

\

|

=

|

.

|

\

|

=

4

1

,

6

1

4

5

,

6

7

) 1 , 1 ( ) 1 ( w

Exemplo Newton (cont.)

Em w(1) =(-1/6,-1/4)

(

(

=

|

.

|

\

|

= V

2

39

0

0 25

16

75

,

36

147

H e

(

(

(

39

2

0

0

25

1

1

H

(

= V = A

240 . 0

163 . 0

. ) , (

1

2 1

H w w

( ) ( ) 010 . 0 , 004 . 0 240 . 0 , 163 . 0 ) 25 . 0 , 167 . 0 ( ) 2 ( = = w

) 10 54 . 1 , 10 39 . 1 ( ) 3 (

5 6

= x x w

) 10 00 . 4 , 0 ( ) 4 (

11

= x w

) 0 , 0 ( ) 5 ( = w

Mtodo do gradiente conjugado

(ou direo conjugada)

Seja a forma quadrtica

b A w

1 *

=

c + = w b Aw w (w)

T T

2

1

onde um vetor de parmetros Wx1, A uma matriz WxW,

simtrica, definida positivamente, e b um vetor Wx1 e c um escalar.

A minimizao de obtida atribuindo a o valor

w

w

) (w

Mtodo do gradiente conjugado (cont.)

x1

x2

v1

v2

j n que tal j e n todo para j n = = 0 ) s( A ) ( s

T

x A v

1/2

=

Dada a matriz A, diz-se que um conjunto de vetores no-nulos s(0), s(1), ... s(W-1)

conjugado de A (i., no interferem entre si no contexto da matriz A) se a seguinte

condio for satisfeita:

Exemplo: os dois vetores mostrados na Figura (a) so conjugados pois feita a trans-

formao

resulta em vetores perpendiculares (Figura (b)).

(a) (b)

Mtodo de gradiente conjugado (cont.)

Para um dado conjunto de vetores conjugados de A, s(0), s(1)...

s(W-1), o ajuste dos pesos definido por:

1 ,..., 1 , 0 ), ( ) ( ) ( ) 1 ( = + = + W n n n n n s w w q

onde w(0) um vetor inicial arbitrrio e q(n) um escalar definido para

minimizar a funo f(w(n)+q(n)s(n)), e referido como busca em linha.

Exemplo: gradiente conjugado

16 6 8 4 2 ) , (

2 1

2

2 2 1

2

1 2 1

+ + + = w w w w w w w w

(

=

8 2

2 2

H

0

8 2

2 2

] 0 1 [ =

(

v

u

Comeando do ponto (0,0) ao longo do eixo w

1

, isto , na direo (1,0),

procuramos a direo conjugada de (1, 0), denotada por (u,v).

0 2 2 0 ] 2 2 [ = + =

(

v u isto

v

u

portanto um vetor que representa o gradiente conjugado (1, -1).

Exemplo: Gradiente conjugado (cont.)

na direo (1, 0) a funo torna-se:

16 8 ) 0 , (

1

2

1 1

+ = w w w e tem um mnimo em (4, 0).

Iniciando desse mnimo (4, 0) ao longo da direo dada pelo conjugado (1, -1),

ou seja, ao longo da reta

1 2

4 w w =

a funo pode ser escrita para w

1

56 26 3

16 ) 4 ( 6 8

) 4 ( 4 ) 4 ( 2 ) 4 , ( ) , (

1

2

1

1 1

2

1 1 1

2

1 1 1 2 1

+ =

+

+ + = =

w w

w w

w w w w w w w w

que tem um mnimo em w

1

= 13/3 e w

2

= -1/3

16 6 8 4 2 ) , (

2 1

2

2 2 1

2

1 2 1

+ + + = w w w w w w w w

Resumo do Algoritmo de Gradiente Conjugado

1. Iniciar os valores de w(0)

2. Para w(0) usar o back-propagation para computar o gradiente g(0).

3. Fazer s(0)=r(0)=-g(0)

4. No passo n, usar a busca em linha para encontrar q(n) que minimiza .

5. Testar se a norma euclidiana do residual r(n) caiu num valor abaixo do

especificado, ou seja numa pequena frao do valor inicial r(0).

6. Atualizar o vetor peso:

7. Para w(n+1) usar back-propagation para computar o vetor gradiente g(n+1)

8. Fazer r(n+1) = - g(n+1)

9. Usar o mtodo de Polak-Ribire para calcular

10. Atualizar a direo conjugada

11. Fazer n = n + 1 e ir para o passo 4.

) ( ) ( ) ( ) 1 ( n n n n s w w q + = +

)

`

+ +

= + 0 ,

) ( ) (

)) ( ) 1 ( )( 1 (

max ) 1 (

n n

n n n

n

T

T

r r

r r r

|

) ( ) 1 ( ) 1 ( ) 1 ( n n n n s r s + + + = + |

Mtodo de Levenberg-Marquardt (LM)

)

`

c c

c

+

c

c

c

c

=

c c

c

=

n

k i

n

n

k

n

i

n

j i

ik

w w w w w w

c

c

c c

2 2

) (H

( )

=

n

n

2

2

1

c

)

`

c

c

c

c

=

n

k

n

i

n

ik

w w

c c

)' (H

Neste mtodo considerando a soma dos quadrados na forma:

o clculo de um elemento da matriz Hessiana fica

Calculando-se esse elemento sem o segundo termo do somatrio,

obtem-se o mtodo de Levenberg-Marquardt.

onde n corresponde ao nsimo padro de treinamento.

Aplicao de LM no exemplo

yf g H

xy g H

xf g H

y f w g H

y f g yf f w g H

yx f w g H

xy f w g H

x f g xf f w g H

x f w g H

xy f w g xy f w g H

y g H

f g H

x g H

y f w g y f w g H

x f w g x f w g H

' '

' '

' '

' ' '

' ' ' ' '

' ' '

' ' '

' ' ' ' '

' ' '

' ' ' ' ' '

' '

' '

' '

' ' ' ' ' '

' ' ' ' ' '

45

35

34

2

4 25

4 24

4 23

4 15

4 14

2

4 13

4

2 2

4 12

2

55

2

44

2

33

2

4

2 2 2

4 22

2

4

2 2 2

4 11

=

=

=

=

+ =

=

=

+ =

=

+ =

=

=

=

+ =

+ =

(

(

(

(

55 52 51

25 22 21

15 12 11

H H H

H H H

H H H

yf g H

xy g H

xf g H

y f w g H

yf f w g H

yx f w g H

xy f w g H

xf f w g H

x f w g H

xy f w g H

y g H

f g H

x g H

y f w g H

x f w g H

2

45

35

2

34

2

4

2

25

4

2

24

4

2

23

4

2

15

4

2

14

2

4

2

13

2 2

4

2

12

2 2

55

2 2

44

2 2

33

2 2 2

4

2

22

2 2 2

4

2

11

'

' '

'

' '

' '

' '

' '

' '

' '

' '

'

'

'

' '

' '

=

=

=

=

=

=

=

=

=

=

=

=

=

=

=

Hessiana LM

f(u1) g(u2)

x

y

F1 F2

w3

w5

w4

w1

w2

k i

ik

w

F

w

F

c

c

c

c

=

2 2

H

T

w

F

w

F

w

F

w

F

w

F

F

(

c

c

c

c

c

c

c

c

c

c

= V

5

2

4

2

3

2

2

2

1

2

2

y g

w

F

f g

w

F

x g

w

F

y f w g

w

F

x f w g

w

F

'

'

'

' '

' '

5

2

4

2

3

2

4

2

2

4

1

2

=

c

c

=

c

c

=

c

c

=

c

c

=

c

c

Mtodos disponveis no NN toobox

(MATLAB)

Sigla algoritmo mtodo

GD traingd Gradient Descent

GDM traingdm Gradient Descent with Momentum

GDA traingda Gradient Descent with Adaptive Learning Rate

LM trainlm Levenberg-Marquardt

BFG trainbfg BFGS Quasi-Newton

RP trainrp Resilient Backpropagation

SCG trainscg Scaled Conjugate Gradient

CGB traincgb Conjugate Gradient with Powell/Beale Restarts

CGF traincgf Fletcher-Powell Conjugate Gradient

CGP traincgp Polak-Ribire Conjugate Gradient

OSS trainoss One Step Secant

GDX traingdx Variable Learning Rate Backprogagation

Parmetros: epochs, show, goal, time, min_grad, max_fail, lr

lr learning rate se lr for muito grande o algoritmo se torna instvel.

se o lr for muito pequeno, o algoritmo leva muito tempo para convergir

O estado do treinamento mostrado a cada iterao (show).

Se show for NaN, nunca mostrado.

Os outros parmetros determinam a parada do treinamento.

O treinamento pra se o nmero de iteraes exceder epochs,

se a funo custo cair abaixo do goal, se a magnitude do gradiente

for menor que min_grad, ou se o tempo de treinamento maior

que o tempo (time) em segundos.

O parmetro max_fail associado tcnica de parada antecipada,

para melhorar a capacidade de generalizao da rede.

Como usar o NN toolbox para:

criar um conjunto de treinamento de entradas p e alvo t (sada desejada)

criar uma rede feedforward (a funo minmax usada para determinar

o intervalo das entradas a ser usado):

alterar alguns parmetros default de treinamento

treinar a rede

executar a simulao com os dados de entrada de treinamento

Como usar o NN toolbox para:

MLP normalmente usa funo sigmide. Essas funes se caracterizam

pelo fato da derivada para argumentos grandes ser muito pequena.

Isso causa morosidade na velocidade de convergncia quando os

argumentos so grandes e ainda a rede estiver longe de valores timos.

Rprop (resilient backpropagation) elimina esse efeito. Somente o sinal da

derivada usado para determinar a direo da atualizao do peso.

A quantidade da atualizao determinado de outra forma.

O valor da atualizao para pesos e bias incrementado de um fator delt_inc

sempre que a derivada for na mesma direo para duas iteraes

sucessivas.

O valor da atualizao decrementado por um fator delt_dec sempre que

a derivada muda de sinal em relao a iterao anterior.

Sempre que os pesos estiverem oscilando a mudana nos pesos reduzida.

Se a derivada zero, o valor da atualizao permanece o mesmo.

Todos os algoritmos de gradiente conjugado iniciam a busca na direo

descida ngreme (negativo do gradiente) para a primeira iterao.

Uma pesquisa nessa direo ento realizada para determinar a distncia

tima para mover ao longo da direo atual.

Ento a prxima direo determinada tal que ela seja conjugada da direo

prvia. O procedimento geral para determinar uma nova direo combinar

a nova direo de descida ngreme com a direo prvia.

As vrias verses de algoritmos de gradiente conjugado so diferentes na

maneira em que |

k

computado. Para Fletcher-Reeves usada a equao:

Essa a razo do quadrado da norma do gradiente atual em relao ao

quadrado da norma do gradiente anterior.

Gradiente conjugado:

A direo de pesquisa a cada iterao determinada, como no anterior, por

porm a constante |

k

computada por

que o produto interno da mudana anterior no gradiente com o gradiente

corrente dividido pelo quadrado da norma do grandiente anterior.

Gradiente conjugado:

Gradiente conjugado:

Para todos os algoritmos de gradiente conjugado, a direo de pesquisa

periodicamente reiniciado (reset) para o negativo do gradiente.

O ponto de reset padro ocorre quando o nmero de iteraes igual ao

nmero de parmetros (pesos e bias) da rede, mas existem outros mtodos

que podem melhorar a eficincia do treinamento. Um mtodo proposto

por Powell, baseado numa verso anterior proposto por Beale, reinicia a

direo se existe muito pouca ortogonalidade entre o gradiente atual e o

gradiente prvio. Isso testado pela seguinte inequao:

Se essa condio satisfeita, a direo de pesquisa reiniciada para o

negativo do gradiente.

Gradiente conjugado:

Cada um dos algoritmos anteriores requerem uma pesquisa na direo

a cada iterao. Essa pesquisa computacionalmente onerosa, pois

requer que sejam computadas a resposta da rede para todas as entradas

de treinamento, vrias vezes para cada pesquisa.

O algoritmo de gradiente conjugado escalado, desenvolvido por Moller, foi

projetado para evitar esse consumo de tempo.

Esse algoritmo combina uma abordagem de modelo de regio de confiana

(model trust) usado no algoritmo de Levenberg-Marquardt, com a tcnica

do gradiente conjugado.

O mtodo de Newton uma alternativa para os mtodos de gradiente

conjugado para otimizao rpida. O passo bsico do mtodo

O mtodo quase sempre converge mais rpido que os mtodos de

gradiente conjugado. Infelizmente, complexo e oneroso computar

a matriz hessiana.

Existe uma classe de algoritmos que baseada no mtodo de Newton, mas

no requer o clculo de derivadas segundas, que so chamados de mtodos

quasi-Newton ou secante.

Eles atualizam uma matriz aproximada da hessiana a cada iterao do algoritmo.

A atualizao computada como uma funo do gradiente.

O mtodo quasi-Newton que tem sido mais bem sucedido em estudos publicados

o de Broyden, Fletcher, Goldfarb, e Shanno (BFGS).

Como o algoritmo BFGS requer mais armazenamento e computao em

cada iterao que os algoritmos de gradiente conjugado, existe uma

necessidade de uma aproximao secante com menor armazenamento

e computao.

O mtodo de secante em um passo (one step secant) uma tentativa

intermediria entre os algoritmos de gradiente conjugado e os algoritmos

quasi-Newton.

Esse algoritmo no armazena a matriz hessiana completa. Ele assume

que a cada iterao, a Hessiana anterior uma matriz identidade.

Existe uma vantagem adicional de que a nova direo de pesquisa seja

calculada sem computar a matriz inversa.

Exemplos comparativos

SENO aproximao de um perodo da

funo seno (1-5-1)

Problema de aproximao de funo. Rede 1 5 1, funes tansig para

camadas escondidas e linear para camada de sada.

Cada entrada na tabela representa 30 tentativas diferentes, com diferentes

valores de pesos iniciais. Parada com erro quadrtico = 0.002.

O algoritmo mais rpido o Levenberg-Marquardt, na mdia 4 vezes mais

rpido que o prximo.

Esse o tipo de problema que o algoritmo LM adequado problema de

aproximao de funo, onde a rede tem menos que 100 pesos e a

aproximao deve ser com muita preciso.

SENO aproximao de um

perodo da funo seno (1-5-1)

Algoritmo Temp

mdio (s)

Razo Tempo

mnimo(s)

Tempo

mximo(s)

Desvio

padro(s)

LM 1.14 1.00 0.65 1.83 0.38

BFG 5.22 4.58 3.17 14.38 2.08

RP 5.67 4.97 2.66 17.24 3.72

SCG 6.09 5.34 3.18 23.64 3.81

CGB 6.61 5.80 2.99 23.65 3.67

CGF 7.86 6.89 3.57 31.23 4.76

CGP 8.24 7.23 4.07 32.32 5.03

OSS 9.64 8.46 3.97 59.63 9.79

GDX 27.69 24.29 17.21 258.15 43.65

Mse x tempo de convergncia

Tempo em funo da meta (mse)

Deteco de paridade de um nmero de 3 bits

(3-10-10-1)

Problema de reconhecimento de padres detectar paridade de um

nmero de 3 bits.

Se o nmero de uns impar a sada deve ser 1, caso contrrio, -1.

Rede 3-10-10-1, com tansig em todas as camadas.

Cada entrada na tabela representa 30 diferentes tentativas, com diferentes

valores iniciais de pesos. Parada a erro quadrtico = 0.001.

O algoritmo mais rpido o Resilient Backpropagation (Rprop).

Nota-se que o algoritmo LM no tem bom desempenho neste problema.

Em geral LM no desempenha to bem em reconhecimento de padres como

em problemas de aproximao. O LM projetado para problemas de

mnimos quadrados que so aproximadamente lineares. Como os neurnios

de sada em problemas de reconhecimento de padres so geralmente

saturados, no operam na regio linear.

Deteco de paridade de um nmero de 3 bits

(3-10-10-1)

Algoritmo Temp

mdio (s)

Razo Tempo

mnimo(s)

Tempo

mximo(s)

Desvio

padro(s)

RP 3.73 1.00 2.35 6.89 1.26

SCG 4.09 1.10 2.36 7.48 1.56

CGP 5.13 1.38 3.50 8.73 1.05

CGB 5.30 1.42 3.91 11.59 1.35

CGF 6.62 1.77 3.96 28.05 4.32

OSS 8.00 2.14 5.06 14.41 1.92

LM 13.07 3.50 6.48 23.78 4.96

BFG 19.68 5.28 14.19 26.64 2.85

GDX 27.07 7.26 25.21 28.52 0.86

Mse x tempo de convergncia

Tempo em funo da meta (mse)

Operao de um motor (entrada = velocidade e nvel queima de

combustvel; sada= torque e emisso) (2-30-2)

Problema de regresso no-linear. Os dados so obtidos de operao

de um motor. As entradas so a velocidade e o consumo de combustvel,

enquanto que as sadas so o torque e o nvel de emisso.

A rede usada de 2-30-2 com neurnios tansig na camada escondida e

linear na camada de sada.

Cada entrada na tabela representa 30 tentativas (10 par RP e GDX por

restries de tempo), com diferentes pesos iniciais.

Parada com erro quadrtico menor que 0.005.

O mais rpido o LM, embora o BFGS e os gradientes conjugados (scaled

em particular) so quase tanto quanto.

Embora esse problema seja de aproximao de funo, o LM no claramente

superior como no caso do SENO. Neste caso, o nmero de pesos e bias

na rede maior (152 x 16), e as vantagens do LM decresce com o

Aumento do nmero de parmetros.

Operao de um motor (entrada = velocidade e nvel queima de

combustvel; sada= torque e emisso) (2-30-2)

Algoritmo Temp

mdio (s)

Razo Tempo

mnimo(s)

Tempo

mximo(s)

Desvio

padro(s)

LM 18.45 1.00 12.01 30.03 4.27

BFG 27.12 1.47 16.42 47.36 5.95

SCG 36.02 1.95 19.39 52.45 7.78

CGF 37.93 2.06 18.89 50.34 6.12

CGB 39.93 2.16 23.33 56.42 7.50

CGP 44.30 2.40 24.99 71.55 9.89

OSS 48.71 2.64 23.51 80.90 12.33

RP 65.91 3.57 31.83 134.31 34.24

GDX 188.50 10.22 81.59 279.90 66.67

Mse x tempo de convergncia

Tempo em funo da meta (mse)

CNCER Classificao de tumor benigno ou maligno

baseada nas descries obtidas atravs de dados

microscpicos. (9-5-5-2)

Reconhecimento de padres (ou anlise de discriminantes no-lineares).

Objetivo classificar um tumor como benigno ou maligno baseado em descries

celulares obtidas de exames microscpicos. Os atributos de entrada incluem

espessura da amostra, uniformidade do tamanho da clula e formato, quantidade

de adeso marginal, e frequncia de ncleos descobertos.

Os dados foram obtidos de: University of Wisconsin Hospitals.

A rede de 9-5-5-2 com neurnios tansig em todas as camadas.

Cada entrada na tabela representa 30 tentativas, com pesos iniciais distintos.

O critrio de parada de erro quadrtico menor que 0.012. Alguns treinamentos

falharam na convergncia, tal que somente os 75% dos treinamentos de cada

algoritmo foram usados para estatstica.

Os algoritmos de gradiente conjugado e Rprop apresentam convergncia rpida

e o algoritmo LM tambm razoavelmente rpido.

Como no caso de PARIDADE, o algoritmo LM no desempenha to bem em

problemas de reconhecimento de padres, como em problemas de aproximao

de funes.

CNCER Classificao de tumor benigno ou maligno

baseada nas descries obtidas atravs de dados

microscpicos. (9-5-5-2)

Algoritmo Temp

mdio (s)

Razo Tempo

mnimo(s)

Tempo

mximo(s)

Desvio

padro(s)

CGB 80.27 1.00 56.07 102.31 13.17

RP 83.41 1.04 59.51 109.39 13.44

SCG 86.58 1.08 41.21 112.19 18.25

CGP 87.70 1.09 56.35 116.37 18.03

CGF 110.05 1.37 63.33 171.53 30.13

LM 110.33 1.37 58.94 201.07 38.20

BFG 209.60 2.61 118.92 318.18 58.44

GDX 313.22 3.90 166.48 446.43 75.44

OSS 463.87 5.78 250.62 599.99 97.35

mse x tempo de convergncia

Tempo em funo da meta (mse)

COLESTEROL- predizer o nvel de colesterol

(LDL,HDL,VLDL)

Aproximao de funo (ou regresso no-linear). O objetivo da rede

predizer os nveis de colesterol baseados em medidas de 21 componentes

espectrais. Os dados foram obtidos de Oklahoma State University.

Rede de 21-15-3 neurnios com ativao tansig na camada escondida e

linear na camada de sada.

Cada entrada na tabela representa 20 tentativas (10 para RP e GDX), onde

diferentes pesos iniciais so usados.

O critrio de parada de erro quadrtico menor que 0.027.

O algoritmo de gradiente conjugado escalado tem o melhor desempenho, embora

todos os outros algoritmos de gradiente conjugado desempenham bem.

O algoritmo LM no desempenha em como no problema de aproximao de funo.

Isso porque o nmero de pesos e bias na rede aumentou (378 versus 152 versus 16).

Quando o nmero de parmetros aumenta, a computao requerida para o LM

aumenta geometricamente.

COLESTEROL- predizer o nvel de colesterol

(LDL,HDL,VLDL) baseado na medida de 21

componentes espectrais. (21-15-3)

Algoritmo Temp

mdio (s)

Razo Tempo

mnimo(s)

Tempo

mximo(s)

Desvio

padro(s)

SCG 99.73 1.00 83.10 113.40 9.93

CGP 121.54 1.22 101.76 162.49 16.34

CGB 124.06 1.24 107.64 146.90 14.62

CGF 136.04 1.36 106.46 167.28 17.67

LM 261.50 2.62 103.52 398.45 102.06

OSS 268.55 2.69 197.84 372.99 56.79

BFG 550.92 5.52 471.61 676.39 46.59

BP 1519.00 15.23 581.17 2256.10 597.34

GDX 3169.50 31.78 2514.90 4168.20 610.52

Mse x tempo de convergncia

Tempo em funo da meta (mse)

DIABETES verificar se um individuo tem diabetes baseado nos

dados (idade, nmero gravidez, presso sangunea, ndice de massa

corprea, glicemia, etc.) (8-15-15-2)

Problema de reconhecimento de padres. Decidir se um indivduo

diabtico, baseado nos dados pessoais (idade, nmero de gravidez) e

resultados de exames mdicos ( presso sangunea, ndice de massa

corprea, resultado do teste de tolerncia a glicose, etc.). Os dados

foram obtidos da University of California, Irvine, machine learning data base.

A rede de 8-15-15-2 com neurnios tansig em todas as camadas.

Cada entrada na tabela representa 10 tentativas, com diferentes pesos

iniciais. O critrio de parada de erro quadrtico menor que 0.05.

Os algoritmos de gradiente conjugado e Rprop todos proveem convergncia

rpida. O algoritmo RProp funciona bem em todos os problemas de

reconhecimento de padres. Isso razovel, pois ele foi projetado para superar

as dificuldades causadas pelo treinamento com funes sigmides, que tem

pequena inclinao quando o argumento distante do centro.

Para problemas de reconhecimento de padres, so usadas funes sigmides

na camada de sada, e a rede opera nas extremidades das funes.

DIABETES verificar se um individuo tem diabetes baseado

nos dados (idade, nmero gravidez, presso sangunea, ndice

de massa corprea, glicemia, etc.) (8-15-15-2)

Algoritmo Temp

mdio (s)

Razo Tempo

mnimo(s)

Tempo

mximo(s)

Desvio

padro(s)

RP 323.90 1.00 187.43 576.90 111.37

SCG 390.53 1.21 267.99 487.17 75.07

CGB 394.67 1.22 312.25 558.21 85.38

CGP 415.90 1.28 320.62 614.62 94.77

OSS 784.00 2.42 706.89 936.52 76.37

CGF 784.50 2.42 629.42 1082.20 144.63

LM 1028.10 3.17 802.01 1269.50 166.31

BFG 1821.00 5.62 1415.80 3254.50 546.36

GDX 7687.00 23.73 5169.20 10350.00 2015.00

Mse x Tempo de convergncia

Tempo em funo da meta (mse)

Você também pode gostar

- Apostila Simple Logistics Introdução S4 HANA - Versão 2Documento208 páginasApostila Simple Logistics Introdução S4 HANA - Versão 2Sandro Domeneghetti100% (10)

- 1554820774ebook Guia Da Redacao 1000Documento26 páginas1554820774ebook Guia Da Redacao 1000Suely100% (1)

- AtividadedaguaDocumento46 páginasAtividadedaguaMischelle Santos100% (3)

- Estudos Disciplinares III Questionário 1Documento3 páginasEstudos Disciplinares III Questionário 1Antonio Locati75% (4)

- Alarm Basicos ZTEDocumento3 páginasAlarm Basicos ZTEAlex Da Luz Dutra100% (1)

- Curso ScadaBRDocumento124 páginasCurso ScadaBRChiliShirleyChambyAinda não há avaliações

- Roteiro 10Documento2 páginasRoteiro 10Mischelle SantosAinda não há avaliações

- Lista de Formulas Quimicas 1anoDocumento10 páginasLista de Formulas Quimicas 1anoMischelle SantosAinda não há avaliações

- Aula - 10 Parte 1Documento53 páginasAula - 10 Parte 1Mischelle SantosAinda não há avaliações

- Lista 1 de Hidraulica RevisadaDocumento2 páginasLista 1 de Hidraulica RevisadaMischelle SantosAinda não há avaliações

- Lista 7 de HidraulicaDocumento1 páginaLista 7 de HidraulicaMischelle SantosAinda não há avaliações

- Catalogo WGB Linha Eletronica1Documento27 páginasCatalogo WGB Linha Eletronica1Alexandre De Los SantosAinda não há avaliações

- Dissertações e Teses Defendidas No PEPG em Educação Matemática Da PUCDocumento19 páginasDissertações e Teses Defendidas No PEPG em Educação Matemática Da PUCRuber LeiteAinda não há avaliações

- OpenERP 6.1 - Configuração de Impostos Brasil PDFDocumento48 páginasOpenERP 6.1 - Configuração de Impostos Brasil PDFCarlos AraújoAinda não há avaliações

- Matemática e Criptografia RSADocumento12 páginasMatemática e Criptografia RSAEvandro Oliveira0% (1)

- Manual Rolling Plus - Português Ver.3.1Documento31 páginasManual Rolling Plus - Português Ver.3.1Luis CatarinoAinda não há avaliações

- Relatório 1 - Tópicos Experimentais em MateriaisDocumento12 páginasRelatório 1 - Tópicos Experimentais em MateriaisDavid da MataAinda não há avaliações

- Instruções de Pagamento Pelo Internet Banking Ou CaixaDocumento1 páginaInstruções de Pagamento Pelo Internet Banking Ou CaixaCarlosAinda não há avaliações

- Passo A Passo - Como Montar e Desmontar Um ComutadorDocumento2 páginasPasso A Passo - Como Montar e Desmontar Um ComutadorValdecyr SantosAinda não há avaliações

- Danfe: SÉRIE 001 Página 1 de 1Documento1 páginaDanfe: SÉRIE 001 Página 1 de 1Cʜᴇғ Lᴜᴄɪᴀɴᴀ CᴇʀϙᴜᴇɪʀᴀAinda não há avaliações

- HTS6515Documento56 páginasHTS6515Wagner licciardi juniorAinda não há avaliações

- E-BOOK - 6-Funis-para-os-6-DígitosDocumento17 páginasE-BOOK - 6-Funis-para-os-6-DígitosLuis A Bc100% (1)

- Relatorio Pratica 03 - Ampop Comparadores IDocumento10 páginasRelatorio Pratica 03 - Ampop Comparadores IJunio BispoAinda não há avaliações

- (Padrão Documento - Word) Modelos de Termo de Referência e Projeto BásicoDocumento6 páginas(Padrão Documento - Word) Modelos de Termo de Referência e Projeto BásicoKennedy Duarte VieiraAinda não há avaliações

- (20170222204820) Criando Um App - CRONOMETRO-AppinventorDocumento24 páginas(20170222204820) Criando Um App - CRONOMETRO-AppinventorEdemir Silva100% (1)

- DD-WRT - Instalando e ConfigurandoDocumento15 páginasDD-WRT - Instalando e ConfigurandoslackmipsAinda não há avaliações

- Instruções de Instalação e Configuração Do Emulador Emul4200Documento12 páginasInstruções de Instalação e Configuração Do Emulador Emul4200Marcos ViniciosAinda não há avaliações

- O Que É A Lógica ParaconsistenteDocumento2 páginasO Que É A Lógica ParaconsistenteMarcos100% (2)

- Manual Pesagem Embarcada V 5 6Documento42 páginasManual Pesagem Embarcada V 5 6naltbnAinda não há avaliações

- Dimensionamento de Projetos Hidráulicos Com Software Com Tecnologia BIMDocumento1 páginaDimensionamento de Projetos Hidráulicos Com Software Com Tecnologia BIMJoão Fernandes JuniorAinda não há avaliações

- IM - Polidez LinguisticaDocumento172 páginasIM - Polidez LinguisticaAlba SimoneAinda não há avaliações

- Workshop NR 12Documento47 páginasWorkshop NR 12Rodolfo QuadrosAinda não há avaliações

- AmadeusDocumento2 páginasAmadeusapi-3813869Ainda não há avaliações

- 1512E Voucher E0055E 1005500043270Documento2 páginas1512E Voucher E0055E 1005500043270Leonardo Matte huffAinda não há avaliações

- Manual de Padroes Totvs DDKDocumento414 páginasManual de Padroes Totvs DDKElton Antunes100% (3)

- Gerenciamento de ChamadosDocumento21 páginasGerenciamento de ChamadosFelipeh MoraesAinda não há avaliações