Escolar Documentos

Profissional Documentos

Cultura Documentos

Aula 8

Enviado por

Marcos FavoretoTítulo original

Direitos autorais

Formatos disponíveis

Compartilhar este documento

Compartilhar ou incorporar documento

Você considera este documento útil?

Este conteúdo é inapropriado?

Denunciar este documentoDireitos autorais:

Formatos disponíveis

Aula 8

Enviado por

Marcos FavoretoDireitos autorais:

Formatos disponíveis

M. Eisencraft 4.

6 Distribuicao e densidade de uma soma de variaveis aleatorias57

Assim,

F

W

(w) =

_

+

_

wy

x=

f

X,Y

(x, y)dxdy (4.24)

e usando a Eq. (4.17),

F

W

(w) =

_

+

f

Y

(y)dy

_

wy

x=

f

X

(x)dx (4.25)

Diferenciando a Eq. 4.25 e usando a regra de Leibniz chega-se ` a funcao densidade desejada

f

W

(w) =

_

+

f

Y

(y)f

X

(w y)dy. (4.26)

Esta express ao e uma integral de convolucao. Consequentemente, mostrou-se que a fun c ao

densidade da soma de duas variaveis aleatorias estatsticamente independentes e a convolu c ao

das suas densidades individuais.

Exerccio 4.8. Calcule a densidade de W = X + Y em que as densidades de X e Y s ao,

respectivamente,

f

X

(x) =

1

a

[u(x) u(x a)] (4.27)

f

Y

(y) =

1

b

[u(y) u(y b)] (4.28)

com 0 < a < b.

4.6.2 Soma de diversas variaveis aleat orias

Quando deseja-se considerar a soma Y de N variaveis aleat orias X

1

, X

2

, ..., X

N

, pode-se

extender os resultados acima. Continuando o processo encontra-se que a funcao densidade de

Y = X

1

+ X

2

+ . . . + X

N

e a convolu cao das funcoes densidade individuais:

f

Y

(y) = f

X

N

(x

N

) f

X

N1

(x

N1

) f

X

1

(x

1

) . (4.29)

M. Eisencraft 4.7 Teorema do Limite Central 58

4.7 Teorema do Limite Central

De forma geral, o teorema do limite central diz que a funcao distribui cao de probabilidades da

soma de um grande n umero de VAs aproxima-se de uma distribui cao gaussiana.

Seja

X

i

e

2

X

i

as medias e variancias, respectivamente, de N variaveis aleat orias X

i

, i =

1, 2, . . . , N que podem ter densidades de probabilidade arbitrarias. O teorema do limite central

estabelece que a soma Y

N

= X

1

+X

2

+ +X

N

, que tem media

Y

N

=

X

1

+

X

2

+ +

X

N

e

variancia

2

Y

=

2

X

1

+

2

X

2

+ +

2

X

N

tem uma distribui cao de probabilidade que se aproxima

de uma gaussiana para N .

A import ancia pr atica do teorema do limite central nao reside tanto na exatid ao da dis-

tribuicao gaussiana quando N porque a variancia de Y

N

torna-se innita, mas sim no

fato de que Y

N

para N nito ter distribui cao muito pr oxima de uma gaussiana.

Exerccio 4.9. Use o Matlab

para tra car histogramas da variavel aleatoria Y = X

1

+ X

2

+

+X

N

, sendo que cada uma das VAs X

i

tem distribui cao uniforme no intervalo [0, 1]. Veja

o que ocorre para diversos valores de N.

Captulo 5

Operacoes sobre m ultiplas variaveis

aleat orias

Nessa se cao, estende-se o conceito de valor esperado para o caso de duas ou mais variaveis

aleat orias.

5.1 Valor esperado de uma funcao de variaveis aleatorias

O valor esperado de uma funcao de uma variavel aleat oria foi denido na Se cao 3.1 por

E [g(X)] =

_

g(x)f

X

(x)dx. (5.1)

Quando mais de uma variavel aleat oria e envolvida, o valor esperado deve ser tomado em

rela cao a todas as variaveis envolvidas. Por exemplo, se g(X, Y ) e uma funcao de duas variaveis

aleat orias X e Y , o valor esperado de g(., .) e dado por

g = E [g(X, Y )] =

_

g(x, y)f

X,Y

(x, y)dxdy. (5.2)

Para N variaveis aleat orias X

1

, X

2

, . . ., X

N

e uma funcao dessas variaveis denotada por

59

M. Eisencraft 5.1 Valor esperado de uma funcao de variaveis aleatorias 60

g(X1, . . . , X

N

), o valor esperado dessa funcao se torna:

g = E [g(X

1

, . . . , X

N

)] =

_

g(x

1

, . . . , x

N

)f

X

1

,...,X

N

(x

1

, . . . , x

N

)dx

1

. . . dx

N

. (5.3)

Um resultado que segue diretamente da deni cao acima e que o valor esperado de uma

soma ponderada de variaveis aleatorias

g (X

1

, . . . , X

N

) =

N

i=1

i

X

i

(5.4)

e a soma ponderada de seus valores medios:

g = E

_

N

i=1

i

X

i

_

=

N

i=1

i

E [X

i

] (5.5)

5.1.1 Momentos conjuntos em torno da origem

Uma importante aplicacao do valor esperado e na deni cao de momentos conjuntos em torno

da origem. Eles sao denotados por m

nk

e sao denidos por

m

nk

= E

_

X

n

Y

k

=

_

x

n

y

k

f

X,Y

(x, y)dxdy (5.6)

para o caso de duas variaveis aleat orias X e Y .

Claramente, m

n0

= E [X

n

] sao os momentos m

n

de X e m

0k

= E

_

Y

k

sao os momentos de

Y .

A soma n + k e chamada de ordem dos momentos. Assim, m

02

, m

20

e m

11

sao todos

momentos de segunda ordem de X e Y .

Os momentos de primeira ordem m

01

= E[Y ] = Y e m

10

= E[X] = X sao os valores

esperados de X e Y respectivamente e sao as coordenadas do centro de gravidade da funcao

f

X,Y

(x, y).

O momento de segunda ordem m

11

= E[XY ] e chamado de correla cao de X e Y . Ele e tao

M. Eisencraft 5.1 Valor esperado de uma funcao de variaveis aleatorias 61

importante que recebe um smbolo especial R

XY

. Assim,

R

XY

= m

11

= E[XY ] =

_

xyf

X,Y

(x, y)dxdy. (5.7)

Se a correla cao puder ser escrita na forma

R

XY

= E[X] E[Y ], (5.8)

entao X e Y sao ditas nao-correlacionadas.

A independencia estatstica de X e Y e suciente para garantir que elas sao nao-correlacionadas.

Porem, o contr ario nao e verdade em geral. Ou seja, independencia implica nao-correlac ao,

mas nao-correla cao nao implica independencia.

Se R

XY

= 0 as variaveis X e Y sao ditas ortogonais. Resumindo:

f

X,Y

(x, y) = f

X

(x) f

Y

(y) X e Y sao independentes

R

XY

= E[X] E[Y ] X e Y sao nao-correlacionadas

R

XY

= 0 X e Y sao ortogonais

X e Y sao independentes X e Y sao nao-correlacionadas

Exerccio 5.1. Seja X uma variavel aleatoria com valor medio X = E[X] = 3 e vari ancia

2

X

= 2 e uma outra variavel Y dada por Y = 6X + 22. Pede-se:

a E [X

2

]

b Y

c R

XY

d as variaveis sao correlacionadas?

e as variaveis sao ortogonais?

M. Eisencraft 5.1 Valor esperado de uma funcao de variaveis aleatorias 62

5.1.2 Momentos conjuntos centrais

Uma outra aplicacao importante da deni cao de valores esperado e a deni cao de momentos

centrais conjuntos. Para duas variaveis aleat orias X e Y , estes momentos denotados por

n,k

sao dados por:

nk

= E

_

_

X X

_

n

_

Y Y

_

k

_

=

_

_

x X

_

n

_

y Y

_

k

f

X,Y

(x, y)dxdy (5.9)

Os momentos centrais de segunda ordem

20

= E

_

_

X X

_

2

_

=

2

X

(5.10)

02

= E

_

_

Y Y

_

2

_

=

2

Y

(5.11)

(5.12)

sao as variancias de X e Y .

O momento conjunto de segunda ordem

11

e muito importante.

E chamado de co-vari ancia

de X e Y e simbolizado por C

XY

. Assim,

C

XY

=

11

= E

__

X X

_ _

Y Y

_

=

_

_

x X

_ _

y Y

_

f

X,Y

(x, y)dxdy. (5.13)

Expandindo-se o produto

_

X X

_ _

Y Y

_

esta integral se reduz a

C

XY

= R

XY

X Y = R

XY

E[X] E[Y ] (5.14)

Se X e Y forem independentes ou nao-correlacionadas, entao R

XY

= E[X]E[Y ] e C

XY

= 0.

Se X e Y forem ortogonais, entao C

XY

= E[X] E[Y ]. Claramente, C

XY

= 0 se X ou Y

tambem tiverem media nula alem de serem ortogonais.

M. Eisencraft 5.2 Func oes caractersticas conjuntas 63

O momento de segunda ordem normalizado

=

11

20

02

=

C

XY

Y

(5.15)

e conhecido como coeciente de correla cao de X e Y . Pode-se mostrar [1] que 1 1.

Uma aplicacao direta das deni coes acima e que se X e uma soma ponderada de variaveis

aleat orias X

i

, X =

N

i=1

i

X

i

, entao

E[X] =

N

i=1

i

X

i

(5.16)

2

X

=

N

i=1

2

i

2

X

i

. (5.17)

Exerccio 5.2. [1] Num sistema de controle, sabe-se que uma tensao aleatoria X tem media

X = m

1

= 2V e momento de segunda ordem X

2

= m

2

= 9V

2

. Se a tensao X e amplicada

por um amplicador que fornece como sada Y = 1,5X +2, encontre

2

X

, Y , Y

2

,

2

Y

e R

XY

.

5.2 Func oes caractersticas conjuntas

A fun cao caracterstica conjunta de duas VAs X e Y e denida por

X,Y

(

1

,

2

) = E

_

e

j

1

X+j

2

Y

(5.18)

em que

1

e

2

sao n umeros reais. Uma forma equivalente e

X,Y

(

1

,

2

) =

_

f

X,Y

(x, y)e

j

1

x+j

2

y

dxdy. (5.19)

Esta express ao e a transformada de Fourier bidimensional (com os sinais de

1

e

2

trocados)

[3].

Fazendo

2

= 0 ou

1

= 0 na Eq. (5.19), a funcao caracterstica de X ou Y e obtida,

M. Eisencraft 5.2 Func oes caractersticas conjuntas 64

respectivamente. Sao as chamadas fun coes caractersticas marginais:

X

(

1

) =

X,Y

(

1

, 0) (5.20)

Y

(

2

) =

X,Y

(0,

2

) (5.21)

Os momentos conjuntos m

nk

podem ser encontrados a partir da funcao caracterstica con-

junta por:

m

nk

= (j)

n+k

n+k

X,Y

(

1

,

2

)

n

1

k

2

1

=0,

2

=0

(5.22)

Esta express ao e a generaliza cao bidimensional da Eq. (3.16).

Exerccio 5.3. Duas variaveis aleatorias X e Y tem fun cao caracterstica conjunta

X,Y

(

1

,

2

) = exp

_

2

2

1

8

3

2

_

(5.23)

Mostre que X e Y tem media nula e que elas sao nao correlacionadas.

Referencias Bibliogracas

[1] P. Z. P. Jr., Probability, Random Variables And Random Signal Principles, 4th ed. New

York: Mcgraw-Hill, 2001.

[2] B. P. Lathi, Modern Digital and Analog Communication Systems, 3rd ed. New York, NY,

USA: Oxford University Press, Inc., 1998.

[3] A. V. Oppenheim, A. S. Willsky, and S. H. Nawab, Sinais e sistemas, 2nd ed. Sao Paulo:

Pearson Prentice Hall, 2010.

65

Você também pode gostar

- Monitor Signos Cardiocap-Manual-do-usuarioDocumento48 páginasMonitor Signos Cardiocap-Manual-do-usuarioJuan P SalazarAinda não há avaliações

- Aula 2 Pneumática Circuitos BásicosDocumento66 páginasAula 2 Pneumática Circuitos BásicosAntonio R S CruzAinda não há avaliações

- Projeto Integrado de Programação e OrganizaçãoDocumento11 páginasProjeto Integrado de Programação e OrganizaçãoAirdrops Andrel100% (1)

- Atividade Caca Ao TesouroDocumento10 páginasAtividade Caca Ao TesouroLUIS VICENTE FerreiraAinda não há avaliações

- Mca501 - Avaliativa Sem1 UnivespDocumento2 páginasMca501 - Avaliativa Sem1 Univespfelipeaugusto.cba2023Ainda não há avaliações

- BiomecanicaDocumento14 páginasBiomecanicarosario cristoAinda não há avaliações

- Unid. II - Tecnologia Da InformaçãoDocumento7 páginasUnid. II - Tecnologia Da InformaçãoLuiz Felipe Campos100% (2)

- Idm144 (N00391)Documento5 páginasIdm144 (N00391)Diego CordovaAinda não há avaliações

- Manual Mesa Ui24R PTDocumento138 páginasManual Mesa Ui24R PTMarcelo RosaAinda não há avaliações

- Possibilidades Tecnológicas Utilizando o AVA Moodle para Garantia Da Aprendizagem SignificativaDocumento19 páginasPossibilidades Tecnológicas Utilizando o AVA Moodle para Garantia Da Aprendizagem SignificativaEvaldo BerangerAinda não há avaliações

- Prova Do Eixo VI A e BDocumento3 páginasProva Do Eixo VI A e BAllana De Carvalho SilvaAinda não há avaliações

- Tec Seguranca TrabalhoDocumento16 páginasTec Seguranca Trabalhojfn29Ainda não há avaliações

- Ceeja 2021 1Documento28 páginasCeeja 2021 1Luis Fernando FerreiraAinda não há avaliações

- MODULAÇÃO PCM MULTIPLEXAÇÃO PDH SDH OTN 05072020Documento52 páginasMODULAÇÃO PCM MULTIPLEXAÇÃO PDH SDH OTN 05072020Alan LopesAinda não há avaliações

- Documento 123000000 TDDocumento11 páginasDocumento 123000000 TDthe bestAinda não há avaliações

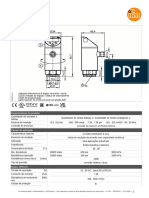

- Sensor de Pressão Com Display: PN-+,5BRER14-MFRKG/US/ /VDocumento5 páginasSensor de Pressão Com Display: PN-+,5BRER14-MFRKG/US/ /VIvan FerreiraAinda não há avaliações

- Cap 7 Lab 7.4.7-Lab - Install-The-Virtual-Machine - PT-BRDocumento5 páginasCap 7 Lab 7.4.7-Lab - Install-The-Virtual-Machine - PT-BREdmar BrasilAinda não há avaliações

- TICs Na FísicaDocumento8 páginasTICs Na FísicaAlfonso Bianchini LückemeyerAinda não há avaliações

- Arquivo 82 201912200930125dfcbed451f84Documento2 páginasArquivo 82 201912200930125dfcbed451f84Mateus SantosAinda não há avaliações

- Projeto de Abertura Da Nova Filial Da Escola de Idiomas BBTDocumento5 páginasProjeto de Abertura Da Nova Filial Da Escola de Idiomas BBTSabrina CaetanoAinda não há avaliações

- Lista04 VetoresDocumento3 páginasLista04 VetoresMaicom RezaAinda não há avaliações

- Ficha para Solicitação de Assistência Domiciliar Multiprofissional Do NasfDocumento1 páginaFicha para Solicitação de Assistência Domiciliar Multiprofissional Do NasfginoarrunateguiAinda não há avaliações

- Template - Situação de Aprendizagem 02Documento4 páginasTemplate - Situação de Aprendizagem 02kelyAinda não há avaliações

- Tabela Alarme ST2080 v110Documento7 páginasTabela Alarme ST2080 v110BJNE01Ainda não há avaliações

- SC-900Documento5 páginasSC-900Luiz ggiziAinda não há avaliações

- Curso Niosh by OcraDocumento2 páginasCurso Niosh by OcraRafael Moreira CassianoAinda não há avaliações

- MDH001N - 016N - 020N 90 240vca P299 PDFDocumento2 páginasMDH001N - 016N - 020N 90 240vca P299 PDFLuciano CesarAinda não há avaliações

- TV Globo - Boletim de Informação para Publicitários - Nº 570Documento8 páginasTV Globo - Boletim de Informação para Publicitários - Nº 570Bernardo von FlachAinda não há avaliações

- ISO IEC 27005 - Gestão de Riscos TIDocumento97 páginasISO IEC 27005 - Gestão de Riscos TIcrisverona95% (19)

- Kit Inicial 2013-FiskDocumento5 páginasKit Inicial 2013-Fiskhnet0% (2)