Escolar Documentos

Profissional Documentos

Cultura Documentos

GE - Fundamentos em Data Science - Unidade III - DIGITAL PAGES

Enviado por

JeanSilvaDescrição original:

Título original

Direitos autorais

Formatos disponíveis

Compartilhar este documento

Compartilhar ou incorporar documento

Você considera este documento útil?

Este conteúdo é inapropriado?

Denunciar este documentoDireitos autorais:

Formatos disponíveis

GE - Fundamentos em Data Science - Unidade III - DIGITAL PAGES

Enviado por

JeanSilvaDireitos autorais:

Formatos disponíveis

Objetivos da unidade

Aprender a fazer cortes em sensibilidade e especificidade;

Apresentar a NumPy;

Aprender a fazer cálculos de probabilidades;

Conhecer estratégias de mineração de textos e TF-IDF;

Compreender desvio padrão e valor esperado.

Tópicos de estudo

Visualização do desempenho do Engenharia analítica

modelo Desvio padrão

Cortes em curva Roc Criação de um robô captando inte-

Armazenamento de dados em resse através de dados

NumPy para aplicar análises

Evidências e probabilidades

Localizando evidências na prática

Representação e mineração de

textos;

IDF e TF-IDF em bag of words

Cálculos de IDF e TF-IDF para pon-

deração de TF

FUNDAMENTOS EM DATA SCIENCE 73

eBook da Unidade 3 – Fundamentos em Data Science.indd 73 26/03/19 14:48

Visualização do desempenho do modelo

O objetivo, nessa etapa, é definir um ponto de corte para análises de resultados. O

Gráfico 1 é usado como exemplo, e representa um ponto de corte no qual existe um limite

mediano entre bons pagadores e maus pagadores. Para isso, teremos aplicação prática em

SPSS para criar esse limite.

GRÁFICO 1. PONTO DE CORTE

%

MAUS BONS

PAGADORES PAGADORES

PONTO DE CORTE

0 5 10 15 20 25 30 35 40 45 50 55 60

PONTOS

Fonte. BORGES, et al. 2017, p. 273. (Adaptado).

Após isso, teremos mais conceitos de programação em Python com NumPy, a fim de trazer

mais contato com a linguagem.

Cortes em curva Roc

A curva Roc (receptor de operação) foi criada em torno de 1950 e era usada para sinais

em radares, mas evoluiu para aplicações em medicina, para lidar com diagnósticos. A pro-

posta de entender a curva Roc e o corte para, consequentemente, obter mais certezas,

será realizada no SPSS.

Para fazer a curva Roc é útil lembrar os conceitos de matriz de confusão e análise de

sensibilidade. Após realizar uma análise com treinamento de vizinhos e aplicar em um tes-

te, pode-se fazer a matriz de confusão para descobrir a sensibilidade e a especificidade,

conforme Diagrama 1.

FUNDAMENTOS EM DATA SCIENCE 74

eBook da Unidade 3 – Fundamentos em Data Science.indd 74 26/03/19 14:48

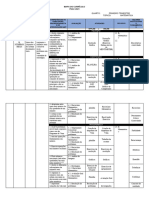

DIAGRAMA 1. RELEMBRANDO MATRIZ DE CONFUSÃO

ANÁLISE DE K = 3

Previsto

Sensibilidade é mostrar a probabilidade de um teste dar positivo

POSITIVO NEGATIVO

VP 2

SENSIBILIDADE = = = 0,66 (66%)

VP + FN 3

Realidade

2

POSITIVO

(verdadeiro positivo)

Especificidade é mostrar a probabilidade de um teste dar negativo

1 1

NEGATIVO

(falso positivo) (verdadeiro negativo)

VN 1

ESPECIFICIDADE = = = 0,5 (50%)

VN + FP 2

Agora, vamos fazer um exercício voltado para compreensão de corte em SPSS. A Fig. 1

mostra a criação de variáveis no SPSS. Comece clicando no canto inferior da esquerda, em

visualização de variáveis.

Mudar para visualização de variável, adicionar dados

na linha1 e acrescentar valores 0 e 1 para sim

Acrescentar dados

Figura 1. Inserindo variáveis.

FUNDAMENTOS EM DATA SCIENCE 75

eBook da Unidade 3 – Fundamentos em Data Science.indd 75 26/03/19 14:48

Conforme a Fig. 2, insira as variáveis, sendo Platinum a saída; pontos_antecipação tendo

uma relação de quanto maior, melhor; e pontos_atraso, quanto menor, melhor, ou mais

chance de ser Platinum.

A maioria dos Pontos_Antecipação maiores que 8 dão

positivo, exceto a linha 8

Figura 2. Inserindo registros.

A seguir, criaremos um gráfico Roc e destinaremos Platinum como saída, sendo 1 igual a sim.

Clicar em curva e acionar Platinum com 1, indicando que

quem é Platinum será reconhecido com 1(sim)

Figura 3. Destinação de Platinum.

FUNDAMENTOS EM DATA SCIENCE 76

eBook da Unidade 3 – Fundamentos em Data Science.indd 76 26/03/19 14:49

n

Pontos_antecipação segue a lógica de quanto maior,

menor, e irá se tornar uma entrada na Fig. 4.

Assinalar os campos mostrados, pois quanto mais

antecipação, mais perto do 1 ficará

Figura 4. Colocando pontos_antecipação como entrada.

O próprio programa já faz uma estimativa de sensibilidade e especificidade, conforme os da-

dos da linha estejam ou não fazendo sentido. Por exemplo, a linha 9 fugia da lógica, pois possuía

9 pontos_antecipação e não tornou o cliente Platinum. Isso gerou uma confusão, e por isso a

figura mostra que valores maiores que 8,5 tem sensibilidade (probabilidade de dar positivo) 50%

(0,500) e especificidade 9 (probabilidade de dar negativo) de 25% (0,250).

A seguir, será gerado um relatório com tabelas que mostrarão dados de sensibilidade e es-

pecificidade. A explicação está na própria imagem.

Valor 5 pode dar negativo ou positivo

Valor igual ou maior que 7 tem

a probabilidade de dar positivo

(1,000 positivo x 0,250 negativo)

Valor maior que 8,50 quase empa-

ta, pois dos três 9 que aparecem,

dois resultam em sim e um em não

(0,500 positivo x 0,250 negativo)

Figura 5. Sensibilidade e especificidade de pontos_antecipação.

Agora iremos fazer o mesmo procedimento com pontos_atraso, conforme a Fig. 6. Porém,

observe a notação em laranja de quanto menor, mais probabilidade de dar positivo, pois são

pontos em atraso. Clique em redefinir, conforme a linha amarela.

FUNDAMENTOS EM DATA SCIENCE 77

eBook da Unidade 3 – Fundamentos em Data Science.indd 77 26/03/19 14:49

Clicar em analisar, curvas Roc

Passar pontos_atraso e mudar as opções, pois

quanto menor os pontos_atraso, mais positivo será

Figura 6. Gerando relatório de pontos_atraso.

Será gerado um relatório primeiro com dados de pontos_antecipação e depois com pon-

tos_atraso, conforme Fig. 7, que demonstra uma comparação, e nas tabelas abaixo do gráfico,

mostra a probabilidade de dar positivo (sensibilidade) ou negativo (especificidade) por faixas

de valor para cada linha.

pontos_antecipação pontos_atraso

Mais sensibilidade

Figura 7. Comparação de resultados.

FUNDAMENTOS EM DATA SCIENCE 78

eBook da Unidade 3 – Fundamentos em Data Science.indd 78 26/03/19 14:49

Agora veremos como fazer um corte. Há um ponto de intersecção em que a probabilidade

de dar sim é alta. E para isso, faremos alguns cálculos, que traçam um ponto seguro de dar sim

nas duas colunas, ao mesmo tempo (pontos_atraso e pontos_antecipação).

A primeira coisa a fazer é passar as tabelas da Fig. 7 para o Excel, conforme Fig. 8.

Figura 8. Passando coordenadas da curva.

Após ter feito isso, iremos fazer um cálculo para descobrir ponto de corte, cuja fórmula é:

Observe, na Fig. 9, que ao invés de usar o número, usou-se C3, C4, C5, D3, D4 etc. Esses são

endereços no Excel para agilizar o cálculo.

Figura 9. Executando cálculos para gerar resultados que levam a linha de corte.

FUNDAMENTOS EM DATA SCIENCE 79

eBook da Unidade 3 – Fundamentos em Data Science.indd 79 26/03/19 14:49

O próximo passo é gerar um gráfico com base nos resultados, conforme Fig. 10.

1 - Selecionar a coluna 2 - Gerar gráfico de linha na guia inserir

Figura 10. Gerar gráfico.

Agora, ao pausar o mouse sobre os dois pontos mais altos, você terá os valores contidos na

tabela de coordenadas de curvas, conforme Fig. 11.

Figura 11. Pontos mais altos do gráfico.

FUNDAMENTOS EM DATA SCIENCE 80

eBook da Unidade 3 – Fundamentos em Data Science.indd 80 26/03/19 14:49

Só resta, então, analisar na tabela de entradas qual é o ponto de corte, gerando sim ou não,

conforme Fig. 12.

O valor 7 tem 100% de sensibilidade em pontos_antecipa-

ção com baixa probabilidade de dar não (25%)

O valor 3 tem 83% de sensibilidade em pontos_atraso e

nada de especificidade, ou seja, 7 e 3 são os valores de

corte

1 2

100% Sensibilidade 83% Sensibilidade

25% Espeficidade 0% Espeficidade

Figura 12. Pontos de corte.

FUNDAMENTOS EM DATA SCIENCE 81

eBook da Unidade 3 – Fundamentos em Data Science.indd 81 26/03/19 14:50

Armazenamento de dados em NumPy para aplicar

análises

Além de saber realizar análises estatísticas, é necessário saber armazenar dados. Para

fazer os exercícios aqui propostos, realize três ações:

• Digite pip install numpy no cmd para instalar NumPy;

• Digite jupyter-notebook no cmd para abrir o jupyter;

• Crie um novo arquivo python 3.

As matrizes são tabelas multidimensionais e podem ser criadas a partir de vetor. Vetores

e matrizes podem ter números, strings (textos entre aspas) e valores booleanos (True ou

False).

Caso o programador ou data scientist queira abrir uma nova página, é necessário digitar

import numpy as np.

ASSISTA

O vídeo do youtube Introdução ao Numpy – Primeiros Passos, com o link

nas referências bibliográficas, mostra como baixar um arquivo pronto com

os códigos contidos aqui e como executar no jupyter-notebook.

O exemplo a seguir demonstra a criação de quatro vetores e, então, a criação de uma

matriz com quatro linhas e quatro colunas.

In[13]:

gabriel_gostos=[‘vídeo game’,’cinema’,’tecnologia’,’livros’]

marcio_gostos=[‘futebol’,’natação’,’golfe’,’hipismo’]

juliana_gostos=[‘gastronomia’,’viagem’,’cinema’,’teatro’]

daniela_gostos=[‘caminhada’,’livros’,’séries’,’desenho digital’]

mostrar_gostos=np.array([gabriel_gostos,marcio_gostos,juliana_gostos,daniela_gostos])

mostrar_gostos

Out[13]:

array([[‘vídeo game’, ‘cinema’, ‘tecnologia’, ‘livros’],

[‘futebol’, ‘natação’, ‘golfe’, ‘hipismo’],

[‘gastronomia’, ‘viagem’, ‘cinema’, ‘teatro’],

[‘caminhada’, ‘livros’, ‘séries’, ‘desenho digital’]], dtype=’<U15’)

FUNDAMENTOS EM DATA SCIENCE 82

eBook da Unidade 3 – Fundamentos em Data Science.indd 82 26/03/19 14:50

Para demonstrar apenas a linha 1, basta citar o número 0, conforme exemplo a seguir, que

mostrará os gostos do Gabriel.

In[14]: mostrar_gostos[0]

Out[14]:array([‘vídeo game’, ‘cinema’, ‘tecnologia’, ‘livros’], dtype=’<U15’)

O exemplo a seguir conta cinco itens da esquerda para a direita, começando pelo 0

(zero).

In[15]: mostrar_gostos.item(5)

Out[15]:’natação’

Para demonstrar a segunda linha (1) e a primeira coluna (0), basta digitar o código a

seguir:

In[16]: mostrar_gostos[1][0]

Out[16]:’futebol’

É possível, contudo, criar listas e exibir como matriz, sem utilizar palavra reservada

como ocorreu em In[14]:, onde foi criada a variável mostrar_gostos. A seguir, vamos ter

dois exemplos, o primeiro com o comando np.array e o segundo, só com as listas. Ambos

têm o mesmo resultado.

In[17]:

marketing_janeiro=[‘5 cartazes’,’3 banners’,’3 malas diretas’]

marketing_fevereiro=[‘2 promoções’,’3 spots’,’4 banners’]

marketing_marco=[‘2 jingles’,’3 promoções’,’3 banners’]

np.array([marketing_janeiro,marketing_fevereiro,marketing_marco])

Out[17]:

array([[‘5 cartazes’, ‘3 banners’, ‘3 malas diretas’],

[‘2 promoções’, ‘3 spots’, ‘4 banners’],

[‘2 jingles’, ‘3 promoções’, ‘3 banners’]], dtype=’<U15’)

A seguir, é criada a matriz sem np.array.

FUNDAMENTOS EM DATA SCIENCE 83

eBook da Unidade 3 – Fundamentos em Data Science.indd 83 26/03/19 14:50

In[18]:

marketing_janeiro=[‘5 cartazes’,’3 banners’,’3 malas diretas’]

marketing_fevereiro=[‘2 promoções’,’3 spots’,’4 banners’]

marketing_marco=[‘2 jingles’,’3 promoções’,’3 banners’]

[marketing_janeiro,marketing_fevereiro,marketing_marco])

Out[18]:

array([[‘5 cartazes’, ‘3 banners’, ‘3 malas diretas’],

[‘2 promoções’, ‘3 spots’, ‘4 banners’],

[‘2 jingles’, ‘3 promoções’, ‘3 banners’]], dtype=’<U15’)

Será demonstrado, então, como criar uma faixa (range) com o comando np.range e de-

pois, será demonstrado como dividir faixas em quatro linhas e duas colunas com o comando

np.reshape. O exemplo a seguir mostra a range de 0 até 8.

In[19]: criar_range=np.arange(0,8)

print(criar_range)

Out[19]: [0 1 2 3 4 5 6 7]

Segue, portanto, a divisão com o np.reshape.

In[20]: dividir = np.reshape(criar_range, (2,4))

print(dividir)

Out[20]:

[[0 1 2 3]

[4 5 6 7]]

Outra ação que o NumPy faz em array é remover e deletar linhas ou colunas. A sintaxe np.

delete(nome_da_matriz, 0, 1), por exemplo, deletaria a primeira coluna. Já a sintaxe np.dele-

te(nome_da_matriz, 2, 0) deletaria a segunda linha, conforme o exemplo a seguir.

In[21]

gabriel_gostos = [‘vídeo game’, ‘cinema’,’tecnologia’,’livros’]

marcio_gostos = [‘futebol’, ‘natação’,’golfe’,’hipismo’]

juliana_gostos = [‘gastronomia’, ‘viagem’,’cinema’,’teatro’]

daniela_gostos = [‘caminhada’, ‘livros’,’séries’,’desenho digital’]

FUNDAMENTOS EM DATA SCIENCE 84

eBook da Unidade 3 – Fundamentos em Data Science.indd 84 26/03/19 14:50

mostrar_gostos = np.array([gabriel_gostos, marcio_gostos, juliana_gostos, daniela_gostos])

mostrar_gostos

Out[21]:

array([[‘vídeo game’, ‘cinema’, ‘tecnologia’, ‘livros’],

[‘futebol’, ‘natação’, ‘golfe’, ‘hipismo’],

[‘gastronomia’, ‘viagem’, ‘cinema’, ‘teatro’],

[‘caminhada’, ‘livros’, ‘séries’, ‘desenho digital’]], dtype=’<U15’)

Note agora que a linha 2, referente à gastronomia etc., será deletada:

In[22]:np.delete(mostrar_gostos,2,0)

Out[22]:

array([[‘vídeo game’, ‘cinema’, ‘tecnologia’, ‘livros’],

[‘futebol’, ‘natação’, ‘golfe’, ‘hipismo’],

[‘caminhada’, ‘livros’, ‘séries’, ‘desenho digital’]], dtype=’<U15’)

Para deletar a linha 1 e a linha 3, o programa percorrerá do 0 (será :) até o 2 (que será a terceira linha).

In[23]:np.delete(mostrar_gostos,np.s_[::2],0)

Out[23]:

array([[‘futebol’, ‘natação’, ‘golfe’, ‘hípismo’],

[‘caminhada’, ‘livros’, ‘séries’, ‘desenho digital’]], dtype=’<U15’)

Antes de abordar a inserção de dados, é necessário explicar a diferença entre axis = 0 e axis

= 1. Enquanto axis 0 é linha, axis 1 é coluna. Dessa forma, a sintaxe np.insert(mostrar_gos-

tos,1,’vazio’,axis=0) está dizendo que o eixo (axis=0) a ser utilizado será de linhas e não colunas.

Sendo assim, resta explicar os outros dados. O valor 1 representa a segunda linha (pois a pri-

meira é o zero), e a palavra ‘vazio’ representa a substituição na linha 1.

In[24]:np.insert(mostrar_gostos,1,’vazio’,axis=0)

Out[24]:

Array([[‘video game’, ‘cinema’, ‘tecnologia’, ‘livros’],

[‘vazio’, ‘vazio’, ‘vazio’, ‘vazio’],

[‘futebol’, ‘natação’, ‘golfe’, ‘hipismo’],

[‘gastronomia’, ‘viagem’, ‘cinema’, ‘teatro’],

[‘caminhada’, ‘livros’, ‘séries’, ‘desenho digital’]], dtype=’<U15’)

FUNDAMENTOS EM DATA SCIENCE 85

eBook da Unidade 3 – Fundamentos em Data Science.indd 85 26/03/19 14:50

Evidências e probabilidades

Neste momento, nos concentraremos no estudo de probabilidades e evidências. Para

isso, usaremos técnicas de classificação de Naive Bayes, que foram criadas com base no

Teorema de Bayes. Essa forma de classificação é útil para discernir textos e é muito usada

em Machine Learn. Por exemplo:

• Separação entre e-mail e spam;

• No Gmail, por exemplo, e-mails promocionais vão para uma caixa diferente da caixa de

entrada principal;

• Separação de emoções;

• Separação de documentos por tema.

Localizando evidências na prática

A equação usada foi baseada no Teorema de Bayes.

A Tabela 1 é uma tabela de compras, mas poderia ser de curtidas no Facebook, por exemplo:

quem curtiu pertence a que classe? É jovem ou adulto? Bebe ou não?

TABELA 1. DECISÃO DE COMPRA E ATRIBUTO

CLASSE SOCIAL ESTADO CIVIL FILHOS COMPRAR CARRO?

MÉDIA SOLTEIRO SIM SIM

BAIXA CASADO NÃO NÃO

ALTA DIVORCIADO NÃO SIM

MÉDIA SOLTEIRO NÃO SIM

MÉDIA CASADO SIM NÃO

ALTA SOLTEIRO NÃO NÃO

BAIXA CASADO SIM SIM

BAIXA CASADO SIM NÃO

FUNDAMENTOS EM DATA SCIENCE 86

eBook da Unidade 3 – Fundamentos em Data Science.indd 86 26/03/19 14:50

A Tabela 2 isola o item classe social e compras, pois o ideal é analisar classe por classe.

TABELA 2. ANÁLISE DE SAÍDA POR CLASSE SOCIAL

CLASSE SOCIAL COMPRAR CARRO?

MÉDIA SIM

BAIXA NÃO

ALTA SIM

MÉDIA SIM

MÉDIA NÃO

ALTA SIM

BAIXA SIM

BAIXA NÃO

A Tabela 3 contém cores para facilitar o entendimento do cálculo, uma vez que, com os da-

dos em mãos, basta aplicar a teoria aqui contida nos dados da empresa e terá a probabilidade,

classe por classe.

TABELA 3. CÁLCULOS DE DECISÕES POR CLASSE

CLASSE SOCIAL Não Sim

BAIXA 2 1 =3/8 0,375

MÉDIA 1 2 =3/8 0,375

ALTA 1 1 =2/8 0,25

Total 4 4

4/8 4/8

0,5 0,5

Quem é de classe alta compra carro (sim) com qual probabilidade?

FUNDAMENTOS EM DATA SCIENCE 87

eBook da Unidade 3 – Fundamentos em Data Science.indd 87 26/03/19 14:50

A P (alta sim total de sim) x P (total de sim total de linhas)

P =

B P (total de classe alta total de linhas)

SIM P (1 4) x P (4 8) 0,25 x 0,5

P = = = 0,5 ou 50% de chance de dar sim em classe alta

ALTA P (2 8) 0,25

Quem é classe média compra carro (sim) com qual probabilidade?

A P (média sim total de sim) x P (total de sim total de linhas)

P =

B P (total de classe média total de linhas)

SIM P (2 4) x P (4 8) 0,5 x 0,5

P = = = 0,67 ou 67% de chance de dar sim em classe média

MÉDIA P (3 8) 0,375

Quem é classe baixa compra carro (sim) com qual probabilidade?

A P (baixa sim total de sim) x P (total de sim total de linhas)

P =

B P (total de classe baixa total de linhas)

SIM P (1 4) x P (4 8) 0,25 x 0,5

P = = = 0,34 ou 34% de chance de dar sim em classe baixa

BAIXA P (3 8) 0,375

Após fazer esses cálculos, deve-se refazer com as colunas “estado civil” e “filhos”, tendo,

assim, uma análise geral de probabilidade.

As vantagens das técnicas de Naive Bayes é que tudo é feito de ma-

neira rápida e testa várias classes. A principal desvantagem é o fato

de que se analisam probabilidades momentâneas e separadas,

sendo necessário complementar com outras técni-

cas preditivas. Cabe citar que, na área de filtro de

textos, ele é bem eficaz. Ao analisar textos, ele

consegue detectar bem os gostos principais

dos usuários, sendo assim, é útil em sistemas

de aprendizado de máquina e spam.

FUNDAMENTOS EM DATA SCIENCE 88

eBook da Unidade 3 – Fundamentos em Data Science.indd 88 26/03/19 14:50

Representação e mineração de textos

Palavras, em mineração de texto, são chamadas por token. Elas refletem emoções e trazem ver-

dades. Em mineração de texto, documentos representam tanto artigos, e-mails, opiniões e comen-

tários, quanto avaliações de cinco estrelas. Para avaliar palavras importantes, deve-se excluir pa-

lavras stop word, que são palavras sem significado, como “e”, “ou” e etc. Palavras raras geralmente

são dispensadas, e todas precisam estar em formatação igual, ou seja, todas em letras minúsculas.

Uma boa análise coloca limites máximos e mínimos ao fazer um filtro de palavras.

Segundo Marzagão (s. d., p. 11), deve-se:

• Identificar automaticamente o autor de um documento (classificação);

• Agrupar um conjunto de documentos por autores ou tópicos (clusterização).

IDF e TF-IDF em bag of words

Bag of words são multiconjuntos de palavras. Nesses conjuntos, para entender Frequência de Ter-

mos (TF), pode-se analisar essa afirmação: “O peso de um termo que ocorre em um documento é di-

retamente proporcional à sua frequência” (NOLASCO; OLIVEIRA, 2016, p. 17), mas há palavras que se

repetem mais em um texto e menos em outros. A seguir, temos uma análise de quatro documentos:

DIAGRAMA 2. ANÁLISE DE QUATRO DOCUMENTOS

Pessoas que praticam corrida ou outros esportes e consomem pouco sal, tem menos

1

chance de ter problemas de coração e pressão alta.

Hábitos saudáveis como dormir cedo, ou ter rotina regular para dormir, praticar

2 esportes como corrida, por exemplo, fazem pessoas mais saudáveis e com menos

DOCUMENTOS

probabilidade de ter problemas de coração.

3 A saúde está ligada à boa alimentação e disciplina para dormir.

4 Pessoas com problemas de pressão alta precisam comer menos sal.

FUNDAMENTOS EM DATA SCIENCE 89

eBook da Unidade 3 – Fundamentos em Data Science.indd 89 26/03/19 14:50

Agora, a Tabela 4, a seguir, faz a contagem dessas repetições, ou seja, dos tokens nos

quatro documentos:

TABELA 4. REPETIÇÕES DE PALAVRAS

Pressão

Coração Sal Corrida Dormir Esportes Hábitos

Alta

Documento 1 1 1 1 1 1 1

Documento 2 1 1 2 1 1

Documento 3 1

Documento 4 1 1

Se temos oito documentos e em dois deles, um token se repete por três ou quatro vezes, ele

é importante nesses dois documentos dentre os oito. Ou seja, sendo frequente uma palavra

em um texto e não aparecendo nos outros, ela se torna mais importante para o documento

que a tem e menos significante para a coleção. Para isso utiliza-se o IDF (frequência inversa do

documento).

Para resumir:

• TERMO DE FREQUÊNCIA (TF) = repetições de um token no documento

NÚMERO TOTAL DE DOCUMENTOS

• IDF DE TOKEN = LOG 2

NÚMERO DE DOCUMENTOS CONTENDO O TOKEN

Pode-se calcular o TF-IDF e aplicar distância Euclidiana para descobrir vizinhos mais próxi-

mos. Sendo que:

TFIDF de um token = TF × IDF

Cálculos de IDF e TF-IDF para ponderação de TF

Para facilitar, vamos usar um exemplo de análises em documentos, supondo que temos

uma coleção de documentos. Em um documento dentro dessa coleção, por exemplo, em

um artigo, aparecem as palavras abaixo com as seguintes frequências:

• Em um documento analisado: Corrida (três vezes), Esportes (duas vezes), Academia (uma vez);

• A frequência dos termos normalizada, que objetiva remover diferenças sutis, é dita

pela fórmula:

FUNDAMENTOS EM DATA SCIENCE 90

eBook da Unidade 3 – Fundamentos em Data Science.indd 90 26/03/19 14:50

Frequência

tf normalizada =

(número máximo de frequência do documento)

tf normalizada corrida = 3/3

tf normalizada esportes = 2/3

tf normalizada academia = 1/3

Na coleção, existem dez documentos. Ao analisar a frequência dessas palavras na coleção

inteira, tem-se:

• Na coleção: Corrida (ocorre em cinco documentos), Esportes (ocorre em sete documen-

tos), Academia (ocorre em dez documentos).

Agora será feito o cálculo TF-IDF:

Análise de Corrida:

• Corrida:

• TF = 3 vezes 3 (frequência máxima) = 1

• IDF = log2 (10 documentos 5 repetições de corrida)

• IDF = log2 (2)

• IDF = 1

• TF - IDF = TF x IDF = 1 x 1 = 1

A importância da palavra corrida nesse documento para o conjunto é de 1. Leia os demais

tópicos para entender.

Análise de Esportes:

• Esportes:

• TF = 2 vezes 3 (frequência máxima) = 0,66

• IDF = log2 (10 documentos 7 repetições de esportes)

• IDF = log2 (1,42)

• IDF = 0,5

• TF - IDF = TF x IDF = 0,66 x 0,5 = 0,33

A importância da palavra esportes nesse documento, em comparação com o conjunto, é de

0,33. Continue lendo para entender.

Análise de Academia:

• Academia

• TF = 1 vez 3 (frequência máxima) = 0,33

• IDF = log2 (10 documentos 10 repetições de academia)

• IDF = log2 (1)

• IDF = 0

• TF - IDF = TF x IDF = 0,33 x 1= 0,33

FUNDAMENTOS EM DATA SCIENCE 91

eBook da Unidade 3 – Fundamentos em Data Science.indd 91 26/03/19 14:50

A importância da palavra academia nesse documento, em comparação com o conjunto,

é de 0,33 (igual a esportes), pois ainda que tivesse menos em um documento, havia mais na

coleção. Assim, ao invés de ser menos importante, ela é igualmente importante à palavra

esportes.

DICA

Para fazer os cálculos a seguir, sugere-se digitar no Google: “Log Base 2 Calculator”.

Assim, você terá opções de calculadoras on-line para facilitar o processo.

Em outras palavras, TF-IDF é destinado à normalização. Com isso, supondo que você

tem um site e deseja criar conteúdo mais exclusivo para uma matéria numa subpágina,

você irá, por exemplo, analisar os comentários, e fará o estudo proporcional normalizado

dessa subpágina, comparando as palavras-chaves com o site inteiro. O que der valor maior

naquela subpágina, mesmo normalizando com o Log do IDF, será, de fato, o conteúdo mais

adequado a ser postado, bem como as palavras-chaves. Isso porque foi comparada a fre-

quência daquele item naquele documento em relação ao site inteiro, também foi compa-

rado com os demais, e nesse ranking de saber qual token é melhor para a subpágina, um

item foi o vencedor.

Engenharia analítica

Nesse momento, vamos abordar três conceitos: valor esperado (esperança matemática),

variância e desvio padrão. Para concluir, será passado um exemplo de Machine Learn apli-

cado em valor esperado.

Desvio padrão

Dado um empate entre dois atributos, o desvio padrão analisa e identifica a probabili-

dade de erro de cada atributo para ver qual é mais confiável, seguindo a fórmula a seguir:

Desvio padrão = (xi - média)2

n (quantidade)

Supondo que uma loja quer decidir qual produto precisa de mais propaganda, ela anali-

sa os seguintes dados:

FUNDAMENTOS EM DATA SCIENCE 92

eBook da Unidade 3 – Fundamentos em Data Science.indd 92 26/03/19 14:50

TABELA 5. COMPARAÇÃO DE TIPOS DE ROUPAS

Blusas Blusas

Produto

(esportivas) (sociais)

Mês 1 1.810,00 1.400,00

Mês 2 1.800,00 1950

Mês 3 1.900,00 2100

Média 1.836,67 1.816,67

Como pode ser visto, as médias são bem parecidas, então existe uma fórmula a ser apli-

cada para descobrir a variância e o desvio padrão.

DESVIO PADRÃO BLUSAS ESPORTIVAS

= (1810 - 1836)2 + (1800 - 1836)2 + (1900 - 1836)2

3

DESVIO PADRÃO BLUSAS ESPORTIVAS = 44

DESVIO PADRÃO BLUSAS SOCIAIS

= (1400 - 1816)2 + (1950 - 1816)2 + (2100 - 1816)2

3

DESVIO PADRÃO BLUSAS SOCIAIS = 300

Sabendo que o desvio para mais ou para menos das blusas sociais é muito maior, faz-se

mais necessário criar planos de fidelidade de compra e promoções voltadas às blusas so-

ciais. De um lado, varia muito, e de outro, demonstra alto potencial por ter compras mais

altas.

Uma forma de avaliar comportamentos em web e interações é através de Machine Learn.

A proposta de aplicação seria implantar o Machine Learn e, com a interação dos usuários,

fazer uma tabela com interações para avaliar as proporções.

Valor esperado

Em um restaurante, um prato traz um determinado lucro. Duas pessoas trazem um lucro

de R$ 100,00, três pessoas trazem um lucro de R$ 150,00 e quatro pessoas trazem um lucro

de R$ 175,00.

Em média, analisando um mês, são ocupadas 100 mesas por dia no restaurante, onde,

em média, 50 mesas são ocupadas por duas pessoas, 15 mesas por três pessoas e 35 me-

FUNDAMENTOS EM DATA SCIENCE 93

eBook da Unidade 3 – Fundamentos em Data Science.indd 93 26/03/19 14:50

sas por quatro pessoas. O valor será o lucro esperado nesse exemplo, e é o produto do

lucro pela probabilidade. Isso pode ser identificado com a seguinte fórmula:

VALOR ESPERADO = ∑ (X) * PROBABILIDADE(X)

TABELA 6. VALOR ESPERADO (LUCRO ESPERADO)

Lucro da

Valor

Clientes compra de Probabilidade

Esperado

serviços

2 100 0,50 50

3 150 0,15 22,5

4 175 0,35 61,25

Soma (lucro esperado por dia) 133,75

Criação de um robô captando interesse através de

dados

Para concluir, pode-se fazer um robô que faça a captação de interesses e tabular para

analisar valor esperado, ou seja, que palavra gera mais efeito.

Páginas comerciais, como as do Facebook, podem conter ferramentas robotizadas, a fim

de melhorar o relacionamento com o público ou captar interesses.

Temos, a seguir, um exemplo de como conhecer o público-alvo através de respostas dos

usuários em comentários de posts dessa página comercial do Facebook. Não é necessário

ter uma página comercial, basta ter uma página pessoal.

Um ponto importante é que as plataformas de criação de robôs em chats, ou chatbot,

são diversas, inclusive por Python e suas bibliotecas. Assim, é aconselhável praticar essas

plataformas e saber usar várias delas, uma vez que as necessidades mudam de empresa

para empresa e de sistemas para sistemas. Todavia, faz-se necessário praticar o conteúdo

de chatbot e não apenas ler, assim, absorve-se melhor os conteúdos.

DICA

Além das aplicações aprendidas neste curso, existem diversos cursos on-line sobre

chatbot, e muitos deles são gratuitos.

FUNDAMENTOS EM DATA SCIENCE 94

eBook da Unidade 3 – Fundamentos em Data Science.indd 94 26/03/19 14:50

A Fig. 13 demonstra a tela inicial da plataforma escolhida como exemplo. Depois de logar

com o usuário do Facebook, o data scientist criaria uma página comercial de forma simples.

Figura 13. Criação de Robôs para Data Science no Meet Messenger.

Uma vez logado, ao clicar em criar, a plataforma solicitaria o nome da empresa, o en-

dereço e o ramo e, após digitar esses dados, a página comercial é criada.

No exemplo apresentado, seria criada a página com o nome “Dicas de treino de corri-

da”, cujo objetivo era postar dicas esportivas e, então, além de divulgar os planos e dicas,

também descobrir quem é o público-alvo de maior interesse.

O primeiro passo seria entrar na página comercial e fazer um post com uma pergunta,

tal como: “Você possui interesse em conhecer três tipos de treino diferentes? Em caso

afirmativo, responda sim, e você receberá via Messenger um link com dicas.”. Caso a pes-

soa responda “SIM”, “sim”, “Sim”, “quero”, ou “QUERO”, ou seja, com as palavras certas,

automaticamente é enviado um texto em mensagem (chatbot) com dicas no Messenger

da pessoa que comentou e, embaixo do texto, um link para o site da empresa. A Fig. 14

exemplifica o post.

FUNDAMENTOS EM DATA SCIENCE 95

eBook da Unidade 3 – Fundamentos em Data Science.indd 95 26/03/19 14:50

Figura 14. Criando um post na página comercial do Facebook.

Após postar na página do Facebook, bastaria clicar em connect, conforme a Fig. 15.

Figura 15. Entrar na página comercial pelo Many Chat.

Estando o Meet Messenger conectado com a página, o data scientist precisaria apenas

seguir os passos da Fig 16, que criaria uma resposta automática para o cliente via men-

sagem.

FUNDAMENTOS EM DATA SCIENCE 96

eBook da Unidade 3 – Fundamentos em Data Science.indd 96 26/03/19 14:50

1 3

Clicar em comments Inserir palavras-chaves

2 3

Texto que será enviado

Selecionar um post

Figura 16. Criar Growth Tools.

Após isso, pode-se criar várias perguntas sequenciais para descobrir mais dados quan-

titativos e qualitativos.

O data scientist deve armazenar os usuários em um banco de dados, e é recomendado

criar um dataset ou gráficos com essas informações. Caso o trabalho seja a prioridade

do setor, ao analisar o dataset ou gráfico pode-se rapidamente fazer cálculos de análises

probabilísticas.

FUNDAMENTOS EM DATA SCIENCE 97

eBook da Unidade 3 – Fundamentos em Data Science.indd 97 26/03/19 14:51

Sintetizando

Essa unidade começou retomando o conceito de matriz de confusão, que analisa atributos

e, após testar, faz uma comparação das saídas supostas no treino com as saídas reais. Ela

analisa os falsos positivos, verdadeiros positivos, falsos negativos e verdadeiros negativos e,

após retomar, já fez duas análises: de acordo com nosso exemplo, houve uma para o corte de

pontos_antecipação e a outra de pontos_atraso, para delimitar a partir de quais valores o re-

sultado é mais confiável. Um pouco de NumPy foi passado, mas não completamente, pois isso

será abordado em outro momento. Foi passado, ainda, o conceito de evidência, que analisa

probabilidade de vários atributos com cálculos, cuja finalidade é pontuar cada atributo. O TF,

ou frequência de termos, foi abordado em mineração de texto, bem como os passos iniciais

antes de contar as frequências de cada palavra em um bag of words, e foi dito que é necessário

eliminar palavras que se repetem em demasia e não são úteis naquele contexto, para, assim,

identificar os tokens. Uma vez com esses tokens em mãos, pode-se fazer primeiro o cálculo de

TF, depois de IDF, isto é, quanto mais uma palavra se repete em um texto, e menos em um

conjunto, mais importante ela é para aquele texto. Sendo assim, ao realizar uma mineração,

é necessário analisar tanto um texto, quanto o conjunto, e o nome dessa comparação dupla é

TF-IDF, a qual faz a ponderação. O conceito de desvio padrão demonstrou como um item pode

variar para cima e para baixo. O conceito de valor esperado também foi passado, demonstran-

do que ele é nada mais que a média das quantidades multiplicadas pela probabilidade. Para

concluir, foi passado um exercício de machine learn para sustentar o aluno com uma prática

front end, isto é, em relacionamento com cliente.

FUNDAMENTOS EM DATA SCIENCE 98

eBook da Unidade 3 – Fundamentos em Data Science.indd 98 26/03/19 14:51

Referências bibliográficas

BORGES, R. et al. Gerenciamento do ponto de corte na concessão do crédito direto ao con-

sumidor. Rio de Janeiro: ANPAD, 2017, p. 273.

CERCHIARI, Ana L. Introdução ao numpy. Primeiros passos. São Paulo. 2019. Disponível em:

https://www.youtube.com/watch?v=jkzv9ejSnHg&feature=youtu.be. Acesso em: 13 fev. 2019.

FOSTER, P.; FAWCETT, P. Data Science para negócios: o que você precisa saber sobre minera-

ção de dados e pensamento analítico de dados? Rio de Janeiro: Alta books, 2016.

MARZAGÃO, T. Mineração de textos. São Paulo: UNB. [s.d.]. Disponível em: <http://thiagomar-

zagao.com/assets/teaching/mineracao/slides10.pdf>. Acesso em: 03 fev. 2019.

NOLASCO, D.; OLIVEIRA, J. Modelagem de tópicos e criação de rótulos: identificando temas

em dados semiestruturados e não-estruturados. Rio de Janeiro: URFJ, 2016. p. 17.

FUNDAMENTOS EM DATA SCIENCE 99

eBook da Unidade 3 – Fundamentos em Data Science.indd 99 26/03/19 14:51

Você também pode gostar

- Curso 115518 Aula 00 v2Documento30 páginasCurso 115518 Aula 00 v2Renato LimaAinda não há avaliações

- Analise Estatistica Com R para Leigos - Apendice A PDFDocumento10 páginasAnalise Estatistica Com R para Leigos - Apendice A PDFLoredana Villani AlexandreAinda não há avaliações

- Introdução A Econometria AVDocumento4 páginasIntrodução A Econometria AVAna CarolineAinda não há avaliações

- Introdução À Análise Gráfica Com ExcelDocumento29 páginasIntrodução À Análise Gráfica Com ExcelJoao FernandesAinda não há avaliações

- 25.0124 - Teste de Sensores SilosDocumento20 páginas25.0124 - Teste de Sensores SilosCarlos ModestoAinda não há avaliações

- Aula 03 - EstatísticaDocumento3 páginasAula 03 - EstatísticaRobson Carlos NogueiraAinda não há avaliações

- Tópico 4 - Dados de Entrada Parte 2-1Documento19 páginasTópico 4 - Dados de Entrada Parte 2-1João Pedro Lievore BassettiAinda não há avaliações

- Grafico de Renko e True RangeDocumento26 páginasGrafico de Renko e True RangeAndrey Vera CruzAinda não há avaliações

- Grafico de Renko e True RangeDocumento26 páginasGrafico de Renko e True RangeAndrey Vera CruzAinda não há avaliações

- Wisc Iv Modelo Do Protocolo de Correção e InterpretaçãoDocumento4 páginasWisc Iv Modelo Do Protocolo de Correção e InterpretaçãoPlindin- Shorume0% (1)

- S3 - 3 - MediçãoDocumento14 páginasS3 - 3 - MediçãoMARCIOAinda não há avaliações

- Atividade 3 - 01Documento6 páginasAtividade 3 - 01SamanthaAinda não há avaliações

- Modelo Padrode Redao CESPEDocumento2 páginasModelo Padrode Redao CESPEPatrick OakAinda não há avaliações

- CriptograDocumento9 páginasCriptograGuilherme Mendonça SoaresAinda não há avaliações

- Introdução Ao EviewsDocumento49 páginasIntrodução Ao EviewsMarcos Paulo GomesAinda não há avaliações

- Calculo de IncertezaDocumento151 páginasCalculo de Incertezafabsouz32100% (1)

- Aula 05Documento20 páginasAula 05flaviano_lisboa7467Ainda não há avaliações

- Matemática Básica Fundamental 1Documento32 páginasMatemática Básica Fundamental 1Aline AssunçãoAinda não há avaliações

- Curriculo MatematicaDocumento3 páginasCurriculo MatematicaHadassa SantosAinda não há avaliações

- Ajustamento Das Observações - Parte 1Documento101 páginasAjustamento Das Observações - Parte 1Vagner CostaAinda não há avaliações

- ProbabilidadesDocumento48 páginasProbabilidadesRômulo MedeirosAinda não há avaliações

- Introdução À Teoria Dos Grafos: EmentaDocumento9 páginasIntrodução À Teoria Dos Grafos: EmentaEmily SantosAinda não há avaliações

- Passei Direto - 3Documento6 páginasPassei Direto - 3SamanthaAinda não há avaliações

- Slides 1 2 3Documento32 páginasSlides 1 2 3Gabriella Mercês Paula de JesusAinda não há avaliações

- 2021 Fis1 Sem2Documento19 páginas2021 Fis1 Sem2Marcus Vinicius Simonato NunesAinda não há avaliações

- Lista de Exercicios EconometriaDocumento2 páginasLista de Exercicios EconometriaAna Midiã ;Ainda não há avaliações

- MSA PlanilhasDocumento19 páginasMSA Planilhasjonatasmedeiros01Ainda não há avaliações

- Matriz Da Prova de Equivalência GeoDocumento2 páginasMatriz Da Prova de Equivalência GeoMaria João FeioAinda não há avaliações

- EWMA 7 Treinamento Estatistica Básica Qualidade CamaçariDocumento33 páginasEWMA 7 Treinamento Estatistica Básica Qualidade CamaçariRaimundo Jose De Souza DiasAinda não há avaliações

- Relatório IADocumento2 páginasRelatório IAPedro CarvalhoAinda não há avaliações

- 9 - Mapa de Analise Estatistica - V2012Documento15 páginas9 - Mapa de Analise Estatistica - V2012Ayton4ever100% (1)

- D - Calculo e Raciocinio LogicoDocumento6 páginasD - Calculo e Raciocinio Logicojulianna.jacobbAinda não há avaliações

- PEAC-Mapa Curricular G7Documento9 páginasPEAC-Mapa Curricular G7ScribdTranslationsAinda não há avaliações

- Apostila Matemática FundamentalDocumento30 páginasApostila Matemática FundamentalAndressa Assaka100% (1)

- Método Dos Mínimos Quadrados: F 129 - Física Experimental IDocumento36 páginasMétodo Dos Mínimos Quadrados: F 129 - Física Experimental IAdriana DantasAinda não há avaliações

- Matemática Bianchin 3BIM-2020Documento13 páginasMatemática Bianchin 3BIM-2020Lamonnyer Pirett OliveiraAinda não há avaliações

- #2-Estatística 11º AnoDocumento38 páginas#2-Estatística 11º AnoAfonso CanelhoAinda não há avaliações

- 11 XValidationDocumento22 páginas11 XValidationvinicius carvalhoAinda não há avaliações

- Alinhamento RPS PDFDocumento2 páginasAlinhamento RPS PDFUILSONJRAinda não há avaliações

- Estatística - Aula 08Documento39 páginasEstatística - Aula 08Welison MouraAinda não há avaliações

- Analise EspacialDocumento56 páginasAnalise EspacialMaya PessoaAinda não há avaliações

- Unidade 5: ObjetivoDocumento25 páginasUnidade 5: ObjetivoGildo Flório JúniorAinda não há avaliações

- Avaliação Wisc IvDocumento10 páginasAvaliação Wisc IvViviane Fortes80% (5)

- 2 Avaliao - PHDocumento2 páginas2 Avaliao - PHtimoteoattaAinda não há avaliações

- Httpsweb - Fe.up - PT JmsaapsiAPSI 2 PDFDocumento103 páginasHttpsweb - Fe.up - PT JmsaapsiAPSI 2 PDFFaura GulamoAinda não há avaliações

- Slides1 Aula1 TPDocumento7 páginasSlides1 Aula1 TPGonçalo PereiraAinda não há avaliações

- Métodos Quantitativos de Apoio À Decisão: WBA0245 - v3.0Documento27 páginasMétodos Quantitativos de Apoio À Decisão: WBA0245 - v3.0Mario BarcelosAinda não há avaliações

- Comparação de Métodos de Detecção de Bordas em Imagens de Satélite de Florestas de Eucalipto No Vale Do JequitinhonhaDocumento4 páginasComparação de Métodos de Detecção de Bordas em Imagens de Satélite de Florestas de Eucalipto No Vale Do JequitinhonhaCristianoAlvesAinda não há avaliações

- Estatistica DescritivaDocumento29 páginasEstatistica DescritivaBeatriz DoroAinda não há avaliações

- NormalizDocumento2 páginasNormalizporpetaAinda não há avaliações

- CFST PapiroDocumento10 páginasCFST Papiroalvesmanoel2002Ainda não há avaliações

- Aula 5Documento38 páginasAula 5TSRosaAinda não há avaliações

- Minitab - CEP e R&RDocumento79 páginasMinitab - CEP e R&RFellipe BarbozaAinda não há avaliações

- Convkeras EadDocumento34 páginasConvkeras EadWedjaAinda não há avaliações

- Aula-03-V1 Mate PDFDocumento71 páginasAula-03-V1 Mate PDFThysann VianaAinda não há avaliações

- Livro Processos Cap 5 Parte - Series TempDocumento28 páginasLivro Processos Cap 5 Parte - Series TempBruno LannaAinda não há avaliações

- O Ensino Da Matemática Na Educação Básica Através Do Software GeogebraNo EverandO Ensino Da Matemática Na Educação Básica Através Do Software GeogebraAinda não há avaliações

- Relação Entre A Elevação de Troponina I Pós-Operatória e A Mortalidade em Um Ano Após Cirurgia de Ressecção PulmonarDocumento111 páginasRelação Entre A Elevação de Troponina I Pós-Operatória e A Mortalidade em Um Ano Após Cirurgia de Ressecção Pulmonareduardosantos.medAinda não há avaliações

- Estudo Comparativo Entre Modelos de Classificação para Behavior Scoring em ProcedimentosDocumento12 páginasEstudo Comparativo Entre Modelos de Classificação para Behavior Scoring em ProcedimentosDeborahAinda não há avaliações

- Ciencia de Dados Impressionador HashTag 2022Documento21 páginasCiencia de Dados Impressionador HashTag 2022Lestat HeathcliffAinda não há avaliações

- Jaeger PsicoUSF 2016Documento10 páginasJaeger PsicoUSF 2016Thales AndradeAinda não há avaliações

- MEem, MOCA, ACE-R, BBRC, IQCODE e OutrosDocumento156 páginasMEem, MOCA, ACE-R, BBRC, IQCODE e OutrosilcorpoliberoyogaAinda não há avaliações

- Questão Discursiva TCU ComentadaDocumento6 páginasQuestão Discursiva TCU Comentadafrgramulha01Ainda não há avaliações

- Predição de Deslizamentos de Terra Baseada em Inteligência Artificial e o Impacto de Diferentes Períodos de Chuva AcumuladaDocumento8 páginasPredição de Deslizamentos de Terra Baseada em Inteligência Artificial e o Impacto de Diferentes Períodos de Chuva AcumuladaLaedson Silva PedreiraAinda não há avaliações

- Borges, 2016 - Medidas de Acurácia Diagnóstica Na Pesquisa CardiovascularDocumento5 páginasBorges, 2016 - Medidas de Acurácia Diagnóstica Na Pesquisa CardiovascularArielly DouradoAinda não há avaliações