Escolar Documentos

Profissional Documentos

Cultura Documentos

Trabalho de Redes Neurais

Enviado por

alex0 notas0% acharam este documento útil (0 voto)

15 visualizações3 páginas1) O documento discute sobre redes neurais, especificamente sobre os conceitos de overfitting e underfitting durante o treinamento de uma rede neural.

2) O processo de aprendizagem Backpropagation é explicado, no qual os erros são calculados e propagados da camada de saída para a de entrada, modificando os pesos das conexões para minimizar o erro.

Descrição original:

Título original

_Trabalho de Redes Neurais

Direitos autorais

© © All Rights Reserved

Formatos disponíveis

PDF, TXT ou leia online no Scribd

Compartilhar este documento

Compartilhar ou incorporar documento

Você considera este documento útil?

Este conteúdo é inapropriado?

Denunciar este documento1) O documento discute sobre redes neurais, especificamente sobre os conceitos de overfitting e underfitting durante o treinamento de uma rede neural.

2) O processo de aprendizagem Backpropagation é explicado, no qual os erros são calculados e propagados da camada de saída para a de entrada, modificando os pesos das conexões para minimizar o erro.

Direitos autorais:

© All Rights Reserved

Formatos disponíveis

Baixe no formato PDF, TXT ou leia online no Scribd

0 notas0% acharam este documento útil (0 voto)

15 visualizações3 páginasTrabalho de Redes Neurais

Enviado por

alex1) O documento discute sobre redes neurais, especificamente sobre os conceitos de overfitting e underfitting durante o treinamento de uma rede neural.

2) O processo de aprendizagem Backpropagation é explicado, no qual os erros são calculados e propagados da camada de saída para a de entrada, modificando os pesos das conexões para minimizar o erro.

Direitos autorais:

© All Rights Reserved

Formatos disponíveis

Baixe no formato PDF, TXT ou leia online no Scribd

Você está na página 1de 3

Instituto de Computação

Curso de Sistemas de Informação e Ciência da

Computação

Trabalho de Redes Neurais

Alex Gabriel Rodrigues Araujo

1) O que é overfitting e underfitting?

Dentro da rede neural existem alguns tipos de treinamento conhecidos

como Aprendizagem por Reforço, Supervisionado e Não Supervisionado.

Dentre eles , o aprendizado supervisionado segue o princípio de adequação

do conjunto de acordo com os parâmetros das funções para que elas

satisfaçam algumas condições que são definidas. A partir dos parâmetros

ajustados estabelece-se o objetivo a ser calculado formando o modelo de

treinamento.

Entretanto, é necessário realizar uma adequação no modelo conforme

ele vai sendo treinado a base de dados, essas correções são necessárias

devido a anomalias nas entradas de dados do treinamento. Estas correções

são chamadas de overfitting (sobreajuste) e underfitting (subajuste).

A correção overfitting ocorre quando o modelo recebe informações

necessárias suficientes para realizar o modelo preditivo, porém, não se

adequa aos novos dados de entrada.

Diferente do overfitting, e underfitting é necessário pois o modelo não

conseguiu se adaptar com o conjunto de entradas

2) Pesquise o processo de aprendizagem

Backpropagation. Como ele funciona?

Na rede neural existe um algoritmo clássico responsável pelo

aprendizado conhecido como Backpropagation (Retropropagação do erro),

este tipo de algoritmo é tratado em função do treinamento supervisionado.

Durante o treinamento com o algoritmo Backpropagation, a rede opera

em uma sequência de dois passos. Primeiro, um padrão é apresentado à

camada de entrada da rede. A atividade resultante flui através da rede,

camada por camada, até que a resposta seja produzida pela camada de

saída. No segundo passo, a saída obtida é comparada à saída desejada para

esse padrão particular. Se esta não estiver correta, o erro é calculado. O erro

é propagado a partir da camada de saída até a camada de entrada, e os

pesos das conexões das unidades das camadas internas vão sendo

modificados conforme o erro é retro propagado.

As redes que utilizam Backpropagation trabalham com uma variação da

regra delta, apropriada para redes multi-camadas: a regra delta generalizada.

A regra delta padrão essencialmente implementa um gradiente descendente

no quadrado da soma do erro para funções de ativação lineares. Redes sem

camadas intermediárias, podem resolver problemas onde a superfície de erro

tem a forma de um parabolóide com apenas um mínimo. Entretanto, a

superfície do erro pode não ser tão simples, como a ilustrada na figura

abaixo, e suas derivadas mais difíceis de serem calculadas. Nestes casos

devem ser utilizadas redes com camadas intermediárias. Ainda assim, as

redes ficam sujeitas aos problemas de procedimentos "hill-climbing", ou seja,

ao problema de mínimos locais.

A regra delta generalizada funciona quando são utilizadas na rede

unidades com uma função de ativação semi-linear, que é uma função

diferenciável e não decrescente. Note que a função threshold não se

enquadra nesse requisito. Uma função de ativação amplamente utilizada,

nestes casos, é a função sigmoid.

A taxa de aprendizado é uma constante de proporcionalidade no intervalo

[0,1], pois este procedimento de aprendizado requer apenas que a mudança

no peso seja proporcional à neta.

Entretanto, o verdadeiro gradiente descendente requer que sejam

tomados passos infinitesimais. Assim quanto maior for essa constante, maior

será a mudança nos pesos, aumentando a velocidade do aprendizado, o que

pode levar à uma oscilação do modelo na superfície de erro. O ideal seria

utilizar a maior taxa de aprendizado possível que não levasse à uma

oscilação, resultando em um aprendizado mais rápido.

O treinamento das redes MLP com Backpropagation pode demandar

muitos passos no conjunto de treinamento, resultando em um tempo de

treinamento consideravelmente longo. Se for encontrado um mínimo local, o

erro para o conjunto de treinamento pára de diminuir e estaciona em um valor

maior que o aceitável. Uma maneira de aumentar a taxa de aprendizado sem

levar à oscilação é modificar a regra delta generalizada para incluir o termo

momentum, uma constante que determina o efeito das mudanças passadas

dos pesos na direção atual do movimento no espaço de pesos.

Você também pode gostar

- Trab FinalDocumento3 páginasTrab FinalalexAinda não há avaliações

- Lista ExerciciosDocumento14 páginasLista ExerciciosalexAinda não há avaliações

- Teoria Geral Dos SistemasDocumento3 páginasTeoria Geral Dos SistemasalexAinda não há avaliações

- Revista Educação Pública - A Utilização Dos Mapas Conceituais Como Ferramenta Didática Nas Licenciaturas de Física e Matemática Do CederjDocumento7 páginasRevista Educação Pública - A Utilização Dos Mapas Conceituais Como Ferramenta Didática Nas Licenciaturas de Física e Matemática Do CederjalexAinda não há avaliações

- Teoria Geral Dos SistemasDocumento3 páginasTeoria Geral Dos SistemasalexAinda não há avaliações

- Sika Protecção Betão - 03.223Documento3 páginasSika Protecção Betão - 03.223FilipeBaptistaAinda não há avaliações

- Zen Catalogo Mancais de Alternador e Motor de Partida 2019Documento118 páginasZen Catalogo Mancais de Alternador e Motor de Partida 2019LEODECIO BELO DE OLIVEIRA100% (1)

- Apresentação - Mancais para RolamentosDocumento34 páginasApresentação - Mancais para RolamentosPricyla ChwistAinda não há avaliações

- Wilo Sistemas de Bombagem 2009-03-30Documento252 páginasWilo Sistemas de Bombagem 2009-03-30CavamogoAinda não há avaliações

- Ricardo Barbosa PDDocumento84 páginasRicardo Barbosa PDCleide FernandesAinda não há avaliações

- HEPATECTOMIADocumento34 páginasHEPATECTOMIAFernando ZatAinda não há avaliações

- Atividade Cultura Brasileira 1 TEXTOSDocumento1 páginaAtividade Cultura Brasileira 1 TEXTOSRafael FrancoAinda não há avaliações

- Cantos para A Quaresma 2024Documento5 páginasCantos para A Quaresma 2024Keven RogerAinda não há avaliações

- Manutenção Eletrica Geral 17.07.2022Documento30 páginasManutenção Eletrica Geral 17.07.2022Nayara NascimentoAinda não há avaliações

- Periodização e Planejamento No JudôDocumento33 páginasPeriodização e Planejamento No JudôAdfda Fdfdf86% (7)

- Catecismo de Nossa Senhora PDFDocumento52 páginasCatecismo de Nossa Senhora PDFEvelyn Affonso100% (1)

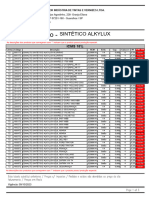

- Alkylux - ICMS 18Documento3 páginasAlkylux - ICMS 18Kenidi BiazottoAinda não há avaliações

- A Rosa Do Povo - Resumo e AnaliseDocumento10 páginasA Rosa Do Povo - Resumo e AnaliseAssencleves L. de AraújoAinda não há avaliações

- 1 A Historia Do PiDocumento12 páginas1 A Historia Do PialdobrasilAinda não há avaliações

- Espaços Motores de Fluxos Mundiais (12.º)Documento10 páginasEspaços Motores de Fluxos Mundiais (12.º)profgeofernando100% (2)

- A Lei de PembaDocumento6 páginasA Lei de PembaSergio Nabais100% (1)

- ExercíciosDocumento52 páginasExercíciosEvani Santos100% (1)

- ANÁLISE DAS ESTRUTURAS I - Aula 2 AE1Documento30 páginasANÁLISE DAS ESTRUTURAS I - Aula 2 AE1José RobertoAinda não há avaliações

- Acentuação GráficaDocumento3 páginasAcentuação GráficaAdrianaAinda não há avaliações

- A Corrente Humanista e A Corrente TranspessoalDocumento49 páginasA Corrente Humanista e A Corrente TranspessoalWanderlei GCAinda não há avaliações

- Contos 2Documento19 páginasContos 2IturalAinda não há avaliações

- Bergeret (1998) Psicologia Patolà Gica (Caps Sobre As Estruturas)Documento45 páginasBergeret (1998) Psicologia Patolà Gica (Caps Sobre As Estruturas)Daisy IvyAinda não há avaliações

- PIEPER Josef - Que e FilosofarDocumento35 páginasPIEPER Josef - Que e FilosofarMarcmelo100% (3)

- BR 09644539Documento194 páginasBR 09644539Bruno VenturaAinda não há avaliações

- Apostila Mariologia - Pe. João Paulo VelosoDocumento25 páginasApostila Mariologia - Pe. João Paulo VelosoTarcisio Augusto100% (1)

- Guia Ouvidores de VozesDocumento27 páginasGuia Ouvidores de VozesAna Paula SerranoAinda não há avaliações

- Levedo de Cerveja - Benefícios e Onde Comprar em Promoção!Documento1 páginaLevedo de Cerveja - Benefícios e Onde Comprar em Promoção!L.A OliveiraAinda não há avaliações

- Lista de Exercicios 1 - ÍNDICES FÍSICOS 2016.1Documento3 páginasLista de Exercicios 1 - ÍNDICES FÍSICOS 2016.1Vilobaldo Oliveira100% (1)

- 06 Caixas de AreiaDocumento11 páginas06 Caixas de AreiafaustomafrafilhoAinda não há avaliações