Escolar Documentos

Profissional Documentos

Cultura Documentos

Programação Concorrente e Distribuída

Enviado por

Herval Junior0 notas0% acharam este documento útil (0 voto)

48 visualizações2 páginasEste documento descreve um curso de 72 horas sobre Programação Concorrente e Distribuída. O curso tem como objetivo apresentar os fundamentos da programação concorrente para arquiteturas paralelas e distribuídas. Serão abordados tópicos como arquitetura de máquinas paralelas, técnicas de programação concorrente, medidas de desempenho de aplicações paralelas e introdução à programação para GPUs. O curso contará com aulas teóricas, práticas em laboratório e avaliação contínu

Descrição original:

Ementa da disciplina Programação Concorrente com boas indicações de leitura

Título original

Programação_Concorrente_e_Distribuída

Direitos autorais

© © All Rights Reserved

Formatos disponíveis

PDF, TXT ou leia online no Scribd

Compartilhar este documento

Compartilhar ou incorporar documento

Você considera este documento útil?

Este conteúdo é inapropriado?

Denunciar este documentoEste documento descreve um curso de 72 horas sobre Programação Concorrente e Distribuída. O curso tem como objetivo apresentar os fundamentos da programação concorrente para arquiteturas paralelas e distribuídas. Serão abordados tópicos como arquitetura de máquinas paralelas, técnicas de programação concorrente, medidas de desempenho de aplicações paralelas e introdução à programação para GPUs. O curso contará com aulas teóricas, práticas em laboratório e avaliação contínu

Direitos autorais:

© All Rights Reserved

Formatos disponíveis

Baixe no formato PDF, TXT ou leia online no Scribd

0 notas0% acharam este documento útil (0 voto)

48 visualizações2 páginasProgramação Concorrente e Distribuída

Enviado por

Herval JuniorEste documento descreve um curso de 72 horas sobre Programação Concorrente e Distribuída. O curso tem como objetivo apresentar os fundamentos da programação concorrente para arquiteturas paralelas e distribuídas. Serão abordados tópicos como arquitetura de máquinas paralelas, técnicas de programação concorrente, medidas de desempenho de aplicações paralelas e introdução à programação para GPUs. O curso contará com aulas teóricas, práticas em laboratório e avaliação contínu

Direitos autorais:

© All Rights Reserved

Formatos disponíveis

Baixe no formato PDF, TXT ou leia online no Scribd

Você está na página 1de 2

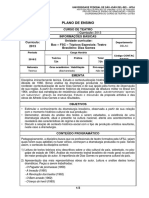

Nome do Componente Curricular: Programação Concorrente e Distribuída

Pré-requisitos: Sistemas Operacionais

Carga Horária Total: 72h

Carga Horária Prática: 30h Carga Horária Teórica: 42h

Objetivos

Geral:

Apresentar aos alunos os fundamentos programação concorrente para arquiteturas paralelas e/ou

distribuídas.

Específicos:

Ao final do curso os alunos deverão ser capazes de compreender os princípios da programação

concorrente para arquiteturas paralelas e distribuídas, bem como projetar algoritmos segundo estes

princípios.

Ementa: Introdução a programação concorrente; Arquitetura de máquinas paralelas e distribuídas;

Análise de dependências; Técnicas e algoritmos clássicos em programação concorrente e distribuída

(seções críticas, exclusão mútua, semáforos, monitores, sincronização de relógios, etc); Expressando

concorrência em sistemas de memória compartilhada e distribuída; Medidas de desempenho de

aplicações paralelas; Exploração de paralelismo; solução de problemas com concorrência; Introdução

a programação para arquiteturas Multicore/Manycores e GPGPU. Técnica de Map-Reduce.;

Conteúdo Programático:

Introdução a programação concorrente: motivação e representação de concorrência, concorrência e

paralelismo. Arquitetura de máquinas paralelas e distribuídas (introdução): Sistemas multitarefas,

taxonomia de Flynn, Multiprocessadores (SMP – Symetric Multi Processor), multicores/manycores,

Sistemas distribuídos (clusters e grades computacionais), paralelismo de múltiplos níveis. Expressando

concorrência em sistemas de memória compartilhada (introdução): processos Jork-Join e Threads

(Posix-Threads e Java-Threads), OpenMP. Medidas de desempenho de aplicações paralelas: Speedup,

Eficiência, Escalabilidade e Lei de Amdahl. Técnicas e algoritmos clássicos em programação

concorrente e distribuída: Seções críticas; Exclusão mútua (MuteX); Atomicidade; Barreiras; Semáforos

(algoritmos: dining philosophers, leitores/escritores, produtor/consumidor); Monitores; Justiça

(evitando starvation); Condições de corrida; Deadlocks; Consenso (Generais Bizantinos); Eleição;

Tokens; Sincronização de Relógios e relógios lógicos de Lamport. Expressando concorrência em

sistemas de memória distribuída (introdução): Modelo de Troca de Mensagens (MPI - Message

Passing Interface). Análise de dependências. Exploração de paralelismo: Paralelismo de dados

(decomposição de domínio) e paralelismo de fluxo (decomposição funcional). Solução de problemas

com concorrência utilizando algoritmos paralelos (Ordenação; Multiplicação de Matrizes; Solução de

Sistemas Lineares de equações, etc). Introdução a programação para arquiteturas

Multicore/Manycores e GP-GPU (General Pourpouse Graphics Processing Unit). Introdução a Técnica

de Map-Reduce.

Metodologia de Ensino Utilizada:

O curso será baseado em aulas expositivas com auxílio do quadro e projetor multimídia. A

participação dos alunos em sala de aula será estimulada através de perguntas e sessões de exercícios.

Para fixação dos tópicos estudados, os alunos receberão, ao longo do curso, listas de exercícios para

entrega em sala de aula. Por fim, destacam-se as aulas práticas nos laboratórios de informática para

fixação dos conteúdos através de do uso de ambientes de desenvolvimento de software.

Recursos Instrucionais Necessários:

Data-show e computador para suporte visual das aulas expositivas em sala. Laboratório de computa-

dores conectados em rede (para experimentação prática de programas para sistemas de memória dis-

tribuída) para aulas práticas com assentos e equipamentos suficientes. Ambiente “Moodle” para

apoio à atividades complementares a distância. Acervo bibliográfico para consulta.

Critérios de Avaliação:

O sistema de avaliação será definido pelo docente responsável pela unidade curricular no início das

atividades letivas devendo ser aprovado pela Comissão de Curso e divulgado aos alunos. O sistema

adotado deve contemplar o processo de ensino e aprendizagem estabelecido neste Projeto

Pedagógico, com o objetivo de favorecer o progresso do aluno ao longo do semestre. A promoção do

aluno na unidade curricular obedecerá aos critérios estabelecidos pela Pró-Reitoria de Graduação, tal

como discutido no Projeto Pedagógico do Curso.

Bibliografia

Básica:

1. Ben-Ari, M. Principles of Concurrent and Distributed Programming, 2a edição, Addison-Wesley,

2006.

2. Herlihy, M., Shavit, N. The Art of Multiprocessor Programming, Elsevier, 2008

3. Andrews, G.R. Foundations of Multithreaded, Parallel, and Distributed Programming, Addison-

Wesley, 1999;

Complementar:

1. De Rose, C.A.F., Navaux, P.O.A. Arquiteturas Paralelas, Bookman, 2008.

2. Hughes, C., Hughes, T. Professional Multicore Programming – Design and Implementation for

C++ Developers, Wrox, 2008.

3. Dowd, K. High Performance Computing, O'Reilly, 1993.

4. Lea, D. Concurrent Programming in JavaTM: Design Principles and Patterns, 2a edição,

Addison-Wesley, 1999.

5. Tanenbaum, A.S., Steen, M., Sistemas Distribuídos: princípios e operações, 2a edição, Pearson,

2008.

6. Ghosh, S., Distributed Systems: An Algorithmic Approach, CRC Press, 2006.

Você também pode gostar

- Desenvolvimento De Software Ii C# Programação Em CamadasNo EverandDesenvolvimento De Software Ii C# Programação Em CamadasAinda não há avaliações

- Orientação a Objetos em C#: Conceitos e implementações em .NETNo EverandOrientação a Objetos em C#: Conceitos e implementações em .NETNota: 5 de 5 estrelas5/5 (1)

- PE BCC M GPE02M0450-Algoritmos e Programacao Estruturada-FabianoDocumento10 páginasPE BCC M GPE02M0450-Algoritmos e Programacao Estruturada-FabianowendellpereirsgestorAinda não há avaliações

- Pe Grad 2022-2 Algoritmo e Logica de ProgramacaoDocumento5 páginasPe Grad 2022-2 Algoritmo e Logica de ProgramacaoLeyde SilvaAinda não há avaliações

- Plano de Ensino - 2023-1 - Programação Estruturada V1-3Documento3 páginasPlano de Ensino - 2023-1 - Programação Estruturada V1-3João LinharesAinda não há avaliações

- Plano Ensino INE5603 01238C 20172Documento2 páginasPlano Ensino INE5603 01238C 20172izabel hinoAinda não há avaliações

- Modelo Eng - de.TELECOMUNICAÇÕESDocumento2 páginasModelo Eng - de.TELECOMUNICAÇÕESSergio De OliveiraAinda não há avaliações

- Plano Ensino INE5406 02208A 02208B 20101Documento4 páginasPlano Ensino INE5406 02208A 02208B 20101Luciano Ramos SantosAinda não há avaliações

- Logica de Programacao PDFDocumento117 páginasLogica de Programacao PDFlode77Ainda não há avaliações

- Plano de EnsinoDocumento5 páginasPlano de EnsinoTed PradoAinda não há avaliações

- ENG TELECOM Modelo Plano Ensino 2022 2Documento2 páginasENG TELECOM Modelo Plano Ensino 2022 2Sergio De OliveiraAinda não há avaliações

- TEAC - Sistemas DigitaisDocumento16 páginasTEAC - Sistemas DigitaisPCrispim100% (1)

- Arquitetura e Organização de ComputadoresDocumento3 páginasArquitetura e Organização de ComputadoresXavier JoaquimAinda não há avaliações

- ENG TELECOM Modelo Plano Ensino 2022 2Documento2 páginasENG TELECOM Modelo Plano Ensino 2022 2Sergio De OliveiraAinda não há avaliações

- Plano de Ensino Logica de ProgramaçãoDocumento4 páginasPlano de Ensino Logica de ProgramaçãoBeatriz AzulayAinda não há avaliações

- Plano Ensino INE5231 0239B 20082Documento3 páginasPlano Ensino INE5231 0239B 20082sebastiao miguel kinangaAinda não há avaliações

- NPG1401 1Documento4 páginasNPG1401 1Jean HuveAinda não há avaliações

- Plano de Ensino Prog WebDocumento3 páginasPlano de Ensino Prog WebgrandemauAinda não há avaliações

- Plano de Ensino: Instituto de Informática Departamento de Informática Aplicada Dados de Identificação Período LetivoDocumento4 páginasPlano de Ensino: Instituto de Informática Departamento de Informática Aplicada Dados de Identificação Período Letivotusta rodriguesAinda não há avaliações

- AlgoritmosDocumento42 páginasAlgoritmosVanlaerAinda não há avaliações

- Arqcomp Profissionais PDFDocumento22 páginasArqcomp Profissionais PDFMagda Rodrigues RodAinda não há avaliações

- Plano Ensino INE5231 02203A 20162Documento3 páginasPlano Ensino INE5231 02203A 20162sebastiao miguel kinangaAinda não há avaliações

- Plano de Ensino - Programação de Computadores e Dispositivos Móveis (Android)Documento6 páginasPlano de Ensino - Programação de Computadores e Dispositivos Móveis (Android)Alex SouzaAinda não há avaliações

- Gac124 - Introducao Aos Algoritmos - 14b - 2023 2Documento4 páginasGac124 - Introducao Aos Algoritmos - 14b - 2023 2isael.rosaAinda não há avaliações

- ARA0063 Plano de EnsinoDocumento5 páginasARA0063 Plano de EnsinoMarcia RosaAinda não há avaliações

- Informatica Laboratorio de Software ProfessorDocumento130 páginasInformatica Laboratorio de Software ProfessorNicoly FerreiraAinda não há avaliações

- Plano Ensino INE5605 0238A 20082Documento2 páginasPlano Ensino INE5605 0238A 20082izabel hinoAinda não há avaliações

- Plano de Ensino Lógica de ProgramaçãoDocumento4 páginasPlano de Ensino Lógica de ProgramaçãoMarco GuimarãesAinda não há avaliações

- Plano de Ensino - 2023-1 - Programação Estruturada v1-3Documento3 páginasPlano de Ensino - 2023-1 - Programação Estruturada v1-3João LinharesAinda não há avaliações

- Ementa AocDocumento5 páginasEmenta AocRui ContiAinda não há avaliações

- Ferramenta de Apoio Ao Ensino de ProgramaçãoDocumento9 páginasFerramenta de Apoio Ao Ensino de ProgramaçãoGeorge ValençaAinda não há avaliações

- Programa Ministerio Sdac PDFDocumento33 páginasPrograma Ministerio Sdac PDFdeus7273Ainda não há avaliações

- SdacDocumento33 páginasSdacaurelius1Ainda não há avaliações

- Textoaedi Si Ufal AiltoncruzDocumento229 páginasTextoaedi Si Ufal AiltoncruzJoao Pedro de Oliveira RodriguesAinda não há avaliações

- Plano de Ensino - LPADocumento3 páginasPlano de Ensino - LPAjoseskunk4Ainda não há avaliações

- PIDE Fase I - Gabriel Moura CoelhoDocumento2 páginasPIDE Fase I - Gabriel Moura Coelhogabrielmoura94068621Ainda não há avaliações

- Ementa Todas Materias PitagorasDocumento41 páginasEmenta Todas Materias PitagorasviniciusAinda não há avaliações

- Plano Ensino INE5404 0232A 20092Documento2 páginasPlano Ensino INE5404 0232A 20092Aurelio MaciaAinda não há avaliações

- Apostila - Criação de Web SitesDocumento119 páginasApostila - Criação de Web SitesLiana LeuckAinda não há avaliações

- Ficha 2 - CMA211 - Calculo2 - ERE3Documento5 páginasFicha 2 - CMA211 - Calculo2 - ERE3Gustavo França CiroGomesPresidenteAinda não há avaliações

- 26-Sistemas DigitaisDocumento16 páginas26-Sistemas DigitaisHernani MendesAinda não há avaliações

- TMS0058 Plano de EnsinoDocumento4 páginasTMS0058 Plano de Ensinopeket49912Ainda não há avaliações

- Plano de Ensino: Instituto de Informática Departamento de Informática Teórica Dados de Identificação Período LetivoDocumento3 páginasPlano de Ensino: Instituto de Informática Departamento de Informática Teórica Dados de Identificação Período Letivotusta rodriguesAinda não há avaliações

- Importancia Do Algoritmo e ProgramacaoDocumento6 páginasImportancia Do Algoritmo e ProgramacaoJosimar da SilvaAinda não há avaliações

- Engenharia Telecom Plano Ensino Aeds2Documento2 páginasEngenharia Telecom Plano Ensino Aeds2Sergio De OliveiraAinda não há avaliações

- 3 SemestreDocumento12 páginas3 SemestreLarissa FeitozaAinda não há avaliações

- NDC229 Introdução À ProgramaçãoDocumento2 páginasNDC229 Introdução À ProgramaçãoCamila SilvaAinda não há avaliações

- Gsi502 IpcremotoDocumento9 páginasGsi502 IpcremotoKAYO KGAinda não há avaliações

- APS - CC - 2o - e - 3o - Sem - Ordenacao (ED)Documento7 páginasAPS - CC - 2o - e - 3o - Sem - Ordenacao (ED)Cleber MarquesAinda não há avaliações

- Pdtadsist02na - Estrutura de Dados IiDocumento3 páginasPdtadsist02na - Estrutura de Dados IiAlexandre InacioAinda não há avaliações

- ARA1391 Plano de EnsinoDocumento4 páginasARA1391 Plano de Ensinopeket49912Ainda não há avaliações

- Aise Inf GestãoDocumento23 páginasAise Inf Gestãorssguimaraes7661Ainda não há avaliações

- Programação Didática com Linguagem CNo EverandProgramação Didática com Linguagem CNota: 3.5 de 5 estrelas3.5/5 (2)

- Desenvolvimento De Software - Aplicativo Comercial Com C# E CamadasNo EverandDesenvolvimento De Software - Aplicativo Comercial Com C# E CamadasAinda não há avaliações

- Metodologia Ativa: uma caracterização do uso de cenários de computação em nuvem em disciplinas de graduação em ComputaçãoNo EverandMetodologia Ativa: uma caracterização do uso de cenários de computação em nuvem em disciplinas de graduação em ComputaçãoAinda não há avaliações

- Metodologias ativas, gamificação com quizz: instrumentos para potencializar o ensino presencial técnicoNo EverandMetodologias ativas, gamificação com quizz: instrumentos para potencializar o ensino presencial técnicoAinda não há avaliações

- Desbravando SOLID: Práticas avançadas para códigos de qualidade em Java modernoNo EverandDesbravando SOLID: Práticas avançadas para códigos de qualidade em Java modernoAinda não há avaliações

- 7961 32481 1 PBDocumento23 páginas7961 32481 1 PBLucas SantosAinda não há avaliações

- História, Século XIXDocumento4 páginasHistória, Século XIXHerval JuniorAinda não há avaliações

- Análise Das Canções de Itamar Assumpção e Alice Ruiz at UFPR PDFDocumento128 páginasAnálise Das Canções de Itamar Assumpção e Alice Ruiz at UFPR PDFHerval JuniorAinda não há avaliações

- O Fausto de MarloweDocumento7 páginasO Fausto de MarloweHerval JuniorAinda não há avaliações

- A Recife Cinemática em Amarelo Manga at UFRNDocumento16 páginasA Recife Cinemática em Amarelo Manga at UFRNHerval JuniorAinda não há avaliações

- Coz in Ha Darwinist ADocumento5 páginasCoz in Ha Darwinist ABeatriz Coutinho CoutinhoAinda não há avaliações

- XAVIER, Ismail - Sertão Mar PDFDocumento10 páginasXAVIER, Ismail - Sertão Mar PDFHerval JuniorAinda não há avaliações

- Teatro Brasileiro - UFSJDocumento3 páginasTeatro Brasileiro - UFSJHerval JuniorAinda não há avaliações

- Policia MilitarDocumento11 páginasPolicia MilitarCarlos AlexandreAinda não há avaliações

- Sobre Falstaff PDFDocumento40 páginasSobre Falstaff PDFHerval JuniorAinda não há avaliações

- A Construção Da Identidade Negra No Filme Jubiabá - Maria Angela Pavan e Dennis de OliveiraDocumento14 páginasA Construção Da Identidade Negra No Filme Jubiabá - Maria Angela Pavan e Dennis de OliveiramayFiorOliveiraAinda não há avaliações

- Pagliacci Release PDFDocumento4 páginasPagliacci Release PDFHerval JuniorAinda não há avaliações

- Apostila AguiperjDocumento30 páginasApostila AguiperjPaulo BuenoAinda não há avaliações

- Freud - Roteiro de LeituraDocumento1 páginaFreud - Roteiro de LeituraHerval JuniorAinda não há avaliações

- Arabia - JoyceDocumento5 páginasArabia - JoyceRaquel MoreiraAinda não há avaliações

- Resumo Das Disposições Constitucionais - Gustavo KnoplockDocumento8 páginasResumo Das Disposições Constitucionais - Gustavo KnoplockHerval JuniorAinda não há avaliações

- Resumo Das Disposições Constitucionais - Gustavo KnoplockDocumento8 páginasResumo Das Disposições Constitucionais - Gustavo KnoplockHerval JuniorAinda não há avaliações

- Persona-Bergman, Jung e KierkegaardDocumento11 páginasPersona-Bergman, Jung e KierkegaardDeyve RedysonAinda não há avaliações

- Conceitos de HardwareDocumento4 páginasConceitos de HardwareHerval JuniorAinda não há avaliações

- (PROVA) Assistente Técnico de TrânsitoDocumento12 páginas(PROVA) Assistente Técnico de TrânsitoHerval JuniorAinda não há avaliações

- (Exercícios) Redes AulãoDocumento1 página(Exercícios) Redes AulãoHerval JuniorAinda não há avaliações

- (HARDWARE) Slots, Conectores e PortasDocumento4 páginas(HARDWARE) Slots, Conectores e PortasHerval JuniorAinda não há avaliações

- Ecos de Otelo em Dom Casmurro @UERJDocumento19 páginasEcos de Otelo em Dom Casmurro @UERJHerval JuniorAinda não há avaliações

- As Raízes Ibéricas e Populares Do Teatro de Ariano Suassuna - UFRGSDocumento17 páginasAs Raízes Ibéricas e Populares Do Teatro de Ariano Suassuna - UFRGSHerval JuniorAinda não há avaliações

- Problemas Clássicos de Sincronização - FECENSDocumento5 páginasProblemas Clássicos de Sincronização - FECENSHerval JuniorAinda não há avaliações

- (PROVA) Assistente Técnico AdministrativoDocumento12 páginas(PROVA) Assistente Técnico AdministrativoHerval Junior0% (2)

- (PROVA) Assistente Técnico AdministrativoDocumento12 páginas(PROVA) Assistente Técnico AdministrativoHerval Junior0% (2)

- (HARDWARE) Slots, Conectores e PortasDocumento4 páginas(HARDWARE) Slots, Conectores e PortasHerval JuniorAinda não há avaliações

- A História Trágica Do Doutor Fausto - Christopher MarloweDocumento15 páginasA História Trágica Do Doutor Fausto - Christopher MarloweHerval JuniorAinda não há avaliações

- Treinamento BGP - EADDocumento81 páginasTreinamento BGP - EADHiuri IlhaAinda não há avaliações

- Comandos Básicos de Diagnósticos de Redes e Interpretações de Resultados - Reader ViewDocumento3 páginasComandos Básicos de Diagnósticos de Redes e Interpretações de Resultados - Reader ViewnenhummailAinda não há avaliações

- GTR2401 Roteador Sem-Fio 0102Documento60 páginasGTR2401 Roteador Sem-Fio 0102MarceloPeresAinda não há avaliações

- Prova de RedesDocumento3 páginasProva de RedesMarcus ViniciusAinda não há avaliações

- Manual Do Usuario Video IP Mobile PDFDocumento13 páginasManual Do Usuario Video IP Mobile PDFPedro SimõesAinda não há avaliações

- LIVRO05Documento16 páginasLIVRO05Natanaele Barros MachadoAinda não há avaliações

- 9-1 QoS Modelos e Tecnicas de Implementacao PDFDocumento15 páginas9-1 QoS Modelos e Tecnicas de Implementacao PDFEmanuel SilvaAinda não há avaliações

- Como Funciona A InternetDocumento12 páginasComo Funciona A InternetJulio SoaresAinda não há avaliações

- Laboratório 4 - HTTP Proxy ServerDocumento4 páginasLaboratório 4 - HTTP Proxy ServerUTA - Std - Walter Djon GonçalvesAinda não há avaliações

- Huawei Enterprise Router NE40E-M2K V800R010C10 Datasheet (Portuguese)Documento18 páginasHuawei Enterprise Router NE40E-M2K V800R010C10 Datasheet (Portuguese)Mailson Arruda De AzevedoAinda não há avaliações

- Configuração Huawei 5608T - WiFiber 121 AC - 0Documento24 páginasConfiguração Huawei 5608T - WiFiber 121 AC - 0PadastroAinda não há avaliações

- Como Configurar Voip Olt Onu FiberhomeDocumento7 páginasComo Configurar Voip Olt Onu FiberhomeDanielAinda não há avaliações

- Guia Laboratorio-Pack01Documento14 páginasGuia Laboratorio-Pack01Máibe LimaAinda não há avaliações

- Subdivisão de Redes Incluindo VLSMDocumento28 páginasSubdivisão de Redes Incluindo VLSMAna KatarinaAinda não há avaliações

- Gpon Ou EponDocumento28 páginasGpon Ou EponMichell Vasconcelos Siqueira100% (1)

- Integre Pela Internet Com Os Web Services Openedge: Foco Da SessãoDocumento16 páginasIntegre Pela Internet Com Os Web Services Openedge: Foco Da Sessãoenigma9000Ainda não há avaliações

- Atividade NMAPDocumento4 páginasAtividade NMAPRicardo GomesAinda não há avaliações

- Cálculos de Sub - RedesDocumento8 páginasCálculos de Sub - RedesmafeAinda não há avaliações

- IPDocumento4 páginasIPDavi Kreppel100% (1)

- Huawei MT800 ManualDocumento69 páginasHuawei MT800 ManualMarceloPeresAinda não há avaliações

- Wireshark Lab: IP: 200S KUROSE, JF & Ross. WDocumento10 páginasWireshark Lab: IP: 200S KUROSE, JF & Ross. WBorn BenAinda não há avaliações

- Lista de Exercícios 1Documento3 páginasLista de Exercícios 1Enio José Bolognini100% (1)

- Manual Usuario ConfiguradorWeb PDFDocumento256 páginasManual Usuario ConfiguradorWeb PDFReinaldo FascinaAinda não há avaliações

- Redes de Computadores IIDocumento2 páginasRedes de Computadores IIviero_sm100% (1)

- 03 BGP Bloqueio Dos Flood - Ear PDFDocumento41 páginas03 BGP Bloqueio Dos Flood - Ear PDFdiegodns2010Ainda não há avaliações

- CCNA123Documento28 páginasCCNA123Marcelo FradeAinda não há avaliações