Escolar Documentos

Profissional Documentos

Cultura Documentos

Prevendo o Consumo de Matéria Seca em Bovinos Leiteiros Por Meio de Redes Neurais

Enviado por

Larissa InacioTítulo original

Direitos autorais

Formatos disponíveis

Compartilhar este documento

Compartilhar ou incorporar documento

Você considera este documento útil?

Este conteúdo é inapropriado?

Denunciar este documentoDireitos autorais:

Formatos disponíveis

Prevendo o Consumo de Matéria Seca em Bovinos Leiteiros Por Meio de Redes Neurais

Enviado por

Larissa InacioDireitos autorais:

Formatos disponíveis

Machine Translated by Google

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8258

INTRODUÇÃO eles são compostos de neurônios interconectados dispostos em

camadas (Bishop, 2006). Nesse contexto, a ANN pode capturar

Com uma população mundial crescente projetada para atingir relacionamentos mais complicados entre as variáveis de entrada

9 bilhões de pessoas até 2050 (ONU, 2019), é fundamental e o resultado da resposta em comparação com o PLS.

melhorar a eficiência da indústria agrícola.

Melhorar a eficiência alimentar é um objetivo importante de Os objetivos deste estudo foram (1) avaliar se os dados MIRS

muitos produtores de leite, pois a alimentação é o principal custo do leite poderiam melhorar a previsão de CMS de

associado à produção leiteira (Hemme et al., 2014). A ingestão vacas Holstein canadenses usando dados do Canadá e parceiros

de matéria seca é um componente crucial que influencia a internacionais; (2) para investigar a capacidade de

eficiência animal e será de grande utilidade para melhorar os diferentes arquiteturas de RNA lineares e não lineares e

atuais programas de melhoramento de avaliação genética (de regressão PLS para prever DMI; e (3) validar a robustez dos

Haas et al., 2015). No entanto, o CMS é uma característica modelos de predição desenvolvidos.

cara para medir em vacas individuais em sistemas comerciais

(Dórea et al., 2018). É reconhecido que a avaliação genética de

MATERIAIS E MÉTODOS

vacas leiteiras necessita de grandes conjuntos de dados; no

entanto, devido à complexidade e ao custo envolvidos na

Coleta de Dados e Controle de Qualidade

medição do CMS, apenas pequenos conjuntos de dados para

consumo de ração estão disponíveis atualmente (Wallén et al., Um total de 7.398 CMS médio semanal de 509 vacas leiteiras

2017). Consequentemente, o principal fator que dificulta a de primeira e segunda lactação distribuídas no Canadá (4.863

avaliação genética do consumo de ração em programas de amostras de 290 vacas), Estados Unidos (1.563 amostras de

criação de gado leiteiro é o acesso regular a dados fenotípicos 127 vacas) e Dinamarca (972 amostras de 92 vacas) foram

de consumo de ração de uma grande população animal analisadas. Com o objetivo de predizer o CMS apenas de vacas

holandesas

registrada de forma contínua, idealmente a baixo custo, para obter alta precisãocanadenses, dados do

de seleção (Wallén Canadá

et al., e parceiros

2018).

No Canadá, o projeto de pesquisa Efficient Dairy Genome internacionais (Estados Unidos e Dinamarca) foram usados para

(https://genomedairy.ualberta.ca/) estabeleceu uma colaboração aumentar o tamanho e a variabilidade dos dados para melhorar

internacional para compartilhar fenótipos de DMI para ampliar a generalização do modelo ao longo da lactação. Os dados

os bancos de dados nacionais individuais. foram coletados entre 2014 e 2018, e foram obtidos do banco

A espectroscopia de refletância no infravermelho médio (MIR) de dados Efficient Dairy Genome Project (https://

(MIRS) em amostras de leite pode ser uma alternativa acessível

para prever o CMS em nível populacional (Shetty et al., 2017). genomadairy.ualberta.ca/). Todos os procedimentos com animais

Milk MIRS é baseado na interação entre matéria e ondas foram aprovados pelos comitês de cuidados e uso de animais

eletromagnéticas entre 900 e 5.000 cm-1 (De Marchi et al., nas universidades e centros de pesquisa que forneceram dados

2014), e é amplamente utilizado em sistemas comerciais de para esta pesquisa (ou seja, o Dairy Research and Technology

registro de laticínios para prever os componentes do leite. Nesse Center, Edmonton, Canadá; o Ontario Dairy Research Centre,

contexto, o MIRS tem se mostrado eficiente na predição de Elora, Canadá; o Danish Cattle Research Center, Foulum,

fenótipos para a composição de ácidos graxos do leite (Soyeurt Dinamarca; e o USDA Agricultural Research Service, Beltsville,

et al., 2006, 2011; Fleming et al., 2017), composição de proteínas MD) e todos os animais foram cuidados de acordo com as

do leite (Rutten et al., 2011), corpos (van der Drift et al., 2012) e respectivas diretrizes nacionais sobre cuidados com animais de

composição mineral (Soyeurt et al., 2009). cada país.

Todas as amostras individuais de leite da manhã e da noite

Até onde sabemos, o primeiro estudo sobre predição de CMS foram analisadas usando espectrômetros MilkoScan FT+ (Foss),

usando leite MIRS foi realizado por Shetty et al. (2017). No que geraram um espectro para cada amostra de leite analisada.

entanto, naquele estudo, os autores utilizaram o método dos Para cada vaca, a média semanal de CMS foi calculada e, em

mínimos quadrados parciais (PLS) , que pode não ser o ideal seguida, foi mesclada com os dados MIRS correspondentes

devido à alta dimensionalidade das variáveis preditoras (n = (consulte a próxima seção), com base na data do teste. Como

1.060 comprimentos de onda, WL) e ao fato de que pode haver parte do peso corporal da vaca era originalmente peso parcial,

uma variação não linear relação entre alguns WL e DMI (Dórea o peso corporal metabólico da vaca (BW0,75, MBW) foi

et al., 2018). Assim, embora o método PLS tenha sido usado padronizados para uma média e variância comuns. Para

principalmente na pesquisa MIRS para desenvolver modelos de calcular os valores ausentes de MBW, uma regressão linear foi

previsão (por exemplo, Soyeurt et al., 2006; McParland et al., ajustada usando os registros de MBW disponíveis para cada

2011), as redes neurais artificiais (ANN) podem potencialmente animal e PROC GLM (versão 9.4; SAS Institute Inc.). Vacas

produzir previsões mais precisas ( Gianola et al., 2011; Felipe sem PC disponível foram excluídas das análises de predição de

et al., 2015). As RNA são inspiradas no sistema nervoso CMS. CMS médio semanal fora do intervalo de Q1 ÿ 1,5(Q3 ÿ

humano, e Q1) e Q3 + 1,5(Q3 ÿ Q1)

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8259

Tabela 1. Estatísticas descritivas dos dados, média e DP do CMS, produção de leite, peso corporal metabólico, idade ao parto, DIM das vacas registradas e número total de vacas e

registros

Canadá Estados Unidos Dinamarca Todos

Variável1 Significar SD Significar SD Significar SD Significar SD

CMS média semanal (kg/d) 18,70 3,76 19,36 3,58 19,84 3,49 18,99 3.71

Dia do teste MY (kg/d) 33,33 6,76 41,39 7,71 34,50 7,37 35,19 7.76

Dia do teste FY (g/d) 1.329,78 299,71 1.522,19 302,47 1.347,35 270,32 1.372,74 306,55

PY do dia do teste (g/d) 1.061,79 201,06 1.159,05 200,47 1.204,62 232,34 1.101,10 212,79

MBW 132,02 9,72 123,84 8,74 134,62 10,01 130,63 10.22

CA (mês) 28,01 5,99 27,38 5,71 28,92 6,01 27,99 5,95

DIM (d) 122,25 75,89 85,16 70,66 145,01 81,48 117,41 77,76

Número de registros 4.863 1.563 972 7.398

Número de vacas 290 127 92 509

1

MY = produção de leite; FY = rendimento de gordura; PY = rendimento de proteína; MBW = PC metabólico; AC = idade ao parto.

foram considerados outliers e descartados para vacas de primeira kg/d), rendimento de gordura (AF, g/d) e rendimento de proteína

e segunda lactação, onde Q1 e Q3 representam o primeiro e (PY, g/d), MBW, idade ao parto (AC), ano de parto, época de

terceiro quartis, respectivamente. As estatísticas descritivas dos parto, DIM, número de lactação, país , e informações sobre o

registros fenotípicos são apresentadas na Tabela 1. rebanho estavam disponíveis. Sete conjuntos diferentes

O registro do DMI foi focado em diferentes estágios da lactação de preditores (variáveis independentes) foram projetados para

nos Estados Unidos (início da lactação), Canadá (pós-pico da prever a média semanal de CMS de vacas individuais usando

lactação) e Dinamarca (meio da lactação), então, juntos, os ANN. As médias semanais foram utilizadas neste estudo porque

conjuntos de dados dos 3 países cobriram mais do toda a tendem a representar melhor a eficiência das vacas, já que o

lactação (Tabela 1). CMS e outras características de eficiência alimentar apresentam

alta variabilidade diária (Seymour et al., 2020). Além disso, as

avaliações genéticas e genômicas oficiais para eficiência

Dados de espectroscopia de refletância de infravermelho

médio e pré-tratamentos alimentar no Canadá também são baseadas em médias semanais

(Jamrozik e Kistemaker, 2020). Os conjuntos preditores diferem

Para cada amostra de leite, os dados MIRS do leite continham pelos preditores incluídos no seguinte: conjunto 1 (MY, AC e

1.060 WL na faixa infravermelha de 925 a 5.008 cm-1. DIM), conjunto 2 (MY, FY, PY, AC e DIM), conjunto 3 (MY, FY,

Devido à alta absorção de água, os dados MIRS de regiões entre PY, MBW, AC, e DIM), conjunto 4 (505 WL, AC e DIM), conjunto

1.600 a 1.700 cm-1 e > 3.005 cm-1 foram removidos (Shetty et 5 [MY, MBW, AC, DIM e 36 componentes principais (PC)

al., 2017). explicando mais de 99% da variação MIR WL], conjunto 6 (MY,

Os pré-tratamentos espectrais são frequentemente aplicados FY, PY, MBW, AC, DIM e 36 PC de MIR WL), conjunto 7 (MY,

aos dados do MIRS para obter modelos de previsão robustos FY, PY, MBW, AC, DIM e 505 MIR WL). Em todas as análises,

(Rinnan et al., 2009). Nesta pesquisa, a correção de dispersão os efeitos fixos de classificação de país, estação de parto e

multiplicativa (Martens e Naes, 1989) foi adotada para reduzir o número de lactação sempre foram incluídos nos modelos de

ruído no espectro. Este método de pré-processamento leva em predição. Vale ressaltar que FY e PY foram valores previstos a

conta variações de dispersão de luz em dados espectrais e partir dos espectros do leite.

remove não linearidades induzidas por dispersão de partículas

(Martens e Naes, 1989). Nos conjuntos 1 a 3, o modelo mais simples (ou seja, MY, AC e

As primeiras derivadas de Savitzky-Golay (Savitzky e Golay, DIM) foi considerado primeiro e, em seguida, mais preditores

1964), usando largura de filtro 7 e um polinômio de segunda foram adicionados um a um, mas sem incluir os dados do MIRS.

ordem, também foram aplicadas aos dados espectrais. Os pré- O conjunto 4 foi considerado para avaliar quanto da variação

tratamentos de espectros de primeira derivada são comumente DMI poderia ser explicada usando apenas 505 comprimentos de

usados para melhorar a resolução e para aguçar as bandas de onda MIR. No conjunto 5, FY e PY do conjunto 3 foram

absorção em amostras espectrais (Savitzky e Golay, 1964). Após substituídos por 36 PC de MIRS para avaliar se os dados do

os pré-tratamentos, um total de 505 WL de cada amostra de leite MIRS poderiam ou não melhorar a previsão de CMS em

estava disponível para análise. comparação com o uso de componentes não específicos do leite

(ou seja, FY e PY). Componentes principais foram usados porque

Conjuntos de Preditores em RNA, à medida que o número de neurônios aumenta, o

número de parâmetros a serem estimados também aumenta

Para cada registro de espectro de leite, a média semanal drasticamente, o que pode levar a um problema de overfitting.

No conjunto 6, 36 PC de MIRS foram adicionados aos preditores do conjunto

correspondente de CMS (kg/d), produção de leite no dia do teste (MY,

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8260

para investigar se o uso de PC de comprimentos de onda MIR combinados na camada de saída usando w21, w22, ..., w2s

melhoraria ou não a previsão de CMS em comparação com o uso de pesos e um intercepto b. A pontuação linear resultante é convertida

todos os 505 comprimentos de onda, como no conjunto 7. Portanto, no neurônio de saída, desta vez usando uma função de ativação

no conjunto 7, todos os preditores disponíveis, incluindo os dados linear gt(.) para calcular o fenótipo previsto do indivíduo i (para i =

MIRS do leite integral, foram usados para prever o CMS. Vale ressaltar 1, ..., n), como segue:

que no estudo de Dórea et al. (2018), os comprimentos de onda MIR

selecionados (ou seja, 33 comprimentos de onda MIR), usando um ÿ s ÿ

[]t

ÿ

ÿ ÿ

método de manta Markov, melhoraram a previsão DMI por ANN em ygb = +

eu t

ÿ

ÿ

wz 2 ti

ÿ

ÿ

, [2]

ÿ

ÿ t= 1

comparação com o uso de todos os comprimentos de onda MIR (ou ÿÿ ÿ

seja, 361 comprimentos de onda MIR).

onde yi é o fenótipo do animal i, e todos os outros termos foram

previamente definidos.

Modelos de ANN

O treinamento da ANN inclui a minimização de uma função de erro

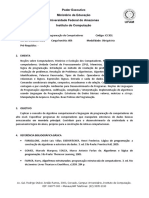

O perceptron feed-forward de 2 camadas, também conhecido como que depende dos pesos sinápticos da rede (w na Figura 1) e vieses.

rede neural feed-forward de camada oculta única, é uma forma Esses pesos e vieses são atualizados iterativamente para aproximar

comumente aplicada de ANN para regressão. Essas RNA possuem a variável alvo por um algoritmo de aprendizado. Back-propagation é

uma camada de entrada de nós de origem e uma unidade de saída um algoritmo de aprendizado supervisionado baseado em uma função

que estão totalmente conectadas, com apenas uma camada oculta de erro apropriada, cujos valores são especificados pelo alvo (isto é,

entre eles, conforme mostrado na Figura 1. Esse tipo de rede pode média semanal DMI) e pelas saídas previstas da rede (isto é, valores

aproximar bem a maioria das funções matemáticas, portanto são ajustados médios semanais de DMI). Um algoritmo de retropropagação

aproximadores universais de lineares e funções não lineares (Alados é aplicado para determinar pesos e vieses em uma arquitetura

et al., 2004). Matematicamente, é possível visualizar o mapeamento perceptron multicamada para minimizar o erro quadrático médio

dessas RNA como uma regressão em 2 etapas (Hastie et al., 2009). usando métodos de gradiente descendente (Okut et al., 2011). Com

A ideia principal é extrair combinações lineares das entradas como base na entrada e na saída favorecida, os pesos e vieses da RNA

funções de base na camada oculta e, em seguida, modelar o alvo na são atualizados continuamente durante o processo de treinamento.

camada de saída como uma função dessas funções de base (Ehret Em cada iteração de treinamento, um perceptron multicamadas

et al., 2015). Na camada oculta, as variáveis explicativas xij (para j = consiste em 2 etapas: as etapas de avanço e retropropagação. Na

1, …, m, onde m etapa de feedforward, as entradas passam pela rede neural da

camada de entrada em direção à camada de saída e, passando pelos

indica o número de variáveis explicativas) de um indivíduo i (para i = neurônios da camada oculta e da camada de saída, com base nos

1, ..., n, onde n é o número de indivíduos) são combinados linearmente pesos, vieses e funções ativadoras do rede neural, eles cedem às

com um vetor peso determinado na fase de treinamento, mais um saídas da rede neural. O back-propagation step back propaga os erros

w1

[]t intercepto em (também chamado de “bias” na terminologia ANN), na rede e minimiza a função de erro atualizando pesos e bias na

j direção de descida mais íngreme (negativo do gradiente) para diminuí-

com t = 1, s denotando o número de neurônios na camada oculta. A

la (Beale et al., 2010). Os passos para frente e para trás são

..., pontuação linear resultante é então convertida em

executados recorrentemente até que a solução da RNA corresponda

ao valor favorecido dentro de um limite pré-especificado (Haykin,

gerar a saída do único neurônio oculto zi 2009; Hajmeer et al., 2006).

[]t()

usando uma função de ativação ft (.), como segue:

ÿ m ÿ

[]t ÿ

[]t ÿ

[1]

ÿ

ÿ

z

fat = + largura ÿ

,

eu

ÿ

t ÿÿ x1j eu j

j=1

ÿÿ ÿÿ

ÿ ÿ

Semelhante a outros métodos paramétricos e não paramétricos,

onde todos os termos foram previamente definidos. como regressão de kernel e splines de suavização, a ANN pode levar

A função de ativação da tangente hiperbólica ao overfitting e o modelo de previsão pode mostrar baixa generalização

ÿ

e

x ÿ

e

ÿ

x ÿ (Guo et al., 2003; Feng et al., 2006; Wang et al., 2009). O overfitting

pode ser usado nos neurônios ocultos

ÿ ÿ

tanh x resulta de um número excessivo de parâmetros estimados e pode

ÿ

ÿ

ÿ

ÿ

()= x ÿ

x ÿÿ

e + e

ÿ ÿ ocorrer devido ao aumento do número de neurônios na camada oculta

modelar a relação não linear entre fenótipo e entrada, o que permite (Alados et al., 2004).

que a RNA tenha maior flexibilidade do que os modelos de regressão

linear convencionais (MacKay e Mac Kay, 2003). As saídas das A regularização bayesiana e a parada antecipada com validação

funções de base, resultantes da camada oculta, são linearmente cruzada (CVES) são 2 métodos padrão para evitar o superajuste na

ANN. Ao contrário do treinamento de rede padrão

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8261

[]t

Figura 1. Arquitetura de uma rede neural feed-forward de 2 camadas: xij = entrada da rede; c 1j = peso da rede desde a entrada até a camada oculta;

w2t = peso da rede da camada oculta para a camada de saída; at = intercepto (também chamado de viés), com t = 1, ..., s, denotando o número de neurônios

na camada oculta; b = interceptação do neurônio da camada de saída; yi = saída da rede (por exemplo, DMI predito do indivíduo); ft (.) = função de ativação

nos neurônios ocultos; gt (.) = função de ativação no neurônio de saída, onde o subscrito i refere-se aos indivíduos (de 1 a n), j refere-se às variáveis

explicativas (de 1 a m) e t refere-se ao número de neurônios (de 1 a s).

método, onde um conjunto ideal de pesos e vieses é selecionado F = ÿ | |ED w

D ( M, )+ Eÿ

w(

c ) M , [3]

minimizando uma função de erro, o método bayesiano inclui uma

distribuição de probabilidade de pesos de rede. Consequentemente,

onde ED ( ) D w| ,M e Ew ( ) w M| são a soma dos erros de

as previsões da rede também vêm de uma distribuição de

previsão ao quadrado e pesos, respectivamente, considerando o

probabilidade (Sorich et al., 2003). A função objetivo em RNA

conjunto de dados de calibração (D), pesos de rede (w) e

bayesiana (por exemplo, BRANN) tem um termo adicional que

arquitetura (M). Os ÿ e ÿ são parâmetros de regularização que

penaliza pesos grandes e introduz viés nas estimativas de

devem ser estimados conforme Foresee e Hagan, (1997). O

parâmetros em direção a valores considerados plausíveis, ao

segundo termo do lado direito da Equação [3], conhecido como

mesmo tempo em que diminui sua variância. Assim, existe um

decaimento do peso, promove valores baixos de w e alivia a

trade-off bias-variância que visa obter um mapeamento mais

tendência do modelo de superajustar os dados. Portanto, o

suave (Okut et al., 2011). Em seguida, a otimização baseada em

treinamento envolve um trade-off entre a complexidade do

gradiente é usada para minimizar a seguinte função (F), que é

modelo e a qualidade do ajuste (Tit terington, 2004).

equivalente a uma verossimilhança logarítmica penalizada:

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8262

Com a técnica CVES, os dados de calibração são divididos em Parâmetros de ajuste

conjuntos de treinamento e validação. O treinamento da RNA

envolve um processo iterativo. Primeiramente, é realizada a No aprendizado de máquina, os algoritmos geralmente têm um

estimativa dos pesos e vieses da RNA, usando o conjunto de conjunto de parâmetros de ajuste que influenciam como o algoritmo

treinamento e, em seguida, esses parâmetros estimados são de aprendizado ajusta os dados. Por exemplo, o número de

aplicados para calcular os erros de predição no conjunto de camadas, o número de neurônios em cada camada, a taxa de

validação. À medida que o procedimento itera, os parâmetros aprendizado e outros recursos em uma RNA perceptron

estimados usando os dados de treinamento são aplicados para multicamada são parâmetros de ajuste, também chamados de

fazer previsões no conjunto de validação para determinar quais hiperparâmetros. Neste estudo, os hiperparâmetros foram

parâmetros estimados geram os erros médios de previsão mais escolhidos usando validação cruzada (ou seja, objetivo, épocas,

baixos para os dados de validação. Para evitar o overfitting, o max_fail, min_grad e tempo) e valores padrão do Matlab (ou seja,

treinamento para quando o erro no conjunto de validação aumenta mu, mu_dec, mu_inc, mu_max, sigma e lambda), pois eles são

em um determinado número de épocas sucessivas (iterações). considerados valores ótimos para a maioria dos problemas de

As estimativas de parâmetros da ANN com o melhor desempenho regressão. Informações detalhadas sobre os hiperparâmetros

no conjunto de validação são então usadas para avaliar o podem ser encontradas na Tabela 2. Para todos os conjuntos de

capacidade preditiva da rede (Okut et al., 2013). preditores, os hiperparâmetros definidos foram mantidos constantes.

Neste estudo, os algoritmos de treinamento Levenberg-

Marquardt (LM), gradiente conjugado escalado (SCG) e

regularização bayesiana (BR) foram aplicados para treinar a RNA. Avaliação da robustez do modelo de previsão

Detalhes adicionais sobre LM, SCG e BR podem ser encontrados

em Hagan e Menhaj (1994), Møller (1993) e MacKay (1992), Dois tipos de validação cruzada de 10 vezes foram

respectivamente. O método CVES foi aplicado para LM e SCG implementados para avaliar as habilidades preditivas da RNA.

para evitar overfitting. Cada conjunto de validação consistia em O primeiro consistia em excluir 10% de todos os registros de

10% de todos os dados escolhidos aleatoriamente do conjunto de animais no Canadá, Dinamarca e Estados Unidos (validação A), e

calibração. Daqui em diante, ANN com algoritmos de treinamento o segundo consistia em excluir 10% de todas as vacas no Canadá,

BR, LM e SCG são referidos como BRANN, LMANN e SCGANN , Dinamarca e Estados Unidos (validação B). Os dados foram

respectivamente. divididos em 10 subconjuntos. Um subconjunto (o conjunto de

teste) foi descartado para avaliar a capacidade preditiva do modelo

de CMS apenas de vacas canadenses, enquanto os outros 9

Desenvolvimento de modelo

subconjuntos foram usados como conjuntos de calibração para

Para o ajuste da RNA foi utilizado o Matlab (Beale et al., 2010). estimar os parâmetros do modelo. Durante as execuções de

Cada rede tinha 3 camadas (isto é, camadas de entrada, ocultas validação cruzada, cada um dos 10 subconjuntos foi usado uma

e de saída). Duas combinações de funções de ativação foram vez como conjunto de teste. Tal procedimento foi aplicado para

aplicadas: (1) um conjunto de funções de ativação linear da evitar ter os mesmos dados de calibração dos Estados Unidos e

Dinamarca em todas as validações cruzadas de 10 vezes, o que

camada de entrada para a camada oculta e da camada oculta

para a camada de saída, e (2) um conjunto de funções de ativação causaria dependência nos conjuntos de calibração. Portanto, do

sigmoide da tangente hiperbólica da camada de entrada camada número total de vacas (ou registros) no conjunto de teste, em

para a camada oculta, mais uma função de ativação linear da média, 29 (486 registros) eram vacas canadenses (registros) e

camada oculta para a camada de saída. No conjunto 1, o número foram usadas para avaliar a capacidade de predição dos modelos.

de neurônios na camada oculta era constante e igual a um, mas

no conjunto 2 o número de neurônios na camada oculta variava A capacidade preditiva dos modelos de RNA nos conjuntos de

de 1 a 10. O primeiro e o segundo conjuntos de RNA foram teste foi avaliada com base em sua precisão [r; ou seja, o

chamados de RNA linear e não linear , respectivamente. Conforme coeficiente de correlação de Pearson entre os valores médios

afirmado por Gianola et al. (2011) e Pérez-Rodríguez et al. (2013), semanais de DMI observados e previstos, a raiz do erro quadrático

BRANN linear pode produzir resultados aproximadamente médio (RMSE) e a razão entre o desempenho e o desvio (RPD),

correspondentes a BLUP e regressão de crista. Antes do que é o desvio padrão do DMI dividido pelo RMSE. Antes de cada

processamento, o Matlab redimensiona automaticamente todas validação cruzada de 10 vezes, 10 réplicas usando diferentes

as variáveis de entrada e saída usando a função “mapminmax” valores iniciais para pesos e vieses foram aplicadas a cada

para aumentar a estabilidade numérica no intervalo [ÿ1, +1]. arquitetura de RNA. Os valores iniciais foram escolhidos

aleatoriamente para evitar que o algoritmo de treinamento da rede

Esse dimensionamento de recursos garante que todas as fontes neural artificial ficasse preso no mínimo local da função de erro.

de dados sejam tratadas igualmente na fase de treinamento, o Dessas 10 réplicas, o parâmetro estimado da réplica com a

que geralmente tem um grande efeito nas soluções finais (Hastie correlação máxima de Pearson

et al., 2009).

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8263

coeficiente entre valores preditos e observados no conjunto ajuste para comparações múltiplas. O modelo ANOVA incluiu

de calibração (para BRANN) ou conjunto de treinamento (para amostras de 10 vezes como um fator aleatório (ou seja,

LMANN e SCGANN) foi aplicado para avaliar a robustez bloqueio para amostras de 10 vezes) e conjuntos preditores,

preditiva da RNA no conjunto de teste correspondente. modelos (ou seja, regressão linear e não linear ANN e PLS),

algoritmos de treinamento, métodos de validação e conjuntos

preditores como fixos fatores categóricos.

Regressão Parcial de Mínimos Quadrados

RESULTADOS

Para fins de comparação com estudos anteriores, a

regressão PLS também foi aplicada para prever o CMS, As comparações entre conjuntos preditores, modelos e

usando o pacote PLS em R (Mevik et al., 2013). O número algoritmos de treinamento foram muito semelhantes no

ideal de variáveis latentes para o modelo de regressão PLS método de validação A ou B, mas a validação B produziu

para cada validação cruzada de 10 vezes foi determinado estatísticas de ajuste consistentemente mais baixas do que a

usando a correlação máxima de Pearson entre DMI observado validação A (P < 0,0001; Tabela Suplementar S1, https://doi.org/

e previsto nos conjuntos de validação (ou seja, os 10% de 10.5281/zenodo.6632059; Shadpour et al., 2022). Como a

todos os dados escolhidos aleatoriamente de o conjunto de validação B é mais prática, pois o DMI de novos animais é

calibração) quando o número de variáveis latentes foi alterado previsto, apenas os resultados da validação B são

de 1 para 100 para os conjuntos 4 e 7 (para reduzir o número apresentados e discutidos a seguir, com análises estatísticas

de variáveis latentes) e de 1 para o número de preditores para detalhadas fornecidas na Tabela Suplementar S2 (https://

os outros conjuntos. Em seguida, o número ideal determinado doi.org/10.5281/zenodo.6632059 ; Shadpour et al., 2022). Os

de variáveis latentes foi usado para fazer um modelo de resultados da validação A são fornecidos nas Tabelas

previsão usando os dados de calibração correspondentes (ou Suplementares S3 e S4 (https://doi.org/

seja, dados de treinamento e validação) para cada 10.5281/zenodo.6632059; Shadpour et al., 2022). Além disso,

Validação cruzada de 10 vezes. são apresentadas apenas comparações estatísticas para

precisão de previsão, porque os resultados para RMSE e RPD

Testes Estatísticos seguiram tendências semelhantes.

Diferenças nas estatísticas de ajuste (ou seja, r, RMSE e descrição de dados

RPD) entre 7 conjuntos de preditores (ou seja, conjuntos de

preditores), 3 tipos de algoritmos de treinamento (ou seja, BR, Os valores fenotípicos médios dos diferentes conjuntos de

LM e SCG), regressão linear e não linear ANN e PLS e 2 tipos preditores para as 509 vacas, nos dias em que os dados do

de métodos de validação (ou seja, validações A e B) foram MIRS estavam disponíveis, estão resumidos na Tabela 1.

testados via SAS PROC GLM, usando Scheffé CMS médio semanal e seus correspondentes dias de teste MY, FY,

Tabela 2. Hiperparâmetros usados nas redes neurais artificiais (ANN) baseadas nos algoritmos de treinamento Levenberg-Marquardt (LMANN),

gradiente conjugado escalonado (SCGANN) e regularização bayesiana (BRANN)

ANN linear ANN não linear

Hiperparâmetro1 BRANN LMANN SCGANN BRANN LMANN SCGANN

0

épocas 0 70 0 0 10.000 0 50 0 1.000

de meta —

3.000

—

300

max_fail min_grad 1e-100 70 6 1e-100 1e-100 50 6 1e-100

tempo infinito 1e-100 infinito infinito 1e-100 infinito

mu 0,005 infinito 0,001 — 0,1 0,005 infinito 0,001 —

mu_dec 0,1 10 —

0,1 0,1 —

mu_inc 10 —

10 10 —

mu_max 1e10 1e10 —

1e10 1e10 —

sigma

— —

5.0e-5 — —

5.0e-5

lambda — —

5.0e-7 — —

5.0e-7

1

meta = meta de desempenho; epochs = número máximo de épocas para treinar; max_fail = máximo de falhas de validação; min_grad = gradiente

mínimo de desempenho; time = tempo máximo para treinar em segundos; mu = momento inicial; mu_dec = mu fator de diminuição; mu_inc = fator

de aumento mu; mu_max = mu máximo; sigma = determina a mudança no peso para a aproximação da segunda derivada; lambda = parâmetro

para regular a indefinição do Hessian. Os primeiros 5 hiperparâmetros (ou seja, objetivo, epochs, max_fail, min_grad e time) foram escolhidos

usando validação cruzada. Os outros hiperparâmetros (ou seja, mu, mu_dec, mu_inc, mu_max, sigma e lambda) eram valores padrão do Matlab,

que são ótimos para a maioria dos problemas de regressão.

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8264

Tabela 3. Estatísticas de ajuste das redes neurais artificiais (ANN) usando o algoritmo de treinamento de regularização bayesiana (BRANN) para prever a média semanal de CMS

em gado leiteiro holandês canadense usando a validação B (baseada em vacas individuais) nos conjuntos de teste1

Set2 capacidade preditiva eu NN1 NN2 NN3 NN4 NN5 NN6 NN7 NN8 NN9 NN10

1 r 0,471 0,526 0,529 0,546 0,533 0,537 0,537 0,530 0,539 0,534 0,532

RMSE 3,332 3,230 3,212 3,165 3,203 3,195 3,205 3,217 3,201 3,217 3.227

RPD 1,114 1,149 1,156 1,172 1,159 1,162 1,158 1,154 1,160 1,153 1.150

2 r 0,488 0,531 0,556 0,554 0,554 0,563 0,572 0,581 0,576 0,575 0,569

RMSE 3,314 3,220 3,145 3,142 3,144 3,123 3,101 3,087 3,091 3,105 3.120

RPD 1,120 1,154 1,181 1,181 1,181 1,188 1.197 1,202 1,200 1,194 1.189

3 r 0,510 0,543 0,576 0,577 0,572 0,575 0,593 0,577 0,591 0,588 0,577

RMSE 3,267 3,194 3,104 3,095 3,104 3,099 3,047 3,097 3,065 3,077 3.121

RPD 1,136 1,162 1,196 1,198 1,196 1,199 1,218 1,197 1,210 1,206 1.190

4 r 0,636 0,637 0,641 0,653 0,65 0,654 0,654 0,651 0,634 0,656 0,635

RMSE 2,915 2,909 2,905 2,863 2,893 2,895 2,875 2,924 2,964 2,909 2.983

RPD 1,273 1,275 1,276 1,296 1,282 1,283 1,292 1,268 1,253 1,275 1.244

5 r 0,652 0,655 0,663 0,682 0,691 0,714 0,710 0,706 0,711 0,714 0,698

RMSE 2,866 2,860 2,833 2,770 2,732 2,643 2,674 2,696 2,665 2,649 2.724

RPD 1,293 1.297 1,309 1,340 1,357 1,404 1,388 1,377 1,391 1,402 1.364

6 r 0,658 0,662 0,672 0,693 0,692 0,725 0,716 0,713 0,705 0,707 0,705

RMSE 2,845 2,832 2,805 2,719 2,723 2,600 2,640 2,655 2,685 2,683 2.708

RPD 1,304 1,310 1,322 1,365 1,363 1,427 1,407 1,400 1,384 1,386 1.372

7 r 0,689 0,691 0,692 0,705 0,719 0,729 0,721 0,720 0,708 0,728 0,725

RMSE 2,740 2,728 2,734 2,699 2,650 2,601 2,625 2,630 2,688 2,616 2.625

RPD 1 .354 1,361 1 .357 1 .374 1,400 1 .426 1,414 1 .411 1 .383 1 .421 1.415

1

L = rede neural linear; NN = número de neurônios na camada oculta de redes neurais não lineares. Os resultados mostrados nesta tabela são idades médias com base em uma

validação cruzada de 10 vezes.

2

Os conjuntos de variáveis explicativas usadas são definidos da seguinte forma: (1) MY, AC e DIM; (2) MY, FY, PY, AC e DIM; (3) MY, FY, PY, MBW, AC e DIM; (4) AC, DIM e 505

WL; (5) MY, MBW, AC, DIM e 36 componentes principais de WL; (6) MY, FY, PY, MBW, AC, DIM e 36 componentes principais de WL; e (7) MY, FY, PY, MBW, AC, DIM e 505 WL,

onde MY = produção de leite, AC = idade ao parto, FY = rendimento de gordura, PY = rendimento de proteína, MBW = PC metabólico e WL = Comprimento de onda. Todos os

conjuntos também incluíram país, estação de parto e número de lactação como efeitos fixos categóricos. A capacidade preditiva do BRANN foi avaliada por meio do coeficiente de

correlação de Pearson calculado entre os valores de DMI observados e preditos (r), a raiz do erro quadrático médio (RMSE) e a razão de desempenho para desvio (RPD).

PY, MBW, AC e DIM foram 18,99 kg, 35,19 kg, 1.372,7 g, para BRANN, 0,472 a 0,55 para LMANN e 0,473 a 0,546 para

1.101,1 g, 130,63 kg 0,75 , 28,0 meses e 117,4 dias, SCGANN. A adição de FY e PY (conjunto 2) melhorou o

respectivamente. desempenho da predição (P < 0,0001).

A precisão preditiva variou de 0,488 a 0,581 para BRANN,

Efeitos Ambientais Categóricos Comuns 0,489 a 0,567 para LMANN e 0,484 a 0,58 para SCGANN.

entre conjuntos

Quando o MBW foi incluído no modelo de previsão (conjunto

Em todos os conjuntos analisados (conjuntos 1-7), país, 3), as estatísticas de ajuste melhoraram (P < 0,0001).

estação de parto e número de lactação sempre foram incluídos A precisão preditiva variou de 0,51 a 0,593 para BRANN,

como efeitos ambientais fixos categóricos. Suas contribuições 0,512 a 0,591 para LMANN e 0,511 a 0,591 para SCGANN.

para a precisão da previsão foram pequenas. Por exemplo,

ao usar BRANN e Validação A, sua contribuição conjunta Quando as características de produção de leite foram

variou de 0,014 a 0,075. As mesmas características para a substituídas por espectros de leite (505 WL) no conjunto 4, a

validação B foram de ÿ0,012 a 0,014. precisão preditiva aumentou consideravelmente (P < 0,0001)

e variou de 0,634 a 0,656 para BRANN, 0,603 a 0,645 para

LMANN e 0,635 a 0,652 para SCGANN.

Comparação entre conjuntos de preditores, modelos e

algoritmos de treinamento usando validação B A substituição de FY e PY pelo PC de WL (conjunto 5)

resultou em uma melhoria maior nas estatísticas de ajuste (P

As estatísticas de ajuste de BRANN, LMANN e CS GANN < 0,0001). A precisão preditiva variou de 0,652 a 0,714 para

para vacas leiteiras da raça Holandesa Canadense usando a BRANN, 0,653 a 0,703 para LMANN e 0,652 a 0,709 para

validação B são apresentadas nas Tabelas 3 a 5, SCGANN. Por outro lado, combinar FY e PY com MY, SMBY

respectivamente. A previsão da média semanal de CMS e o PC de WL (conjunto 6) não teve um efeito importante na

usando MY como a única característica de produção (conjunto previsão de DMI em comparação com o conjunto 5 (P =

1) resultou nas piores estatísticas de ajuste em comparação 0,57 ) . A precisão preditiva variou de 0,658 a 0,725 para

com os outros conjuntos preditores (P < 0,0001, Tabela BRANN, 0,659 a 0,713 para LMANN e 0,658 a 0,707 para

Suplementar S2). A precisão preditiva para o conjunto 1 variou deSCGANN.

0,471 a 0,546

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8265

Tabela 4. Estatísticas de ajuste das redes neurais artificiais (ANN) usando o algoritmo de treinamento de Levenberg-Marquardt (LMANN) para prever a média semanal de CMS em

gado leiteiro holandês canadense usando a validação B (baseada em vacas individuais) nos conjuntos de teste1

Set2 capacidade preditiva eu NN1 NN2 NN3 NN4 NN5 NN6 NN7 NN8 NN9 NN10

1 r 0,472 0,525 0,531 0,542 0,550 0,529 0,529 0,532 0,527 0,540 0,517

RMSE 3,333 3,230 3,208 3,176 3,157 3,209 3,217 3,212 3,225 3,203 3.265

RPD 1.114 1,149 1,157 1,168 1,175 1.157 1,154 1,155 1,151 1,160 1.138

2 r 0,489 0,532 0,556 0,558 0,552 0,558 0,567 0,555 0,553 0,553 0,560

RMSE 3,305 3,217 3,141 3,131 3,157 3,125 3,107 3,144 3,159 3,162 3.137

RPD 1,123 1,155 1.183 1,185 1,176 1,189 1,195 1,181 1,174 1,172 1.184

3 r 0,512 0,542 0,575 0,577 0,567 0,578 0,591 0,581 0,574 0,565 0,558

RMSE 3,262 3,195 3,103 3,097 3,115 3,098 3,058 3,116 3,115 3,157 3.159

RPD 1,137 1,162 1,196 1,198 1,192 1,197 1,214 1,191 1,191 1,175 1.175

4 r 0,643 0,645 0,633 0,635 0,631 0,625 0,617 0,625 0,634 0,603 0,619

RMSE 2,897 2,889 2,934 2,95 2,978 2,989 3,044 3,038 3,02 3,14 3.097

RPD 1,281 1,284 1,265 1,258 1,246 1,243 1,223 1,221 1,227 1,183 1.199

5 r 0,653 0,656 0,665 0,672 0,697 0,700 0,703 0,695 0,696 0,694 0,694

RMSE 2,864 2,854 2,827 2,798 2,714 2,714 2,694 2,729 2,709 2,724 2.765

RPD 1,295 1,300 1,313 1,326 1,367 1,366 1,377 1,361 1,370 1,362 1.341

6 r 0,659 0,663 0,675 0,686 0,698 0,713 0,704 0,702 0,699 0,703 0,703

RMSE 2,843 2,831 2,793 2,748 2,706 2,661 2,697 2,695 2,724 2,696 2.716

RPD 1,305 1,311 1,328 1,350 1,372 1,395 1,377 1,379 1,361 1,377 1.368

7 r 0,695 0,703 0,690 0,702 0,703 0,699 0,679 0,680 0,679 0,691 0,682

RMSE 2,719 2,685 2,754 2,709 2,706 2,753 2,827 2,848 2,824 2,806 2.832

RPD 1,365 1 .382 1,349 1. 370 1,369 1,350 1,312 1 .308 1. 315 1,324 1.313

1

L = rede neural linear; NN = número de neurônios na camada oculta de redes neurais não lineares. Os resultados mostrados nesta tabela são idades médias com base em uma

validação cruzada de 10 vezes.

2

Os conjuntos de variáveis explicativas usadas são definidos da seguinte forma: (1) MY, AC e DIM; (2) MY, FY, PY, AC e DIM; (3) MY, FY, PY, MBW, AC e DIM; (4) AC, DIM e 505

WL; (5) MY, MBW, AC, DIM e 36 componentes principais de WL; (6) MY, FY, PY, MBW, AC, DIM e 36 componentes principais de WL; e (7) MY, FY, PY, MBW, AC, DIM e 505 WL;

onde MY = produção de leite, AC = idade ao parto, FY = produção de gordura, PY = produção de proteína, MBW = PV metabólico e WL = comprimento de onda. Todos os conjuntos

também incluíram país, estação de parto e número de lactação como efeitos fixos categóricos. A capacidade preditiva do LMANN foi avaliada usando o coeficiente de correlação de

Pearson calculado entre os valores de DMI observados e preditos (r), a raiz do erro quadrático médio (RMSE) e a razão de desempenho para desvio (RPD).

Tabela 5. Estatísticas de ajuste das redes neurais artificiais (ANN) usando o algoritmo de treinamento de gradiente conjugado (SCGANN) para prever a média semanal de CMS em

gado leiteiro holandês canadense usando a validação B (baseada em vacas individuais) nos conjuntos de teste1

Set2 capacidade preditiva eu NN1 NN2 NN3 NN4 NN5 NN6 NN7 NN8 NN9 NN10

1 r 0,473 0,525 0,527 0,546 0,545 0,532 0,536 0,539 0,530 0,526 0,539

RMSE 3,331 3,230 3,216 3,165 3,176 3,200 3,201 3,193 3,219 3,246 3.197

RPD 1,114 1,149 1,155 1,172 1,169 1,159 1,160 1,162 1,154 1,143 1.160

2 r 0,484 0,532 0,557 0,554 0,563 0,565 0,580 0,566 0,580 0,561 0,562

RMSE 3,315 3,217 3,141 3,140 3,125 3,117 3,090 3,126 3,088 3,142 3.145

RPD 1,120 1,155 1.183 1,182 1,188 1,191 1,201 1,188 1,202 1,181 1.181

3 r 0,511 0,543 0,575 0,577 0,577 0,584 0,591 0,578 0,574 0,584 0,584

RMSE 3,261 3,193 3,102 3,091 3,083 3,072 3,050 3,097 3,097 3,092 3.084

RPD 1,137 1,163 1.197 1,200 1,204 1,208 1,218 1,198 1,198 1.200 1.204

4 r 0,640 0,635 0,642 0,645 0,652 0,652 0,641 0,65 0,646 0,643 0,635

RMSE 2,906 2,917 2,903 2,914 2,891 2,898 2,945 2,922 2,94 2,98 3.005

RPD 1,277 1,272 1.277 1,272 1.284 1,279 1,258 1,269 1,261 1,246 1.235

5 r 0,652 0,655 0,661 0,686 0,695 0,701 0,694 0,709 0,693 0,690 0,700

RMSE 2,865 2,856 2,844 2,751 2,715 2,692 2,735 2,682 2,731 2,757 2.703

RPD 1,294 1,298 1,305 1,348 1,367 1,381 1,357 1,384 1,360 1,346 1.374

6 r 0,658 0,661 0,675 0,689 0,697 0,701 0,702 0,706 0,692 0,707 0,703

RMSE 2,847 2.834 2,782 2,743 2,723 2,712 2,705 2,682 2,743 2,693 2.695

RPD 1,303 1.309 1,332 1,352 1,363 1,369 1,374 1,383 1,352 1,379 1.377

7 r 0,692 0,692 0,695 0,700 0,711 0,717 0,717 0,705 0,726 0,720 0,710

RMSE 2,730 2,727 2,726 2,703 2,673 2,655 2,650 2,697 2,626 2,655 2.692

RPD 1,359 1,361 1,361 1 .374 1,387 1 0,395 1,399 1,375 1. 415 1,395 1.380

1

L = rede neural linear; NN = número de neurônios na camada oculta de redes neurais não lineares. Os resultados mostrados nesta tabela são idades médias com base em uma

validação cruzada de 10 vezes.

2

Os conjuntos de variáveis explicativas usadas são definidos da seguinte forma: (1) MY, AC e DIM; (2) MY, FY, PY, AC e DIM; (3) MY, FY, PY, MBW, AC e DIM; (4) AC, DIM e 505

WL; (5) MY, MBW, AC, DIM e 36 componentes principais de WL; (6) MY, FY, PY, MBW, AC, DIM e 36 componentes principais de WL; e (7) MY, FY, PY, MBW, AC, DIM e 505 WL;

onde MY = produção de leite, AC = idade ao parto, FY = produção de gordura, PY = produção de proteína, MBW = PV metabólico e WL = comprimento de onda. Todos os conjuntos

também incluíram país, estação de parto e número de lactação como efeitos fixos categóricos. A capacidade preditiva do SCGANN foi avaliada usando o coeficiente de correlação

de Pearson calculado entre os valores de DMI observados e previstos (r), a raiz do erro quadrático médio (RMSE) e a razão de desempenho para desvio (RPD).

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8266

O uso de todos os WL combinados com MY, FY, PY e MBW (ou 1), conjuntamente os conjuntos de dados dos 3 países abrangidos

seja, conjunto 7) resultou nas melhores estatísticas de ajuste em mais de toda a lactação.

comparação com os outros conjuntos (P < 0,0001). A precisão A capacidade de predição do CMS de vacas canadenses usando

preditiva variou de 0,689 a 0,729 para BRANN, 0,679 a 0,703 para dados do Canadá, Dinamarca e Estados Unidos ou apenas dados

LMANN e 0,692 a 0,726 para SCGANN. do Canadá foi muito semelhante, mas foi, em média, um pouco

Para todos os conjuntos preditores, a ANN não linear forneceu melhor quando todos os 3 países foram usados.

melhor capacidade de previsão em comparação com a ANN linear. Como ilustração, a Tabela 7 mostra as estatísticas médias de

A regressão PLS produziu resultados muito semelhantes em encaixe em todas as 11 ANN testadas usando BRANN para prever

comparação com ANN linear (P = 0,99, Tabela 6 e Tabela a média semanal de CMS de vacas canadenses usando o conjunto

Suplementar S2). Para todos os conjuntos, as habilidades preditivas preditor 7, validação B e dados apenas do Canadá ou Canadá,

dos 3 algoritmos de treinamento de rede neural foram semelhantes, Dinamarca e Estados Unidos combinados nos conjuntos de teste

mas o BRANN e o SCGANN tiveram um desempenho ligeiramente para toda a lactação ou diferentes períodos de lactação. Os

melhor do que o LMANN (P < 0,0001). resultados mostram um ajuste geral ligeiramente melhor dos modelos

Neste estudo, dados do Canadá, Dinamarca e Estados Unidos ao usar os conjuntos de dados combinados e um ajuste ligeiramente

foram combinados para aumentar o tamanho e a variabilidade dos melhor no início e no final da lactação quando comparados com o

dados de treinamento e melhorar a generalização dos modelos de uso apenas de dados canadenses. Esses resultados apoiaram o

predição ao longo da lactação. Como o registro do CMS foi focado uso de dados combinados do Canadá, Estados Unidos e Dinamarca

em diferentes estágios da lactação nos Estados Unidos, Canadá e para desenvolver previsões de DMI de canadenses.

Dinamarca (DIM médio de 85 d, 122 d e 145 d, respectivamente,

com desvios padrão variando de 71 a 81 d; Tabela vacas.

DISCUSSÃO

Tabela 6. Estatísticas de ajuste do modelo de regressão de mínimos quadrados

O objetivo do presente estudo foi avaliar a predição da média

parciais (PLS) para prever média semanal de CMS em gado leiteiro Holstein canadense

usando a validação B (baseada em vacas individuais) nos conjuntos de teste semanal de CMS em bovinos leiteiros da raça Holandesa Canadense

usando dados MIRS do leite, além de outros preditores comumente

Set1 Habilidade preditiva2 PLS

disponíveis, incluindo MY, componentes do leite e MBW, usando

1 r 0,467 ANN e PLS, e dados combinados de Canadá e 2 parceiros

RMSE 3.342

1.111

internacionais, Dinamarca e Estados Unidos. previsão precisa de

RPD

2 r 0,486

RMSE 3.313

RPD 1.120

3 r 0,506

RMSE 3.274 Tabela 7. Estatísticas de ajuste médio em todas as 11 redes neurais artificiais (ANN)

RPD 1.133 testadas usando o algoritmo de treinamento de regularização bayesiana (BRANN)

4 r 0,637 para prever a média semanal de CMS em gado leiteiro canadense Holstein em

RMSE 2.916 diferentes períodos de lactação usando o conjunto preditor 7, validação B (com base

RPD 1.273 em individual vacas)1

5 r 0,652

RMSE 2.867 Conjunto de teste

RPD 1.293

6 r 0,658 Estatística2 DIM CA Todos

RMSE 2.845

RPD 1.304 r 5–305 0,708 0,712

7 r 0,665 5–90 0,702 0,712

RMSE 2.821 91–180 0,604 0,593

RPD 1.315 181–305 0,503 0,506

1 RMSE 5–305 2,702 2.667

Os conjuntos de variáveis explicativas usadas são definidos da seguinte forma: (1) 5–90 2,727 2.665

MY, AC e DIM; (2) MY, FY, PY, AC e DIM; (3) MY, FY, PY, MBW, AC e DIM; (4) AC, 91–180 2,607 2.626

DIM e 505 WL; (5) MY, MBW, AC, DIM e 36 componentes principais de WL; (6) MY, 181–305 2,758 2.696

FY, PY, MBW, AC, DIM e 36 componentes principais de WL; e (7) MY, FY, PY, MBW, RDP 5–305 1,376 1.392

AC, DIM e 505 WL; onde MY = produção de leite, AC = idade ao parto, FY = produção 5–90 1,356 1.389

de gordura, PY = produção de proteína, MBW = PV metabólico e WL = comprimento 91–180 1,228 1.217

de onda. Todos os conjuntos também incluíram país, estação de parto e número de 181–305 1,089 1.110

lactação como efeitos fixos categóricos.

1

Os conjuntos de teste incluíram dados apenas do Canadá (CA) ou Canadá, Dinamarca

2

A capacidade preditiva da regressão PLS foi avaliada usando o coeficiente de e Estados Unidos juntos (Todos).

2

correlação de Pearson calculado entre os valores de DMI observados e previstos (r), A capacidade preditiva do BRANN foi avaliada usando o coeficiente de correlação de

a raiz do erro quadrático médio (RMSE) e a razão de desempenho para desvio (RPD). Pearson calculado entre os valores de DMI observados e preditos (r), a raiz do erro

Os resultados mostrados nesta tabela são médias baseadas em uma validação quadrático médio (RMSE) e a razão de desempenho para desvio (RPD).

cruzada de 10 vezes.

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8267

A média semanal de CMS de vacas individuais pode auxiliar no ing uma predição, o que quase garante que a predição final não

gerenciamento de custos de alimentação e permitir a melhoria venha de dependências entre calibração e conjuntos de teste

genética para o desempenho alimentar, fornecendo dados em (ou seja, todos os recursos não podem ter grandes dependências

larga escala para a previsão de valores genéticos. Conforme entre calibração e conjuntos de teste ao mesmo tempo).

afirmado por Wallén et al. (2018), pelo menos 4.000 novilhas

genotipadas e fenotipadas precisam ser adicionadas anualmente

à população de referência para melhorar geneticamente a Conjuntos de Preditores

eficiência alimentar usando seleção genômica. Fornecer a um

número tão grande de animais medidas de consumo de ração O desempenho preditivo de 7 combinações diferentes de

a baixo custo é um desafio. Uma solução possível para superar conjuntos de preditores foi investigado neste estudo.

esse dilema é a medição indireta do consumo de ração a partir Wallen et al. (2018) avaliaram a predição de CMS em vacas

de outros dados disponíveis, como o MIRS. Portanto, é de leiteiras Norwegian Red em lactação usando dados PLS e MIRS

particular interesse avaliar a capacidade preditiva das diferentes e relataram menor precisão de predição em comparação com o

combinações de conjuntos de preditores atualmente disponíveis, presente estudo ao usar dados MIRS para prever a média

bem como a utilidade dos modelos ANN e PLS. semanal de CMS. A adição de componentes do leite (ou seja,

FY e PY) ao MY melhorou as previsões médias semanais de

Validação cruzada para avaliar a robustez do modelo CMS, que concordaram com os resultados de Shetty et al.

(2017) e Wallén et al. (2017). Nossos resultados suportam a

A validação cruzada foi usada para identificar o conjunto ideal hipótese de que o MBW contribui para explicar a variação do

de preditores e arquitetura de RNA, e para avaliar a robustez CMS em bovinos leiteiros, porque a capacidade de predição

dos modelos de predição. Os modelos de predição para média melhorou quando o MBW foi adicionado ao modelo.

semanal de IMS foram avaliados usando 2 tipos de validação Esses achados estão de acordo com os resultados de estudos

cruzada de 10 vezes: validação em registros individuais (A) e anteriores em bovinos leiteiros (por exemplo, Shetty et al., 2017;

animais (B). Na validação A, os registros da mesma vaca foram Dórea et al., 2018; Wallén et al., 2018). A melhoria nas

apresentados nos conjuntos de calibração e teste, o que estatísticas de ajuste quando as informações do MIRS foram

provavelmente levou a uma inflação nas previsões do modelo. combinadas com os outros preditores (ou seja, conjuntos 4-7)

Neste contexto, uma situação mais realista foi considerada na indica que o MIRS fornece algumas informações adicionais para

validação B, onde 10% das vacas foram retiradas dos dados de prever a média semanal de CMS. Nesse contexto, deve-se

calibração em cada um dos 10-folds. Portanto, a validação B destacar que a inclusão de todos os MIRS WL (ou seja, conjunto

avaliou como o modelo se comportaria ao prever a média 7) resultou em melhor predição da média semanal de CMS em

semanal de CMS para novas vacas. As dependências de dados comparação com os conjuntos de preditores que incluíram o PC

entre os conjuntos de calibração e teste, que foram relatadas de WL (ou seja, conjuntos 5 e 6). No entanto, quando apenas

quando animais dos mesmos rebanhos são incluídos nos MIRS WL foram incluídos no modelo (conjunto 4), a melhor

conjuntos de dados de calibração e teste, podem inflar o precisão de previsão foi ligeiramente maior do que quando todos

desempenho da previsão (por exemplo, Wang e Bovenhuis, os caracteres de produção foram incluídos no modelo (conjunto

2019; Coelho Ribeiro et al., 2021). No entanto, nem sempre é 2), mostrando que algumas das informações do MIRS podem

assim, como no estudo de Lahart et al. (2019), onde a precisão ser capturadas por meio de sua associação com características de produção

média da previsão de CMS em conjuntos de teste usando Como mencionado anteriormente, a inclusão de FY, PY e

apenas MIRS e MIRS combinados com MY, F%, P%, BW, MBW no conjunto preditor incluindo MY levou a uma melhoria

estágio de lactação e paridade, usando validações cruzadas substancial na previsão média semanal de DMI (conjunto 1 vs.

dentro e entre rebanhos, foi de 0,69, 0,87, 0,55 e 0,80, conjunto 3). Além disso, houve uma melhoria adicional nas

respectivamente. estatísticas de ajuste quando o PC de WL foi incluído no modelo

Existem alguns aspectos no estudo atual que podem sugerir (conjunto 6). No entanto, a remoção de FY e PY quando PC de

que os resultados não foram visivelmente afetados por WL foram incluídos (conjunto 5) não teve um efeito importante

dependências de dados entre a calibração e os conjuntos de teste. nas estatísticas de ajuste.

Nenhum dos 7 conjuntos de variáveis preditivas incluiu o efeito Esses achados podem estar relacionados ao fato de que WL

de manada. A previsão de DMI usando apenas o efeito de pode descrever com precisão os perfis de ácidos graxos e

rebanho resultou em um desempenho de previsão muito ruim proteínas do leite, pois contém informações mais detalhadas

(resultados não mostrados). Isso sugere que o efeito manada sobre ácidos graxos (Soyeurt et al., 2011) e proteínas

não tem uma grande contribuição para a previsão de CMS. (McDermott et al., 2016) em comparação com teores de gordura

Além disso, o BRANN adaptado usou a regularização para lidar e proteína usados no conjunto 3. Achados semelhantes na

com o overfitting. A regularização penaliza pesos grandes e previsão de CMS usando dados MIRS foram relatados por

proporciona um ajuste mais suave. Consequentemente, nos Lahart et al. (2019) para vacas leiteiras em pastejo. Melhoria

significativa na previsão de CMS de vacas alimentadas com TMR também fo

modelos regularizados, todas as características contribuem para fazer

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8268

relatado por Dórea et al. (2018) quando foram usados dados de diferença de progênie para pontuação de marmoreio em gado

ANN e MIRS de leite. No entanto, Shetty et al. (2017) não relataram Angus usando ANN e 2 conjuntos de painéis SNP.

nenhuma capacidade preditiva superior de CMS para modelos que

incluíam MIRS em vez de FY e PY, em vacas sob dieta TMR. Além Utilidade em Aplicações Práticas

disso, Wallén et al. (2018) relataram que incluir apenas MY e BW

no modelo de previsão resultou em precisão semelhante à inclusão Preditores para previsão semanal média de CMS, que incluem

de dados MIRS. MY, componentes do leite (ou seja, FY e PY) e, em menor medida,

MBW, estão disponíveis para muitas vacas.

As precisões de previsão da média semanal de CMS usando Portanto, a questão de interesse é se as informações do MIRS

dados do MIRS neste estudo foram menores do que as de Shetty podem adicionar informações adicionais que não estão disponíveis

et al. (2017), Dórea et al. (2018) e Lahart et al. (2019), mas atualmente. Os resultados do estudo atual mostraram que o melhor

superiores aos relatados por Wallén et al. (2018). As diferenças conjunto preditor para a predição média semanal de DMI consistia

nas precisões entre os estudos podem ser devidas às diferenças em dados MY, FY, PY, MBW e MIRS completo (conjunto preditor

nos tamanhos de amostra usados para desenvolver os modelos de 7). Assim, as informações do MIRS aumentaram a precisão da

previsão, frequência de registro, raças, dietas e métodos de previsão para a média semanal de CMS. Para a ANN linear, a

previsão, bem como ao uso de diferentes conjuntos de dados de precisão da predição do conjunto preditor 7 foi em média 0,19

WL, treinamento e validação. O uso de dados MIRS médios diários pontos maior do que o conjunto 3 em todos os métodos de predição

ou semanais como preditores também pode afetar a precisão da e conjuntos de dados de validação, enquanto o mesmo recurso

previsão (Shetty et al., 2017). para a melhor ANN não linear foi de 0,12. Isso significa que, se os

dados do MIRS forem armazenados, é possível obter uma previsão

mais precisa da média semanal de DMI. No entanto, vale lembrar

Comparação entre linear e não linear que as melhores acurácias de predição foram obtidas usando

ANN e PLS RNA não linear, independentemente do fato de o MIRS ter

contribuído menos para a acurácia geral desses modelos.

As RNA são ferramentas poderosas e flexíveis para modelar

relacionamentos potencialmente não lineares entre variáveis de Uma consideração adicional é a aplicação prática do conjunto

entrada e saída. Neste estudo e em outros (por exemplo, Pe rai et preditor, porque os métodos semanais de previsão de média de

al., 2010; Lin et al., 2012; Dórea et al., 2018), a RNA forneceu CMS devem ser facilmente aplicáveis a fazendas leiteiras

melhores previsões do que os modelos lineares. comerciais. A maioria das variáveis nos conjuntos de preditores

ANN não linear produziu predição superior do que ANN linear e usados neste estudo estão prontamente disponíveis, com a possível

PLS. Além disso, a superioridade da RNA não linear foi mais exceção de BW. Embora o PC não seja acessível em muitas

evidente em conjuntos de preditores que não incluíam informações fazendas leiteiras comerciais, ele pode ser estimado usando, por

de MIRS (ou seja, conjuntos 1–3). Isso concorda com Dórea et al. exemplo, a largura do peito (Veerkamp e Broth erstone, 1997). Os

(2018), que aplicaram ANN e PLS para a previsão de DMI usando dados MIRS do leite são ideais para prever o CMS sem custo

dados MIRS. Esses resultados sugerem que existem algumas adicional, porque tem sido usado atualmente para medir os

interações não lineares entre a média semanal de CMS e os componentes do leite de animais registrados (McParland et al.,

preditores usados. 2014; Shetty et al., 2017).

Comparação entre BRANN, LMANN e SCGANN Conforme observado anteriormente, quando apenas MIR WL

foram incluídos no modelo (conjunto 4), a melhor precisão de

No presente estudo, 3 tipos de algoritmos de treinamento, previsão foi ligeiramente maior do que quando todas as

incluindo BR, LM e SCG, foram aplicados para treinar a RNA. Além características de produção foram incluídas no modelo (conjunto

disso, para atenuar o overfitting e obter modelos que generalizam 2). Vale ressaltar que parte da variação do CMS explicada pelo

bem, foram utilizadas 2 estratégias: regularização (para BRANN) e MIR pode ser captada por meio de sua associação com

CVES (para LMANN e SCGANN). Em geral, BRANN e SCGANN características de produção. Isso pode limitar a aplicação do MIR

produziram melhores previsões médias semanais de DMI em para estimar medidas de eficiência alimentar que levem em

comparação com LMANN. A regularização bayesiana mostrou consideração o nível de produção, como o consumo residual de ração.

previsões não significativas, ligeiramente melhores do que O desenvolvimento da tecnologia de sensores pode oferecer a

SCGANN, mas previsões significativamente melhores na validação oportunidade de incluir preditores mais informativos nos modelos

A (dados não mostrados) em comparação com a validação B. de previsão, como dados climáticos, temperatura corporal da vaca,

Okut et al. (2013) também relataram que o BRANN superou o comportamento alimentar (Dolecheck et al., 2016; Borchers et al.,

SCGANN ao prever o esperado 2017), massa de forragem e oferta em vacas leiteiras pastando

(van Knegsel et al., 2010; Muñoz et

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8269

Beale, MH, MT Hagan e HB Demuth. 2010. Rede neural

al., 2016). Portanto, melhorias adicionais na previsão média semanal de Caixa de ferramentas. Guia do usuário. MathWorks 2:77–81.

DMI podem ser alcançadas quando dados precisos sobre tais preditores Bishop, CM 2006. Redes neurais. Páginas 227–281 em Pattern Regnition and

estiverem disponíveis. Machine Learning. Springer.

Borchers, MR, YM Chang, KL Proudfoot, BA Wadsworth, A.

E. Stone e JM Bewley. 2017. Previsão de parto baseada em aprendizado

CONCLUSÕES de máquina a partir de comportamentos de atividade, deitada e ruminação

em gado leiteiro. J. Dairy Sci. 100:5664–5674. https://doi.org/10.3168/jds

O modelo incluindo sumidouros de energia animal conhecidos .2016-11526.

Coelho Ribeiro, LA, T. Bresolin, GJ de Magãlhaes Rosa, D. Rume Casagrande,

(características de produção e MBW), MIRS e preditores ambientais MAC Danes, and JRR Dórea. 2021. Desembaraçar a dependência de

mostraram a melhor predição da média semanal de CMS em vacas da raça dados usando estratégias de validação cruzada para avaliar a qualidade de

previsão de atividades de pastoreio de gado usando algoritmos de

Holandesa canadense, especialmente quando ANN não linear foi aplicada.

aprendizado de máquina e dados de sensores vestíveis. J. Anim. ciência 99:skab206.

As estatísticas de ajuste superiores de modelos incluindo MIRS em de Haas, Y., JE Pryce, MPL Calus, E. Wall, DP Berry, P.

comparação com modelos sem MIRS sugerem que outros componentes Løvendahl, N. Krattenmacher, F. Miglior, K. Weigel, D. Spurlock, KA

Macdonald, B. Hulsegge e RF Veerkamp. 2015. Previsão genômica do

desconhecidos do leite podem ajudar a explicar a variação na média

consumo de matéria seca em gado leiteiro a partir de um conjunto de

semanal de CMS. No entanto, apenas um ganho marginal na precisão foi dados internacional que consiste em rebanhos de pesquisa na Europa,

observado quando as características de produção e MBW foram incluídas América do Norte e Australásia. J. Dairy Sci. 98:6522–6534. https://doi

no modelo após o MIRS. No entanto, parece que o MIRS prediz o CMS .org/10.3168/jds.2014-9257.

De Marchi, M., V. Toffanin, M. Cassandro e M. Penasa. 2014.

principalmente por meio de sua associação com características de produção Revisão convidada: Espectroscopia de infravermelho médio como ferramenta de

de leite e sua utilidade em estimar uma medida de eficiência alimentar que fenotipagem para características do leite. J. Dairy Sci. 97:1171–1186. https://doi.org/10.3168/

jds.2013-6799.

representa o nível de produção, como o consumo residual de ração, pode

Dolecheck, KA, WJ Silvia, G. Heersche Jr., CL Wood, KJ Mc Querry e JM

ser limitada e necessitaria de mais investigação. Bewley. 2016. Uma comparação entre inseminação artificial em tempo fixo

e monitoramento automatizado da atividade com intervenção hormonal em

3 rebanhos leiteiros comerciais. J. Dairy Sci. 99:1506–1514. https://doi.org/

10.3168/jds.2015-9914.

Dórea, JRR, GJM Rosa, KA Weld e LE Armentano.

AGRADECIMENTOS 2018. Mineração de dados de espectroscopia infravermelha do leite para melhorar as

previsões de ingestão de alimentos em vacas leiteiras em lactação. J. Dairy Sci. 101:5878–

5889. https://doi.org/10.3168/jds.2017-13997.

Os autores reconhecem o apoio financeiro do Efficient Dairy Genome Ehret, A., D. Hochstuhl, D. Gianola e G. Thaller. 2015. Aplicação de redes

Project financiado pela Genome Canada (Ottawa, ON, Canadá), Genome neurais com retropropagação para previsão habilitada por genoma de

características complexas em gado Holandês-Frísio e Alemão Fleckvieh.

Alberta (Cal gary, AB, Canadá), Ontario Genomics (Toronto, ON, Canadá),

Genet. Sel. Evolução 47:22. https://doi.org/10.1186/

Alberta Agriculture and Forestry ( Edmonton, AB, Canadá), Ontario Ministry s12711-015-0097-5.

of Research and Innovation (Toronto, ON, Canadá), Ontario Ministry of Felipe, VPS, MA Silva, BD Valente e GJM Rosa. 2015.

Usando regressão múltipla, redes bayesianas e redes neurais artificiais

Agriculture, Food and Rural Affairs (Guelph, ON, Can ada), Canadian Dairy

para prever a produção total de ovos em codornas européias com base em

Network (Guelph, ON, Canadá) , GrowSafe Systems (Airdrie, AB, Canadá), fenótipos expressos anteriormente. Poult. ciência 94:772–780. https://

Alberta Milk (Edmonton, AB, Canadá), Victoria Agriculture (Melbourne, doi.org/10.3382/ps/pev031.

Feng, N., F. Wang e Y. Qiu. 2006. Nova abordagem para promover a capacidade

Austrália), Scotland's Rural College (Ed inburgh, Reino Unido), USDA

de generalização de redes neurais. Int. J. Processo de Sinal. 2:131–135.

Agricultural Research Service (Beltsville, MD), Qualitas AG (Zug, Suíça) e

Aarhus University (Aarhus, Dinamarca). CF Baes e FS Schenkel também Fleming, A., FS Schenkel, J. Chen, F. Malchiodi, V. Bonfatti, R.

A. Ali, B. Mallard, M. Corredig e F. Miglior. 2017. Previsão do teor de

reconhecem as contribuições financeiras do Dairy Research Cluster 3

ácidos graxos do leite com espectroscopia de infravermelho médio em gado

(Dairy Farmers of Canada and Agriculture and Agri-Food Canada) no âmbito leiteiro canadense usando conjuntos de desenvolvimento de modelos

do Canadian Agricultural Partnership AgriScience Program e do Efficient distribuídos de forma diferente. J. Dairy Sci. 100:5073–5081. https://doi.org/10.3168/

jds.2016-12102.

Dairy Genome Project.

Prever, FD e MT Hagan. 1997. Aproximação de Gauss-Newton para aprendizado

bayesiano. Páginas 1930–1935 em Proceedings of International Conference

on Neural Networks (ICNN'97). IEEE.

Gianola, D., H. Okut, KA Weigel e GJM Rosa. 2011. Prevendo características

quantitativas complexas com redes neurais Bayesianas: um estudo de caso

com vacas Jersey e trigo. BMC Genet. 12:87. https:

//doi.org/10.1186/1471-2156-12-87.

Guo, P., MR Lyu e CLP Chen. 2003. Estimativa do parâmetro de regularização

Os autores não declararam quaisquer conflitos de interesse.

para redes neurais feedforward. IEEE Trans.

Sist. Homem Cibern. B Cibern. 33:35–44. https://doi.org/10.1109/

REFERÊNCIAS TSMCB.2003.808176.

Hagan, MT, e MB Menhaj. 1994. A rede feedforward de treinamento funciona

Alados, I., JA Mellado, F. Ramos e L. Alados-Arboledas. 2004. com o algoritmo de Marquardt. IEEE Trans. Rede Neural 5:989–993. https://

Estimativa da irradiância eritemal UV por meio de redes neurais. doi.org/10.1109/72.329697.

Photochem. Fotobiol. 80:351–358. https://doi.org/10.1562/2004 Hajmeer, M., I. Basheer e DO Cliver. 2006. Curvas de sobrevivência de Listeria

-03-12-RA-111.1. monocytogenes em chouriços modelados com neural artificial

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8270

redes. Microbiol Alimentar. 23:561–570. https://doi.org/10.1016/j energia lazável da farinha de carne e ossos. Poult. ciência 89:1562–1568. https://

.fm.2005.09.011. doi.org/10.3382/ps.2010-00639.

Hastie, T., R. Tibshirani e J. Friedman. 2009. Redes neurais. Pérez-Rodríguez, P., D. Gianola, KA Weigel, GJM Rosa e J.

Páginas 389–416 em The Elements of Statistical Learning: Data Min ing, Cruza. 2013. Um pacote R para ajustar redes neurais regularizadas bayesianas

Inference, and Prediction. 2ª ed. Springer. com aplicações em reprodução animal. J. Anim. ciência 91:3522–3531. https://

Haykin, S. 2009. Percepções multicamadas. Páginas 123–217 em Neural Net Works: doi.org/10.2527/jas.2012-6162.

A Comprehensive Foundation. 3ª ed. Pearson Prentice Hall. Rinnan, A., L. Norgaard, F. van den Berg, J. Thygesen, R. Bro e SB Engelsen. 2009.

Pré-processamento de dados. Páginas 29–50 em Espectroscopia infravermelha

Hemme, T., MM Uddin e OA Ndambi. 2014. Custo comparativo da produção de leite para análise e controle de qualidade de alimentos. Imprensa Acadêmica.

em 46 países. J. Rev. Glob. Econ. 3:254–

270. https://doi.org/10.6000/1929-7092.2014.03.20. Rutten, MJM, H. Bovenhuis, JML Heck e JAM Van Arendonk. 2011. Prevendo a

Jamrozik, J., e GJ Kistemaker. 2020. Avaliação da eficiência alimentar: teste de agosto composição da proteína do leite bovino com base em espectros de infravermelho

de 2020. Acessado em 11 de agosto de 2022. http://www.cdn com transformada de Fourier. J. Dairy Sci. 94:5683–5690. https://doi.org/10.3168/

.ca/Articles/GEBOCT2020/FE%20Report%20-%20September jds.2011-4520.

%202020.pdf. Savitzky, A., e MJE Golay. 1964. Suavização e diferenciação de dados por

Lahart, B., S. McParland, E. Kennedy, TM Boland, T. Condon, M. procedimentos simplificados de mínimos quadrados. Anal. Chem. 36:1627–1639.

Williams, N. Galvin, B. McCarthy e F. Buckley. 2019. Previsão do consumo de https://doi.org/10.1021/ac60214a047.

matéria seca de vacas leiteiras em pastejo usando análise de espectroscopia de Seymour, DJ, A. Cánovas, TCS Chud, JP Cant, VR Osborne, CF Baes, FS Schenkel

re flectância no infravermelho. J. Dairy Sci. 102:8907–8918. https: e F. Miglior. 2020. O comportamento dinâmico da eficiência alimentar em vacas

//doi.org/10.3168/jds.2019-16363. leiteiras primíparas. J. Dairy Sci. 103:1528–1540. https://doi.org/10.3168/

Lin, M.-IB, WA Groves, A. Freivalds, EG Lee e M. Harper. jds.2019-17414.

2012. Comparação de modelos de regressão de rede neural artificial (ANN) e Shadpour, S., TCS Chud, D. Hailemariam, HR Oliveira, G. Plas tow, P. Stothard, J.

mínimos quadrados parciais (PLS) para prever a ventilação respiratória: um Lassen, R. Baldwin, F. Miglior, CF Baes, D. Tulpan e FS Schenkel. 2022. Tabelas

estudo exploratório. EUR. J. Appl. Physiol. 112:1603– Suplementares [Conjunto de dados]. Zenodo. https://doi.org/10.5281/

1611. https://doi.org/10.1007/s00421-011-2118-6. zenodo.6632059.

MacKay, DJC 1992. Interpolação bayesiana. Computação Neural. 4:415–447. https:// Shetty, N., P. Løvendahl, MS Lund e AJ Buitenhuis. 2017.

doi.org/10.1162/neco.1992.4.3.415. Predição e validação do consumo alimentar residual e consumo de matéria seca

MacKay, DJC e DJC MacKay. 2003. Redes neurais. Páginas 468–549 em Teoria da em vacas leiteiras dinamarquesas em lactação usando cópia de espectros de

Informação, Inferência e Algoritmos de Aprendizagem. Cambridge University infravermelho médio do leite. J. Dairy Sci. 100:253–264. https://doi.org/10.3168/

Press. jds.2016-11609.

Martens, H. e T. Naes. 1989. Calibração multivariada. John Willey Sorich, MJ, JO Miners, RA McKinnon, DA Winkler, FR

& Filhos Inc. Burden e PA Smith. 2003. Comparação de algoritmos de classificação linear e

McDermott, A., G. Visentin, M. De Marchi, DP Berry, MA Fénelon, PM O'Connor, OA não linear para a previsão de drogas e metabolismo químico por isoformas de

Kenny e S. McParland. 2016. UDP-glucuronosiltransferase humana.

Predição de proteínas individuais do leite, incluindo aminoácidos livres no leite J. Chem. Inf. Comput. ciência 43:2019–2024. https://doi.org/10

bovino usando espectroscopia de infravermelho médio e suas correlações com .1021/ci034108k.

as características de processamento do leite. J. Dairy Sci. 99:3171–3182. https:// Soyeurt, H., D. Bruwier, J.-M. Romnee, N. Gengler, C. Bertozzi, D.

doi.org/10.3168/jds.2015-9747. Veselko e P. Dardenne. 2009. Estimativa potencial dos principais conteúdos

McParland, S., G. Banos, E. Wall, MP Coffey, H. Soyeurt, RF minerais no leite de vaca usando espectrometria de infravermelho médio. j.

Veerkamp e DP Berry. 2011. O uso da espectrometria de infravermelho médio Dairy Sci. 92:2444–2454. https://doi.org/10.3168/jds.2008-1734.

para prever o estado de energia corporal de vacas Holandesas. J. Dairy Sci. Soyeurt, H., P. Dardenne, F. Dehareng, G. Lognay, D. Veselko, M.

94:3651–3661. Marlier, C. Bertozzi, P. Mayeres e N. Gengler. 2006. Estimativa do teor de ácidos

McParland, S., E. Lewis, E. Kennedy, SG Moore, B. McCarthy, M. O'Donovan, ST graxos no leite de vaca usando espectrometria de infravermelho médio. J. Dairy

Butler, JE Pryce e DP Berry. 2014. Sci. 89:3690–3695. https://doi.org/10.3168/jds.S0022

Espectrometria de infravermelho médio do leite como preditor do consumo de -0302(06)72409-2.

energia e eficiência em vacas leiteiras em lactação. J. Dairy Sci. 97:5863–5871. Soyeurt, H., F. Dehareng, N. Gengler, S. McParland, E. Wall, DP

Mevik, BH, R. Wehrens e KH Liland. 2013. pls: Mínimos quadrados parciais e regressão Berry, M. Coffey e P. Dardenne. 2011. Previsão de infravermelho médio de ácidos

de componentes principais. Pacote R. versão 2.3-0. Acessado em 11 de agosto graxos do leite bovino em várias raças, sistemas de produção e países. J. Dairy

de 2022. http://www2.uaem.mx/r-mirror/ Sci. 94:1657–1667. https://doi.org/

web/packages/pls/pls.pdf. 10.3168/jds.2010-3408.

Møller, MF 1993. Um algoritmo de gradiente conjugado em escala para aprendizado Titterington, DM 2004. Métodos bayesianos para redes neurais e modelos relacionados.

supervisionado rápido. Rede Neural 6:525–533. https://doi.org/10 Estado. ciência 19:128–139. https://doi.org/10.1214/

.1016/S0893-6080(05)80056-5. 088342304000000099.

Muñoz, C., PA Letelier, EM Ungerfeld, JM Morales, S. Hube e LA Pérez-Prieto. 2016. ONU (Organização das Nações Unidas). 2019. Crescendo em um ritmo mais lento, a

Efeitos da massa de forragem pré-pastejo no final da primavera nas emissões de população mundial deve atingir 9,7 bilhões em 2050 e pode atingir um pico de

metano entérico, ingestão de matéria seca e produção de leite de vacas leiteiras. quase 11 bilhões por volta de 2100. Departamento de Assuntos Econômicos e

J. Dairy Sci. 99:7945–7955. https:// Sociais da ONU. Acessado em 25 de agosto de 2021. https://www.un.org/development/

/doi.org/10.3168/jds.2016-10919. desa/en/news/population/world-population-prospects-2019.html.

Okut, H., D. Gianola, GJM Rosa e KA Weigel. 2011. Previsão do índice de massa van der Drift, SGA, R. Jorritsma, JT Schonewille, HM Knijn e JA Stegeman. 2012.

corporal em camundongos usando marcadores moleculares densos e uma rede Detecção de rotina de hipercetonemia em vacas leiteiras usando análise de

neural regularizada. Genet. Res. (Camb) 93:189–201. https://doi.org/10.1017/ espectroscopia infravermelha com transformada de Fourier de ÿ-hidroxibutirato e

S0016672310000662. acetona no leite em combinação com informações do dia do teste. J. Dairy Sci.

Okut, H., X.-L. Wu, GJM Rosa, S. Bauck, BW Woodward, RD 95:4886–4898. https://doi.org/

Schnabel, JF Taylor e D. Gianola. 2013. Previsão da diferença esperada na 10.3168/jds.2011-4417.

progênie para escore de marmorização em gado Angus usando redes neurais van Knegsel, ATM, SGA van der Drift, M. Horneman, AP

artificiais e modelos de regressão bayesiana. Genet. Sel. W. de Roos, B. Kemp e EAM Graat. 2010. Concentração de corpos cetônicos no

Evolução 45:34. https://doi.org/10.1186/1297-9686-45-34. leite determinada por espectroscopia de infravermelho por transformada de

Perai, AH, H. Nassiri Moghaddam, S. Asadpour, J. Bahrampour e G. Mansoori. 2010. Fourier: valor para a detecção de hipercetonemia em vacas leiteiras. J. Dairy Sci.

Uma comparação de redes neurais artificiais com outras abordagens estatísticas 93:3065–3069. https://doi.org/10.3168/jds.2009

para a previsão do verdadeiro metabo -2847.

Journal of Dairy Science Vol. 105 Nº 10, 2022

Machine Translated by Google

Shadpour et al.: PREVENINDO DMI USANDO REDES NEURAIS 8271

Veerkamp, RF e S. Brotherstone. 1997. Correlações genéticas entre ORCIDAS

características de tipo linear, ingestão de alimentos, peso vivo e escore de

condição em bovinos leiteiros da raça Holstein Friesian. Anim. ciência

Saeed Shadpour https://orcid.org/0000-0002-2842-031X

64:385–392. https://doi.org/10.1017/S1357729800015976.

Tatiane CS Chud https://orcid.org/0000-0001-7559-1165

Wallén, SE, M. Lillehammer e THE Meuwissen. 2017. Estratégias para

implementação de seleção genômica para eficiência alimentar em esquemas Dagnachew Hailemariam https://orcid.org/0000-0002-0030-7729

Hinayah R. Oliveira https://orcid.org/0000-0002-0355-8902

de criação de gado leiteiro. J. Dairy Sci. 100:6327–6336. https://doi

.org/10.3168/jds.2016-11458. Graham Plastow https://orcid.org/0000-0002-3774-3110

Wallén, SE, E. Prestløkken, THE Meuwissen, S. McParland e DP Berry. 2018. Paul Stothard https://orcid.org/0000-0003-4263-969X

Dados espectrais de infravermelho médio do leite como uma ferramenta Jan Lassen https://orcid.org/0000-0002-1338-8644

para prever o consumo de ração em vacas leiteiras Norwegian Red em lactação.Resgate

j. Baldwin https://orcid.org/0000-0002-0753-4377

Dairy Sci. 101:6232–6243. https://doi.org/10.3168/jds.2017-13874. Filippo Miglior https://orcid.org/0000-0003-2345-8842

Wang, HJ, F. Ji, CS Leung e PF Sum. 2009. Seleção de parâmetros de Christine F. Baes https://orcid.org/0000-0001-6614-8890

regularização para redes neurais defeituosas. Int. J. Intel. Sist.

Dan Tulpan https://orcid.org/0000-0003-1100-646X